编辑 | 伊风

马斯克和甲骨文公司(Oracle)有个百亿的大订单谈崩了!双方互相甩锅了一波。

马斯克嫌弃甲骨文速度太慢,认为对方没有以可行的速度构建计算集群。

而甲骨文则觉得 xAI 选的建超级计算机的地方跟本供不上这么多电!

随着百亿订单的谈判破裂, xAI 和甲骨文停止了讨论扩大现有合作的可能性,只保留了当前合约的安排——xAI 将继续租用从甲骨文提供的约 16,000 颗 Nvidia 芯片。

xAI目前正在田纳西州孟菲斯市建设自己的人工智能数据中心。而与甲骨文的合作破裂意味着xAI要自己动手单干,通过10w Nvidia 的 H100 图形处理单元构建独立的算力中心,以摆脱甲骨文等云提供商能力的限制。

不过,以AI迅猛的发展势头来看,xAI的10万台H100只是打底。

回想上个月,X平台网友发起的一条讨论:哪家AI公司最快建成百万台H100的算力集群?

马斯克旗下的xAI高票当选。

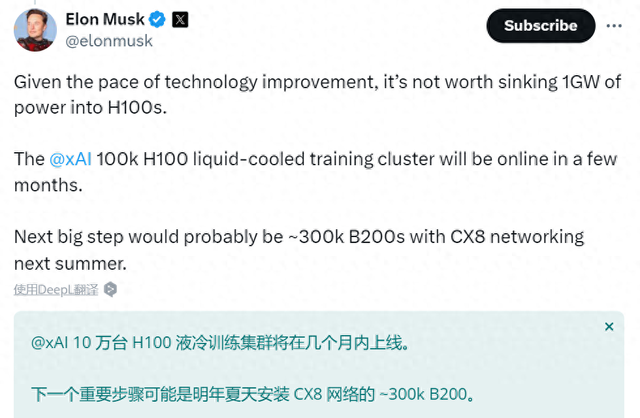

他回复道,由于技术进步飞速,不值得为H100浪费这么多电。

他已经计划在明年配置上30万台B200,同时使用先进的CX8高速网络互连技术。

图片

Nvidia表示,训练一个1.8万亿个参数的人工智能模型大约需要2000个Blackwell GPU(据说,这是 OpenAI 的 GPT-4 的估计大小)。相比之下,执行同样的任务需要8000个Hopper GPU。

根据Nvidia的数据推算,马斯克对明年的算力规划,相当于配齐120万台H100。

1.甲骨文名副其实“AI军火商”刚与微软达成50亿大单!10万颗英伟达GB200同样愿意为算力豪掷千金的还有微软。

根据The Information的报道,甲骨文与微软的交易已经签署了协议,将为合作伙伴OpenAI 提供 Nvidia 驱动的服务器。

据两位知情人士透露,甲骨文与微软的交易涉及一个由10万颗Nvidia即将推出的GB200芯片组成的集群。

这同样是一笔天价订单,据熟悉GPU云定价的人士称,假设两家公司签署了一份多年期协议,租用这样一个集群的成本可能会在两年内达到50亿美元左右。

2.黄仁勋的远虑:云服务商追不上英伟达的脚步不止是马斯克一个人在忧虑云服务商的效率。更加焦虑的还有黄仁勋。

今年,英伟达的市值一路飙至登顶。

但老黄始终在担心云服务提供商的速度掉队问题。他怀疑,公司的主要客户,尤其是亚马逊、微软等,是否在以足够的速度扩建数据中心和电力中心,以容纳向英伟达订购的人工智能服务器芯片。

去年圣诞节期间,黄仁勋特意召集高层管理人员开会讨论这个问题,因为他担心主要客户的数据中心容量不足将影响英伟达的销售额。

在讨论之后,英伟达决定大力“鸡”服务商——整个管理层加强了对云提供商的询问,要求他们澄清处理订购的 GPU 的能力和能源供应情况。

3.有算力没电力的尴尬AI或许能做很多令我们惊叹的事情。但一个不容忽视的事实是,目前为止碳基生命比硅基生命要节能得多。

据报道,谷歌自 2019 年以来,排放量增加了 48%。而碳排放的疯狂上涨,很大程度上是因为人工智能的训练和使用。

人工智能对电力的需求已成为一个令人担忧的问题。

今年 1 月,国际能源机构估计,到 2026 年,全球数据中心的能耗将翻一番。同时,高盛公司 2024 年 4 月的一份分析报告预测,到本十年末,全球数据中心用电量将增加 1.8 倍至 3.4 倍。

不过,也有人对这种预测提出了质疑。今年二月,美国智库信息技术与创新基金会的数据创新中心(CDI),认为人们过分夸大了人工智能的长期排放影响。该组织认为,过去曾试图准确预测新兴技术的能源需求,但都以失败告终——许多预测都没有考虑硬件和软件在未来的改进。

参考链接:1.https://www.theinformation.com/articles/musks-xai-and-oracle-end-talks-on-a-server-deal?utm_campaign=article_email&utm_cnotallow=article-13188&utm_medium=email&utm_source=sg

2.https://www.theinformation.com/articles/nvidias-jensen-huang-is-on-top-of-the-world-so-why-is-he-worried

来源: 51CTO技术栈