引用

Gontijo-Lopes Raphael, Smullin Sylviz, Cubuk Ekin D, et al. Tradeoffs in Data Augmentation: An Empirical Study[C]//International Conference on Learning Representations. 2020.

摘要

虽然数据增强已经成为深度神经网络训练的标准组成部分,但关于这些技术的有效性,背后的潜在机制仍然知之甚少。在实践中,通常使用分布转移或扩增多样性的启发式方法来选择增强策略。本文进行了实证研究,对数据增强如何改善模型的泛化性进行量化。本文介绍了两个可解释且易于计算的度量:亲和性和多样性。作者发现,增强性能与联合优化这两种度量相关。

1.引言

在图像分类中最先进水平的模型通常使用大量的数据扩增策略。目前最好的扩增技术使用顺序和随机应用的各种变换。虽然这种方法的有效性已经得到了很好的证实,但这些转换的工作机制还没有得到很好的理解。

人们认为数据增强是有效的,因为它模拟了来自真实数据分布的真实样本:“(增强策略)是合理的,因为转换后的参考数据非常接近原始数据。这有效地增加了训练数据的数量”。正因为如此,数据扩增的设计通常采用从训练数据产生最小分布偏移的启发式方法。

这一基本原理并不能解释:为什么不现实的变换,如 cutout、SpecAugment 和 mixup 能显著提高泛化性能。上述方法并不总是跨数据集传输,如 cutout 在 CIFAR-10 上有效,而在 ImageNet 上无效。此外,许多增强策略通过对单个图像随机应用多个变换,对图像进行大量修改。基于这一观察,一些人提出增强策略是有效的,因为它们增加了模型所看到的图像的多样性。

关于多样性和分布相似性的主张仍然没有得到验证。如果没有更精确的数据扩充科学,找到最先进的策略需要耗费数千 GPU 小时蛮力搜索。这表明需要指定和测量原始训练数据和扩增数据集之间的关系,因为这与给定模型的性能有关。

本文对这些启发式方法进行了量化。为了理解增强的机制,本文重点以单个转换为基础。作者对 CIFAR-10 和 ImageNet 上的 204 种不同的增强进行了实证研究,改变了广泛的变换族和精细的变换参数。为了更好地理解当前最先进的增强策略,作者在 ImageNet 上测量了 58 个复合增强,在 CIFAR-10 上测量了 3 个最先进的增强。

2.方法

作者在 CIFAR-10 和 ImageNet 上进行了大量的增强实验。CIFAR-10 上的实验使用 WRN-28-2 模型,训练 78k 步,使用余弦学习速率衰减。结果是 10 次初始化的平均值,报告的误差是平均值的标准误差。

在 ImageNet 上的实验使用 ResNet-50 模型,训练 112.6k 步,其权重衰减率为 1e-4,学习速率为 0.2,在 30、60 和 80 代衰减 10。

对图像进行预处理,将每个像素值除以 255,并根据数据集统计数据进行归一化。所有的 ImageNet 模型都采用随机裁剪。这些未经进一步增强的预处理数据称作“干净数据”,在此基础上训练的模型是“干净基线”。作者遵循 Cubuk 等人在论文《Autoaugment: Learning augmentation policies from data》中相同的实现细节,包括大多数增强操作。

除非另有说明,否则数据增强是按照标准做法应用的:每次绘制图像时,给定的增强以给定的概率应用,即动态增强模式。由于变换本身的随机性和策略中的随机性,每次增强图像都可能不同。因此,大多数测试的增强都增加了训练过程中不同图像的数量。

作者还通过静态增强训练进行了选择性实验。在静态增强中,增强策略(一个或多个转换)对整个干净训练集应用一次。静态增强不会改变数据集中唯一图像的数量。

2.1亲和性;分布位移的简单度量

分配转移的启发式方法刺激了增强政策的设计。作者受启发引入了一个简单的度量,来量化关于干净基线模型的决策边界的增强,应该如何移动数据。

作者首先注意到,训练过的模型通常对训练数据的分布很敏感。也就是说,来自真实数据分布的新样本,和来自分布位移的样本之间的模型性能差异很大。

重要的是,由于训练动力学和模型的隐含偏差影响性能,模型对分布变化的敏感性不仅仅是输入数据分布的函数。因为增强的目标是改进模型的性能,所以测量模型捕获的分布位移,比只测量输入数据分布的位移更有意义。

定义 1。设 Dtrain 和 Dval 训练和验证数据集从相同的干净数据分布中提取 IID,并设 D'val 通过对 Dval 中的每一张图像应用随机增强策略 a,一次从 Dval 中派生,D'val = {(a(x),y):∀(x,y)∈Dval}。进一步设 m 为 Dtrain 上训练的模型,A(m, D)表示模型在数据集 D 上评估时的精度。亲和性 T[a;m;Dval]为:

在这个定义中,亲和性为 1 表示没有位移,数值较小则表示增强数据超出了模型的分布范围。

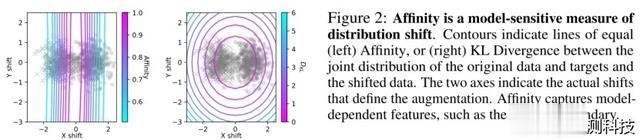

在图 2 中,作者用两个高斯混合的两类分类任务来说明亲和性。本例中的增强包括变化验证数据的高斯均值与训练数据的高斯均值。在这种变换下,作者计算了变换后的数据相对于原始数据的亲和性和 KL 散度。只有在数据的移动与模型的决策边界有关时,亲和性才会发生变化,而即使在数据向与分类任务无关的方向移动时,KL 散度也会发生变化。通过这种方式,亲和性捕捉到与模型相关的内容:影响预测的变化。

亲和性指标有以下优点:

1.它很容易测量。它只需要对模型进行干净的训练。

2.它独立于数据增强和训练过程之间的任何混淆交互,因为增强仅用于验证集并且是静态地应用。

3.它是对数据分布和模型属性敏感的距离度量。

2.2 多样性:数据增强复杂度度量

在观察到诸如 FlipLR+Crop+Cutout 和 RandAugment 等多因素增强策略能大大提高性能后,作者提出了另一个观察增强策略的轴,并将其命名为多样性。这一度量旨在量化:数据增强通过增加训练集中的样本数量,来防止模型过拟合的程度。

更多样化的数据对模型来说应该更难以拟合,该直觉使作者提出了基于模型的度量。本文中的多样性度量,是在给定增强条件下训练的模型的最终损失,与在干净数据上训练模型的最终损失之比。

定义 2。设 a 为扩增量,D’train 为随机应用增广量 a 得到的增广训练数据。设 Ltrain 为模型 m 在 D’train 上的训练损失。多样性定义为

与亲和性一样,多样性定义的优点是它可以捕获模型依赖的元素,即它由选择模型和优化方案时隐含的先验类别,以及训练中使用的停止标准决定。

上述方法的缺点是评估的计算成本。对于每个感兴趣的增强策略,必须训练一个独立的模型,计算训练损失的成本与决定最终测试的准确性一样高。在某些情况下,这种成本可能不是问题。例如,许多成功的增强策略可用于广泛的模型。这种可重用性有助于降低初始搜索成本。在这里将此指标作为理解的工具。

带有更多自由度的扩增会表现得更好,受此启发,另一个可能适用的多样性度量是转换数据的熵 Dent。对于离散变换,设数据增强的条件熵:

其中 x∈X 是一个干净的训练图像,x’∈X’是一个增强图像。这个度量的属性是,它可以在没有任何模型体系结构训练或参考的情况下进行评估。

在其余部分中,作者将描述如何使用多样性和亲和性的互补度量来描述和理解增强性能。

3.结果

3.1 增强性能由亲和性和多样性共同决定

图 3(a)(左)分别测量了 CIFAR-10 的 204 个不同增强和 ImageNet 的 223 个增强的亲和性。作者发现,对于有助于性能的增强,亲和性准确性很差。此外,作者还发现了许多具有低亲和性的成功增强实例。

由于亲和性不能完全描述增强的性能,所以需要寻求另一个度量。为了评估增强导致复杂的重要性,通过相同的增强集度量多样性。作者发现多样性在解释增强如何提高测试性能方面是互补的。如图 3(b)和(c)所示,亲和性和多样性一起提供了一个更清晰的参数来说明增强策略对性能的好处。对于固定的多样性水平,具有更高亲和性的增强总是更好。类似地,对于固定的亲和性,通常最好拥有更高的多样性。为了使其更定量,作者考虑了成对的扩增策略(a, a’),并测量满足如下条件的对比例:

图 4 给出了一个简单的案例研究。Rotate(固定,60 度)的最佳概率位于亲和性和多样性的中间值。

为了将测试过的增强置于最新的背景下,作者从文献中测试了三种高性能增强:mixup、AutoAugment 和 RandAugment。这些在图 3(b)中用星号标记突出显示。

亲和性和多样性比任何一个指标单独提供了一个增强性能的参数化。现在,作者转而研究这个工具在解释其他观测到的数据扩充现象时的效果。

3.2.适时关闭增强可能会改变亲和性、多样性和性能

术语“正则化器”在文献中定义不明确,通常指任何用于减少泛化误差而不一定减少训练误差的技术。人们普遍认为常用的扩增函数充当了正则化器。尽管这是一个宽泛的定义,但作者注意到不同正则化器的另一共性:各种正则化技术在正确的时间关闭可以提高性能(或至少不会降低性能)。

为了进一步研究作为正则化器的增强,作者将持续增强的情况,和增强在训练过程中中途关闭,并且使用干净的数据完成训练的情况作比较。对于每个转换,作者在一系列开关点上进行测试,并分别选择在 CIFAR-10 和 ImageNet 上产生最佳最终验证或测试精度的开关点。与在整个过程中使用增强数据进行训练相比,“Switch-Lift”可以提高最终测试的准确性。

对于一些性能较差的增强,这种增益实际上可以使测试精度高于基线,如图 5(b)所示。此外可以观察到(图 5(a)),这种测试精度的提高可以产生极为迅速的增强。这说明可以通过适当地关闭正则化,在不影响表现的情况下加速训练。作者称之为弹弓效应。

3.3.增加有效训练集的大小是数据增强的关键

为了进一步研究扩增如何充当正则化器,作者试图将有效数据集大小的增加与其他效应分隔开来。作者使用静态增强训练模型,在训练过程中使用改变过的训练集而不作进一步修改,这样在增强训练设置和干净训练设置之间唯一训练数据输入的数量是相同的。

对于几乎所有测试的增强,使用静态增强产生的测试精度低于干净基线。当静态增强显示增益时,其差值小于平均标准误差。与动态情况一样,具有较低亲和力和较低多样性的转换在静态情况下的性能较差。

静态增强也总是比不确定性的动态增强表现得更差,如图 6 所示。这可能是因为静态增强的多样性总是小于动态情况。静态情况中多样性的减少表明多样性和训练示例的数量之间存在联系。

总之,这些结果可以得出:增加有效训练集的大小对数据增强的性能效益至关重要。

4.结论

更多的分布和更多样化的增强策略表现应该更好。作者因此量化引入了两个易于计算的指标:亲和性和多样性,以分别衡量给定的增强在分布中的程度,和要学习的增强有多复杂。因为它们依赖于模型,所以这些度量可以捕捉影响模型性能的数据位移。本文研究对继续进行数据增强和更广泛分布变化的科学研究具有重要意义。

致谢

本文由南京大学软件学院 2021 级硕士潘中颢翻译转述。

审核人:南京大学软件学院博士 刘佳玮