这里所有文章均来自

微信公众号“火星AIGC”

想要看到更多更新的AI前沿信息、AI资讯和AI工具实操,请关注微信公众号“火星AIGC”。

在 OpenAI 和谷歌发布新的旗舰级多模态大模型后,掉车尾的 Meta 也跟着推出了他的多模态基础模型 Chameleon ,这是首个进行多模态融合训练的大模型。Meta 的意思是虽然我赶不上你们,但我的思路才是最先进的、最open的,并且看论文的细节是要在开源这条路上把前两者比下去。

一、变色龙模型简介

Chameleon 是 Meta 的 FAIR(Facebook AI Research)团队开发的一种突破性的混合模态早期融合基础模型,它无缝集成了文本和图像处理。与传统模型分别处理文本和图像不同,Chameleon 从一开始就将文本和图像一起训练,可以直接输出文本和图像的混合结果。

Chameleon的核心创新在于“早期融合”的方法。与其他模型将文本和图像分别编码再进行后期融合不同,Chameleon从一开始就将文本和图像投影到同一个表示空间中,通过单一的Transformer架构对两种模态进行统一的建模和处理。这种全新的范式,让Chameleon在理解和生成混合的文本图像内容时,展现出了独一无二的能力。

文本标记用绿色 表示,图像标记用蓝色表示

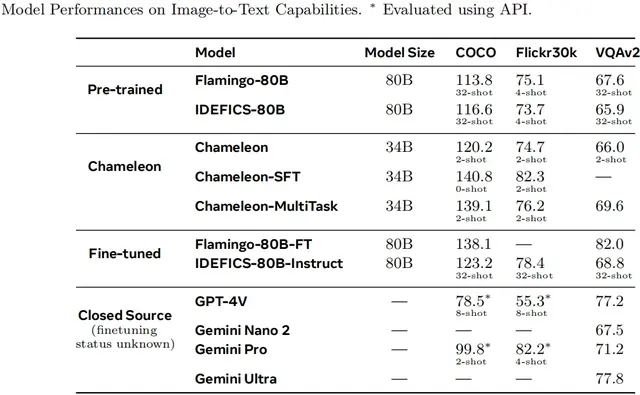

340亿参数的Chameleon在多项评测任务上取得了突破性的表现。它在视觉问答、图像标注等视觉任务上超越了Flamingo、Llava-1.5 等知名模型;同时在纯文本生成、常识推理等语义任务上,也与大型语言模型Mixtral和Gemini-Pro不相上下。最令人振奋的是,Chameleon擅长处理需要同时理解文本和图像才能完成的复杂任务,在这种混合模态场景下,它明显优于其他模型。

二、变色龙的训练方法

要训练出如此强大的多模态模型,Meta AI团队付出了巨大的努力。Chameleon采用了分两阶段的训练策略:第一阶段使用了大规模的无监督文本和图像数据进行预训练;第二阶段将第一阶段数据的权重降低了50%,并在更高质量的数据集中混合,同时保持相似比例的图像和文本令牌,在高质量的监督数据集上进行指令精调,确保其能理解和执行各种具体的指令。

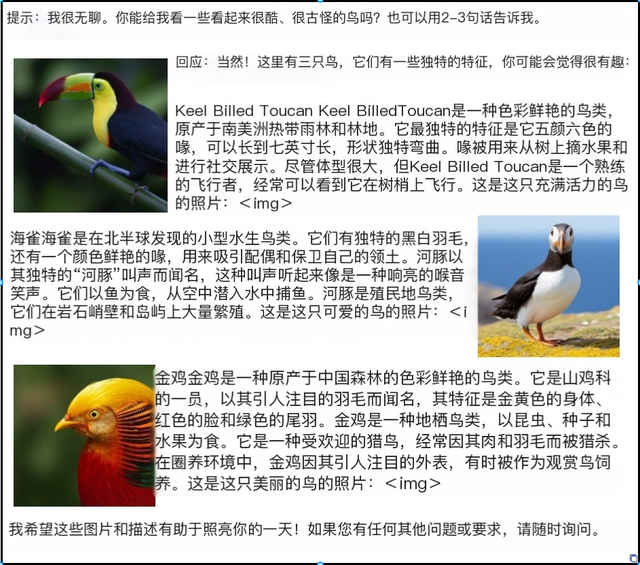

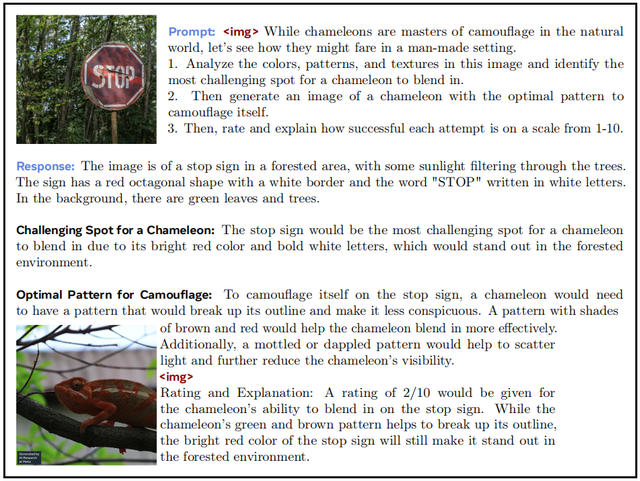

变色龙模型的样本生成

培训过程中,研究人员还必须应对一系列技术挑战。由于需要处理10万亿个图像和文本的融合tokens,确保如此庞大模型的训练过程稳定和可控是一大难题。为此,研究人员提出了多项创新方法,比如查询键规范化(QK-Norm)来控制规范增长、针对模型大小调整Dropout和Z-loss正则化策略等。

从硬件资源上看,Chameleon的训练历时数月,采用 NVIDIA A100 80GB GPU 进行训练, Chameleon-7B 在1024 个 GPU上花费85万 小时,Chameleon-34B 在 3072 个 GPU 上花费428万小时。

三、对齐策略及安全测试

优秀的大模型不仅需要有强大的功能,确保其输出内容的质量、对齐度和安全性也至关重要。为此,Meta AI采用了行之有效的监督微调(SFT)技术,从文本、代码、视觉对话、图像生成、文本和图像交织生成和安全等多个维度,使用高质量的对话数据对Chameleon进行人工指导,使其输出符合人类的期望。

在具体实施时,由于采用多模态融合训练,所有模态共享权重,在训练种每个模态都想“多吃多占”。研究人员为了在对齐种保持平衡模式,避免模型过度偏好某些类型,采用余弦学习率调度、重点优化答案标记等优化策略,以提高微调效率。最终通过大量的人类评估和安全测试,证实了Chameleon的输出质量和安全性。

四、评估和未来前景

在纯文本模型的基准评估涵盖常识推理、阅读理解、数学问题和世界知识等领域。常识推理和阅读理解种 Chameleon-34B 优于或匹配较大的模型,如 Llama-2 70B。数学和世界知识中 Chameleon-34B 在 GSM8k 和 MMLU 等基准测试中表现出色。

在图像到文本的评估中采用 MS-COCO 和 Flickr30k 等数据集。Chameleon-34B在图像字幕和视觉问答等任务中上优于或匹配 Flamingo 80B 等大型模型。

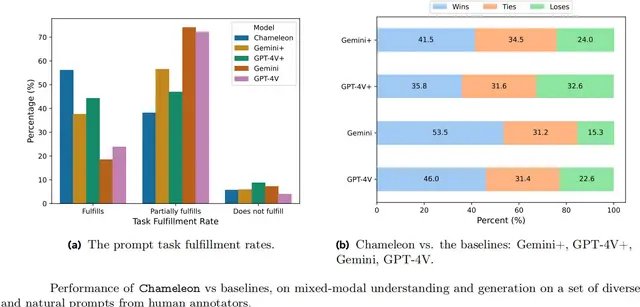

在人类评估和安全测试中,收集了涵盖纯文本和混合模式格式的 1,048 个提示。将 Chameleon 34B 与 OpenAI GPT-4V 和 Google Gemini Pro 进行比较,在回答相关性和质量评判的绝对评价中,Chameleon 表现更好,55.2% 的响应完全完成任务,而 Gemini+ 为 37.6%,GPT-4V+ 为 44.7%。在相对评价中 Chameleon 的反应在41.5%的情况下优于Gemini+,在35.8%的情况下优于GPT-4V+。

不过,Chameleon 最与众不同的,莫过于其开创性地处理复杂的多模态内容的能力。比如根据文本和图像生成新的多模态输出、回答涉及图文的混合问题等,这种全新的交互模式为人工智能的应用拓展了更广阔的空间。

变色龙模型输出示例

目前,Chameleon 还没有正式发布,也没有语音视频模态,但毫无疑问,Chameleon开创了多模态人工智能发展的新里程碑,指出了多模态AI模型的新思路。与此同时,硅谷的对手OpenAI也于不久前发布了GPT-4o,这是另一款备受瞩目的多模态大模型。两者在底层架构、训练数据和具体能力上都存在差异,但它们的出现都预示着人工智能发展进入了一个新阶段。未来,随着多模态模型的不断演进,人类与计算机之间的交互方式也将发生革命性的变化。