NVIDIA DGX H100系统是一种专为AI基础架构和工作负载而设计的专用多功能解决方案,涵盖了从分析和训练到推理的各种应用场景。它包括NVIDIA Base Command™和NVIDIA AI企业软件套件,以及来自NVIDIA DGXperts的专业建议。

DGX H100硬件和组件特性硬件概述NVIDIA DGX H100 640GB系统包括以下组件。

前面板连接和控制

前面板连接和控制左侧是带有面板的DGX H100系统,右侧是不带面板的DGX H100系统。

DGX H100后面板模块。

尺寸:8U机架安装,高度0.4m,最大宽度0.5m,最大深度0.9m。重量:最大287.6lbs(130.45kg)。输入电压:200-240V交流电。电源规格:最大10.2KW,200-240V3300W,16A,50-60Hz。支持高速网络连接,包括InfiniBand和以太网,速度高达400Gbps。外部端口连接和控制

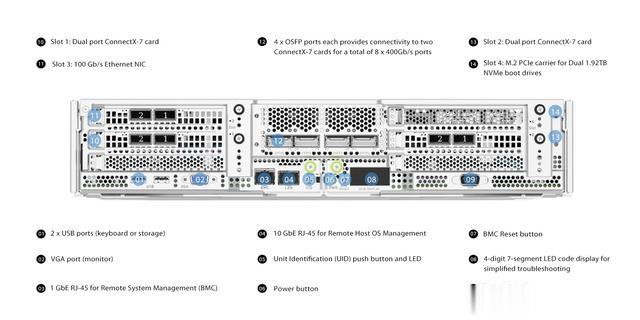

尺寸:8U机架安装,高度0.4m,最大宽度0.5m,最大深度0.9m。重量:最大287.6lbs(130.45kg)。输入电压:200-240V交流电。电源规格:最大10.2KW,200-240V3300W,16A,50-60Hz。支持高速网络连接,包括InfiniBand和以太网,速度高达400Gbps。外部端口连接和控制下图示展示了DGX H100系统中主板的连接和控制。

插槽1:双端口ConnectX-7网卡插槽2:双端口ConnectX-7网卡插槽3:100 Gb/s以太网网卡插槽4:用于双1.92TB NVMe启动驱动器的M.2 PCle载板2个USB端口(用于键盘或存储设备)串口输入/输出端口VGA端口(用于显示器)1 GbE RJ-45用于远程系统管理10 GbE RJ-45用于远程主机连接主板托盘组件

插槽1:双端口ConnectX-7网卡插槽2:双端口ConnectX-7网卡插槽3:100 Gb/s以太网网卡插槽4:用于双1.92TB NVMe启动驱动器的M.2 PCle载板2个USB端口(用于键盘或存储设备)串口输入/输出端口VGA端口(用于显示器)1 GbE RJ-45用于远程系统管理10 GbE RJ-45用于远程主机连接主板托盘组件CPU主板托盘是服务器的核心组件,包括标准服务器和专为人工智能设计的服务器。它包含了CPU主板、系统内存、网卡、PCIE交换机和其他各种组件。下图显示DGX H100主板托盘组件。

系统内存:每个32个DIMM插槽提供2 TB的内存。带外系统管理(BMC):支持Redfish、IPMI、SNMP、KVM和Web用户界面。字带内系统管理:3个双端口100GbE和10GbE RJ45接口。机械和电源规格。存储: 操作系统存储:2个1.92TB NVMe M.2固态硬盘(RAID 1阵列)。 数据缓存存储:8个3.84TB NVMe U.2加密固态硬盘(RAID 0阵列)。

系统内存:每个32个DIMM插槽提供2 TB的内存。带外系统管理(BMC):支持Redfish、IPMI、SNMP、KVM和Web用户界面。字带内系统管理:3个双端口100GbE和10GbE RJ45接口。机械和电源规格。存储: 操作系统存储:2个1.92TB NVMe M.2固态硬盘(RAID 1阵列)。 数据缓存存储:8个3.84TB NVMe U.2加密固态硬盘(RAID 0阵列)。 网络: 集群网络:4个OSFP端口,支持InfiniBand(高达400Gbps)和以太网(高达400GbE)。 存储网络:2个NVIDIA ConnectX-7双端口以太网网卡,支持以太网(高达400GbE)和InfiniBand(高达400Gbps)。GPU托盘组件

网络: 集群网络:4个OSFP端口,支持InfiniBand(高达400Gbps)和以太网(高达400GbE)。 存储网络:2个NVIDIA ConnectX-7双端口以太网网卡,支持以太网(高达400GbE)和InfiniBand(高达400Gbps)。GPU托盘组件下图显示DGX H100系统中GPU托盘组件。

图形处理器:8个NVIDIA H100 GPU,提供640 GB的GPU内存。

图形处理器:8个NVIDIA H100 GPU,提供640 GB的GPU内存。 NVLink:4个第四代NVLink,提供900 GB/s的GPU到GPU带宽。

NVLink:4个第四代NVLink,提供900 GB/s的GPU到GPU带宽。GPU板托盘是AI服务器的关键组装区域。其核心是GPU板托盘,包括GPU组件、模块板和NVSwitch等重要部分。

DGX H100系统拓扑结构以下是DGX H100系统的拓扑结构图,展示了系统内各种硬件组件之间的连接、配置和相互关系。

DGX H100的功能优势

DGX H100的功能优势人工智能已成为应对复杂商业挑战的理想解决方案。对于企业而言,人工智能不仅关乎性能和功能,还与组织的IT架构和实践密切集成。作为人工智能基础设施的先驱者,英伟达(NVIDIA)的DGX系统提供了强大和全面的人工智能平台。

该系统经过专业设计,优化人工智能吞吐量,为企业提供了一个高度精细、系统化组织且可扩展的平台,以实现自然语言处理、推荐系统、数据分析等领域的突破。

DGX H100提供了灵活的部署选择,无论是在本地进行直接管理,还是在NVIDIA DGX-Ready数据中心进行共享,通过NVIDIA DGX Foundry租用,或通过经过NVIDIA认证的托管服务提供商进行访问。DGX-Ready生命周期管理计划确保组织拥有可预测的财务模型,使其部署始终处于技术的前沿。这使得DGX H100与传统的IT基础设施一样易于操作和访问,减轻IT人员的额外负担。