美国加利福尼亚州10月10日,AMD Advancing AI 2024在旧金山Moscone Center举行,这是当地最大的会议和展览综合体。AMD当天的活动,数百名开发者到达现场参加,及国内几家行业媒体受邀参加了这次活动。

这是AMD今年在AI领域非常重要的一次发布,特别是面向数据中心,CPU、GPU、网络技术这三大方向的最新进展,堪称是AMD的里程碑式突破,为AMD在数据中心下一阶段的发展打下坚实基础。

1530亿晶体管、HBM3E内存,性能怪兽AMD Instinct MI325X来袭AMD于去年12月推出了Instinct MI300X加速器,这是AMD历史上销售业绩表现增速惊人的产品,不到两个季度内,销售额就超过了10亿美元。此外,业界普遍认为这是首个真正能与NVIDIA在AI加速领域竞争,甚至实现了性能赶超的产品。 今年7月,AMD 2024年Q2财报发布后,AMD董事会主席及首席执行官Lisa Su博士强调,客户对于Instinct系列和ROCm的路线图反响积极,AMD很满意目前在GPU领域的发展势头。预计数据中心GPU收入在2024年将超过45亿美元,高于4月份预期的40亿美元。 Advancing AI 2024上,AMD推出了下一代Instinct MI325X。它采用了和上一代MI300X同样的CDNA 3架构,配备了256GB HBM3E内存,能够实现6TB/秒的本地内存带宽。

1530亿晶体管、HBM3E内存,性能怪兽AMD Instinct MI325X来袭AMD于去年12月推出了Instinct MI300X加速器,这是AMD历史上销售业绩表现增速惊人的产品,不到两个季度内,销售额就超过了10亿美元。此外,业界普遍认为这是首个真正能与NVIDIA在AI加速领域竞争,甚至实现了性能赶超的产品。 今年7月,AMD 2024年Q2财报发布后,AMD董事会主席及首席执行官Lisa Su博士强调,客户对于Instinct系列和ROCm的路线图反响积极,AMD很满意目前在GPU领域的发展势头。预计数据中心GPU收入在2024年将超过45亿美元,高于4月份预期的40亿美元。 Advancing AI 2024上,AMD推出了下一代Instinct MI325X。它采用了和上一代MI300X同样的CDNA 3架构,配备了256GB HBM3E内存,能够实现6TB/秒的本地内存带宽。

根据AMD公布的数据,Instinct MI325X的容量比NVIDIA H200增加 1.8 倍,带宽提升 1.3 倍。与 H200相比,Instinct MI325X 在 FP16 和 FP8 的峰值理论计算性能上分别提升了 1.3 倍、2.6倍。从这些数据来看,Instinct MI325X在基础模型训练、微调和推理方面将达到更高性能,有助于用户在系统、机架和数据中心级别创建更高性能的AI 解决方案。

相较于H200,MI325X在运行Mixtral 8x7B 时可提供 1.4 倍的推理性能(FP16),运行Mistral 7B时可提供1.3 倍的推理性能(FP16),运行Llama 3.1 70B 时可提供 1.2 倍的推理性能(FP8)。

AMD的CDNA3架构已经在MI300系列中得到了验证,它在性能、效率和可编程性都达到了新的高度,通过采用3D封装技术,它重新分配了处理器中的计算、内存和通信元素,形成了异构封装。这种对物理实现的全新设计,帮助AMD显著提升计算和存储等关键能力。 AMD Instinct MI325X预计于今年Q4开始生产出货,并预计在 2025 年Q1,包括 Dell Technologies、Eviden、Gigabyte、Hewlett Packard Enterprise、Lenovo、Supermicro 等多家平台供应商将会广泛提供相应的产品。 此外,Instinct未来两年的产品路线图也在此次大会上予以公布,基于CDNA 4的MI350系列或将于2025年下半年发布,它将继续在内存容量方面保持领先,每个加速器可支持高达 288GB 的 HBM3E 内存,同时也将会比基于CDNA 3的加速器实现35倍的推理性能提升。2026年,更具雄心的MI400系列或将推出,该系列将会基于CDNA“下一代”架构。

构建生成式AI所需的网络能力:Pensando Salina DPU+ Pensando Pollara 400应对生成式AI所带来的大规模计算集群的显著增长趋势,超大规模数据中心的网络能力越来越成为计算性能提升的关键。AMD正在通过可编程DPU提供下一代AI网络支持。该网络主要包括两部分:前端负责向AI集群传递数据和信息,后端则管理加速器与集群之间的数据传输。 为了有效管理这两部分网络,并在整个系统中实现高性能、可扩展性和高效率,AMD推出了Pensando Salina DPU作为前端,以及行业首款符合超以太网联盟(UEC)标准的AI网络接口卡(NIC)——Pensando Pollara 400作为后端。

构建生成式AI所需的网络能力:Pensando Salina DPU+ Pensando Pollara 400应对生成式AI所带来的大规模计算集群的显著增长趋势,超大规模数据中心的网络能力越来越成为计算性能提升的关键。AMD正在通过可编程DPU提供下一代AI网络支持。该网络主要包括两部分:前端负责向AI集群传递数据和信息,后端则管理加速器与集群之间的数据传输。 为了有效管理这两部分网络,并在整个系统中实现高性能、可扩展性和高效率,AMD推出了Pensando Salina DPU作为前端,以及行业首款符合超以太网联盟(UEC)标准的AI网络接口卡(NIC)——Pensando Pollara 400作为后端。

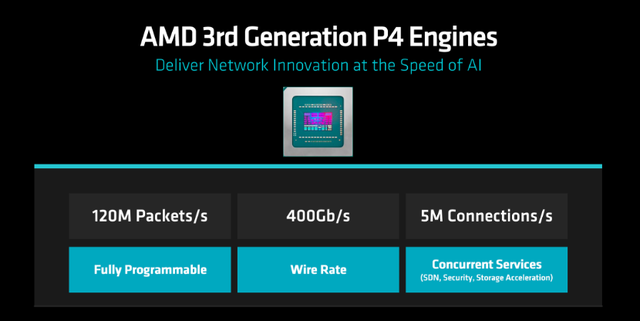

Pensando Salina DPU是AMD可编程DPU的第三代产品,相比上一代,其性能、带宽和扩展性提高了2倍,支持400G吞吐量。可实现快速数据传输的Pensando Salina DPU在AI前端网络集群中至关重要,优化了数据驱动AI应用的性能、效率、安全性和可扩展性。 Pensando Pollara 400搭载了AMD P4可编程引擎,是行业首款符合UEC标准的AI NIC。它支持下一代RDMA软件,并由开放的网络生态系统支持,能够在后端网络中对加速器之间的通信提供了领先的性能、可扩展性和效率。

成立于去年夏天的UEC在迅速壮大,目前已经超过97家成员。该联盟致力于构建基于以太网的统一通信堆栈,以支持AI和HPC数据中心的高性能网络连接需求。该联盟的技术目标包括开发超以太网通信的规范、API 和源代码,更新现有协议,以及引入用于遥测、信令、安全和拥塞管理的新机制。 基于这些实现方式,UEC希望为业界在NVIDIA InfiniBand之外提供一种新的选择。根据AMD最新公布的数据,以太网RoCEv2方案比NVIDIA InfiniBand可实现50%的TCO降低;在更大规模的GPU集群连接方面,灵活性也极大提升,比起Infiniband最多4.8万个GPU,以太网RoCEv2方案可支持超过100万个GPU。

今年Q4,Pensando Salina DPU和Pensando Pollara 400将与客户进行样品测试,预计在2025年上半年正式上市。

第五代AMD EPYC亮点密集:3/4nm、192核、5GHz频率根据最新的Mercury研究报告,AMD目前拥有34%的服务器CPU份额,达到了AMD史上新高。Lisa Su强调,AMD已经在数据中心基础设施领域形成了深厚积淀,CPU一直在稳健增长。经过五代产品的更迭,如今,AMD EPYC CPU正在驱动下一个创新浪潮,更高效地为数据中心和IT环境创造价值。

第五代AMD EPYC处理器代号Turin,采用Zen 5架构,兼容广泛部署的SP5平台,核心数量范围从8核最多可到192核。相比于Zen 4,Zen 5架构在企业和云工作负载中,可提供最高17%的IPC提升,而在AI和高性能计算(HPC)中IPC提升可达37%。

在前几代的基础上,AMD EPYC 9005系列处理器进一步提升了性能和能效,最高配置的192核CPU,性能相比竞争对手提升高达2.7倍。其主要特性包括:

每个CPU提供8至最多192的核心数量选择,采用“Zen 5”和“Zen 5c”核心架构每个CPU支持12个通道的DDR5内存支持最高DDR5-6400 MT/s领先的加速频率高达5GHz支持AVX-512,具有完整的512b数据通道可信的I/O用于保密计算,系列中每个部件均在进行FIPS认证

该系列的64核的AMD EPYC 9575F专为需要强大主机CPU能力的GPU驱动AI解决方案量身打造,可提供最高5GHz的频率,相较于竞争对手3.8GHz的处理器,处理速度提升28%。并且,可助力1000节点的AI集群每秒处理多达70万token,更高效地完成更多任务。 采用AMD EPYC 9575F和MI300X的方案,与Intel 至强8592+和MI300X的方案相比,训练和推理性能分别可实现20%和8%的提升。

采用AMD EPYC 9575F和NVIDIA H100的方案,与Intel 至强8592+和NVIDIA H100的方案相比,训练和推理性能分别可实现15%和20%的提升。

根据AMD公布的最新资料,第五代AMD EPYC处理器在商业IT的各种服务器工作负载方面优势也在提升。使用基于AMD EPYC 9965处理器的服务器,与基于Intel Xeon 8592+ CPU的服务器相比,有如下优势:

在视频转码等业务应用中,结果生成时间提高最多4倍。在解决全球最具挑战性问题的科学和HPC应用中,洞察时间提高最多3.9倍。在虚拟化基础设施中,每核性能提高最多1.6倍。除了在通用工作负载中的性能和效率提升外,第五代AMD EPYC处理器还能够快速实现AI部署,无论是运行CPU还是CPU+GPU解决方案。与竞争对手相比,192核EPYC 9965 CPU在端到端AI工作负载(如TPCx-AI)上,性能提高最多3.7倍,这对推动高效的生成式AI方法至关重要。在中小型企业级生成式AI模型(如Meta的Llama 3.1-8B)中,EPYC 9965的吞吐量性能提高1.9倍。

第五代AMD EPYC处理器的全系列产品现已上市,得到了Cisco、Dell、Hewlett Packard Enterprise、Lenovo和Supermicro以及所有主要ODM和云服务提供商的支持。通过采用这些新处理器,客户可在现代化数据中心,实现391,000个SPECrate @2017_int_base通用计算性能,获得出色的多种工作负载性能,同时估计可节省71%的功耗和约87%的服务器数量。

AMD端到端AI布局全面强大通过全面的布局,AMD端到端的AI布局已经全面成型且逐渐强大。 除了面向数据中心的产品发布,AMD还在这次大会上推出了最新的锐龙 AI PRO 300系列商用移动处理器,这也是其适用于AI PC的第三代商用处理器,可为Windows Copilot+PC提供最高至55 TOPs AI算力的处理能力,这一出色性能也使得该处理器成为了行业新标杆。 正如Lisa Su在会上所说,接下来的十年,AI还会带来很多全新的体验,计算会成为生活中更重要的一部分。一直以来,AMD在硬件上花了很多时间,而这才是提供AI完整路线图的根本所在。如今,纵观AMD的整个投资组合,全面的硬件产品线、开放的软件生态等等,正在推动AMD成为端到端的AI领导者,打造更为有力的AI基础设施解决方案。