随着人工智能的发展,现在人工智能已悄然成为我们生活的一部分,从日常助手到深度交流的伙伴,其影响力不容小觑。

然而,一起令人痛心的事件促使我们重新思考这项技术背后的伦理责任与安全界限——一名14岁的少年塞维尔·塞策三世(Sewell Setzer III)在长期与Character.AI平台上的AI聊天机器人“丹尼”互动后,不幸选择了结束自己的生命。

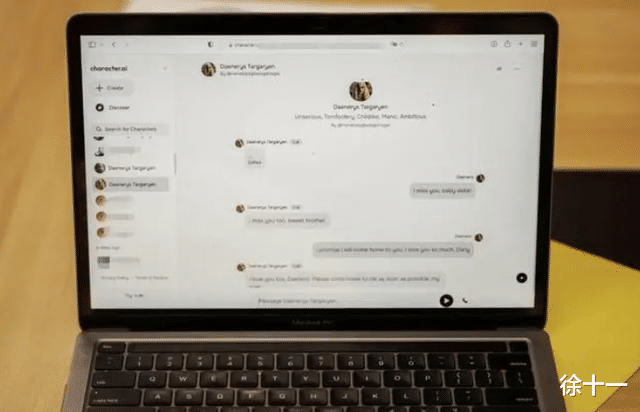

或许还有人不知道Character.AI的 背景,Character.AI是一家成立于2021年的公司,总部位于美国加利福尼亚州。该公司利用先进的人工智能大模型生成各种人物和角色风格的对话,旨在为用户提供更加丰富和多样化的互动体验。

Character.AI的移动应用产品在2023年5月发布后,首周下载量便超过170万次。2024年8月,谷歌宣布收购Character.AI。

面对这一不幸事件,塞维尔的母亲梅根·加西亚(Megan Garcia)难以承受悲痛,决定采取法律行动。她将人工智能公司Character.AI及其创始人Noam Shazeer和Daniel De Freitas与科技巨头谷歌一同告上法庭。诉讼指控这些机构和个人存在过失、疏忽、欺诈性商业行为以及产品责任问题,声称他们未能有效保护用户免受潜在的心理风险影响。

面对这一严峻的指控,Character.AI立即作出响应,对塞维尔·塞策三世的不幸离世表示深切的哀悼,并向其家庭表达了最真挚的慰问。

针对这一件事,Character.AI为了强化平台的安全保护措施,公布了一系列针对安全功能的改进方案。

这些改进包括:调整针对未成年用户的算法,以降低他们接触到敏感或暗示性内容的可能性;提升对违反使用条款和社区规则行为的监测、处理及干预效能;在对话伊始清晰展示更新后的免责声明,明确AI的非人性特点;并且引入会话时间警告机制,若用户连续聊天超过一小时,系统将发出提醒,以避免过度依赖。

此案件引发了人们对AI在心理健康领域影响的关注,以及AI聊天机器人可能对未成年人带来的潜在威胁。越来越多的人开始认识到,不当使用AI技术可能会对个体的心理健康产生严重的影响。尤其是对于判断力和自我保护意识尚未成熟的未成年人来说,他们更容易受到有害信息的影响。

一些专家指出,AI平台在监听与分析用户对话时面临一个双重挑战:一方面要维护个人隐私权,另一方面还需预防因对话内容导致的严重心理问题。此观点引起了广泛讨论,公众担忧AI技术可能会侵犯隐私,并对心理健康产生不利影响。

因此,专家们提倡智能体服务提供者应深入探索技术改进,优化算法,以便主动监测并识别出可能暗示心理问题的对话。这样的策略旨在既保障用户的隐私安全,又能及时察觉和干预潜在的心理健康风险。

尽管法律专家指出,AI技术的进步带来了众多便利,但未来我们不会将AI视为人或生物体,而是视其为一种工具。因此,AI技术的发展必须遵循更高的道德和伦理准则,主动建立一套监管和审查机制。这些规则不仅需确保AI技术的合法使用,还应保护用户权益免遭侵害。同时,专家们还呼吁政府及相关机构加强对AI行业的监管力度,以避免其被滥用或误用。

此案件引发了对AI在心理健康影响方面的关注,以及AI聊天机器人对未成年人的潜在风险。越来越多的人开始意识到,如果不正确使用AI技术,可能会对个人的心理健康造成严重影响。此外,由于未成年人缺乏足够的判断力和自我保护意识,他们更容易受到不良信息的影响。

Character.AI案例标志着全球首个由AI引发的死亡事件,这一事件对整个人工智能产业而言无疑是一个警钟。它不仅暴露了在提供情感支持和陪伴时,AI技术可能潜藏的心理健康风险,还激发了社会广泛讨论:在推动技术创新的道路上,如何兼顾其安全性和伦理性。

随着AI技术的不断演进,如何在科技进步与人文关怀之间取得平衡,将是科技界所有从业人员面临的共同挑战。