谷歌近日推出全新机器人大模型RT-2,作为DeepMind与谷歌大脑合并后新成果,由54位研究员合作,耗时7个月打造,进一步提高泛化与推理能力,实现机器人自主学习。

美国斯坦福大学李飞飞团队,近日发布具身智能研究最新成果VoxPoser,将大模型接入机器人,把复杂指令转化成具体行动规划,人类可随意用自然语言给机器人下达指令,机器人也无需额外数据与训练。

美国ARK基金创始人Cathie Wood,近日接受巴伦周刊专访,针对未来创新话题,谈到对特斯拉自动驾驶出租车车队预测、依然看涨加密货币理由、生成式AI受益者等。

特斯拉Autopilot负责人+首位号工Ashok Elluswamy,2023年6月在国际计算机视觉与模式识别会议CVPR 2023上演讲,谈到特斯拉自动驾驶、机器人基础模型、通用世界模型等话题,并现场回答观众提问。

本期“长期主义”,选择量子位对谷歌机器人大模型RT-2报道、量子位对李飞飞具身智能新成果报道、巴伦周刊发布的Cathie Wood专访纪要、有新Newin发布的特斯拉Autopilot负责人Ashok Elluswamy演讲纪要,六合商业研选精校,分享给大家,Enjoy!

正文:

全文13,199字

预计阅读27分钟

谷歌AGI机器人大招,54人天团憋7个月,强泛化强推理,DeepMind与谷歌大脑合并后新成果

时间:2023年7月29日

来源:量子位

字数:2,130

爆火的大模型,正在重塑谷歌DeepMind机器人研究。最新成果之一,他们耗时7个月打造的机器人项目RT-2。

效果究竟有多好?

只需用人话下达命令,面前这个小家伙就能挥动机械臂,思考并完成主人的任务。

像是给流行歌手Taylor Swift递水、或是辨认明星球队Logo。

甚至能主动思考,让它捡起已灭绝的动物,就能从狮子、鲸鱼、恐龙这三个塑料玩具中,准确pick恐龙。

别小看这个能力,这是实现了从灭绝的动物到塑料恐龙的逻辑飞跃。

更要命的是,它还能轻松解决给疲惫的人选一种饮料这种需结合思想链的多阶段推理问题,一听到命令小手就直奔红牛而去,简直不要太聪明。

据了解,谷歌DeepMind这项成果由54位研究员合作产出,前前后后拉扯7个月,最终才变成我们看到的这样so easy。

《纽约时报》介绍称,谷歌DeepMind机器人技术主管Vincent Vanhoucke认为,大模型彻底改变了他们部门研究方向:由于大模型这一变化,我们不得不重新考虑整个研究项目。

我们之前研究的很多东西,都已完全失效了。

将多模态大模型塞进机械臂

RT-2 Robotic Transformer 2机器人项目,是2022年底发布的RT-1进化版。

相比其他机器人研究,RT-2核心优势在于,不仅能理解人话,还能对人话进行推理,并转变为机器人能理解的指令,从而分阶段完成任务。

具体来说,具备三大能力,符号理解Symbol understanding、推理Reasoning、人类识别Human recognition。

第一个能力是符号理解,能将大模型预训练知识,直接延展到机器人此前没见过的数据上。

例如机器人数据库中虽没有红牛,但它却能从大模型知识中理解、掌握红牛外貌,并拿捏物品。

第二个能力是推理,这是RT-2核心优势,要求机器人掌握数学、视觉推理和多语言理解三大技能。

技能一,包含数学逻辑推理的命令,将香蕉放到2+1总和的位置。

技能二,视觉推理,将草莓放进正确碗中。

技能三,多语言理解,即使不用英语也能完成指令,用西班牙语命令它从一堆物品中挑出最与众不同的物品。

第三个能力是人类识别,准确识别并理解人类的行为,像开头看到的将水递给泰勒·斯威夫特例子就是能力展现之一。

这三个能力是怎么实现的?

是将视觉-文本多模态大模型VLM,具备的推理、识别、数学等能力,与机器人操作能力结合起来。

为实现这一点,研究人员直接给视觉-文本大模型VLM增加一个模态,机器人动作模态,从而变成视觉-文本-动作大模型VLA。

随后,将原本非常具体的机器人动作数据,转变成文本token。

例如将转动度数、放到哪个坐标点等数据,转变成文本放到某个位置。

这样一来,机器人数据也能被用到视觉-语言数据集中进行训练,同时在进行推理过程中,原本文本指令也会被重新转化为机器人数据,实现控制机器人等一系列操作。

这次研究中,团队主要基于谷歌一系列基础大模型做升级,包括50亿和550亿的PaLI-X、30亿的PaLI、120亿的PaLM-E。

为提升大模型本身能力,研究人员下了不少功夫,把思维链、向量数据库、无梯度架构no-gradient architectures都用上。

这一系列操作,让RT-2和2022年发布的RT-1相比,具有不少新优势。

看看具体的实验结果。

性能可达RT-1三倍

RT-2使用上一代机器人模型RT-1数据进行训练,数据没变,只是方法不同。

这些数据是用13个机器人在办公室搭建的一个厨房环境中,耗时17个月收集到的。

在实际测试中,一共历经6,000次,作者给RT-2许多以前未见过的物体,需RT-2在微调数据之外进行语义理解来完成任务。

结果完成的相当不错,包括从简单识别字母、国旗、人物,到从玩偶中识别陆生动物、选出颜色不相同的物体,甚至是捡起快要从桌上掉下去的零食等复杂命令。

从符号理解、推理、人类识别这三个细分能力看,RT-2两个变体,都比RT-1和另一种视觉预训练方法VC-1要好很多,性能最高可达3倍。这两个变体,分别在120亿参数PaLM-E、550亿参数PaLI-X上进行训练。

具体泛化能力评估上,通过与多个基线模型多类细分测试,最终发现RT-2性能提高大约2倍。

我们还没看到它与其他团队最新基于LLM的机器人方法进行对比,为更好理解RT-2不同设置如何影响泛化结果,作者又设计两大类评估:

一、模型尺寸上,仅在RT-2 PaLI-X变体,分别采用50亿参数、550亿参数进行训练;

二、训练方法上,分别采用从头开始训练模型vs微调vs协同微调的方法。

最终结果表明,视觉语言模型预训练权重的重要性,以及模型泛化能力,有随着模型大小而提高的趋势。

作者还在开源语言表基准上评估RT-2,结果显示它在模拟基准上实现SOTA结果90%vs之前的77%。

最后,RT-2 PaLM-E变体是视觉-语言-动作模型,可以在单个神经网络中充当LLM、VLM、机器人控制器,因此RT-2还可执行可控的思想链推理。

如下图所示的5个需推理的任务中,尤其最后一个非常有意思:选择可以替代锤子的物品,它接到命令后,会先输出自然语言步骤,然后再给出具体的动作token。

总结来说,最新的RT-2模型,不仅能更好适用于不同的、机器此前没见过的场景中,泛化能力更好;与此同时,由于有更好的大模型加持,它也掌握了一些有难度的新能力,比如推理。

One More Thing

谷歌将机器人研究重心放在大模型上,似乎不是空穴来风。

就在这2天,他们和哥伦比亚大学合作的一篇关于用大模型帮助获取更多机器人操作技能的论文,同样很火。

这篇论文提出新框架,不仅能让机器人很好适应大模型,同时还能保留原本机器人基础操作和控制能力。

和RT-2有所不同的是,这一项目已开源。

属实是用大模型带动整个机器人部门升级。

用大模型带动机器人,成为一种研究趋势,已让我们看到一波非常有潜力的进展。

李飞飞具身智能新成果,机器人接入大模型直接听懂人话,0预训练就能完成复杂指令

时间:2023年7月10日

来源:量子位

字数:1,788

李飞飞团队具身智能最新成果来了:大模型接入机器人,把复杂指令转化成具体行动规划,无需额外数据与训练。

人类可以很随意用自然语言给机器人下达指令,如打开上面抽屉,小心花瓶。

大语言模型+视觉语言模型,就能从3D空间中分析出目标与需绕过的障碍,帮助机器人做行动规划。

重点来了,真实世界中机器人在未经培训情况下,就能直接执行这个任务。

新方法实现零样本的日常操作任务轨迹合成,也就是机器人从没见过的任务也能一次执行,连给他做个示范都不需。

可操作的物体也是开放的,不用事先划定范围,开瓶子、按开关、拔充电线都能完成。

目前项目主页和论文都已上线,代码即将推出,并且已引起学术界广泛兴趣。

一位前微软研究员评价到:这项研究走在AI系统最重要和最复杂的前沿。

具体到机器人研究界,也有同行表示,给运动规划领域开辟新世界。

还有本来没看到AI危险性的人,因为这项AI+机器人的研究而改变看法。

机器人如何直接听懂人话?

李飞飞团队将该系统命名为VoxPoser,原理非常简单。

首先,给定环境信息(用相机采集RGB-D图像)和要执行的自然语言指令。

接着,大语言模型LLM根据这些内容编写代码,生成代码与视觉语言模型VLM进行交互,指导系统生成相应的操作指示地图3D Value Map。

3D Value Map,是Affordance Map与Constraint Map总称,既标记在哪里行动,也标记如何行动。

如此一来,再搬出动作规划器,将生成的3D地图作为目标函数,便能合成最终要执行的操作轨迹。

从这个过程我们可以看到,相比传统方法需进行额外预训练,这个方法用大模型指导机器人如何与环境进行交互,直接解决机器人训练数据稀缺的问题。

更进一步,正是由于这个特点,它实现零样本能力,只要掌握以上基本流程,就能解决任何给定任务。

具体实现中,作者将VoxPoser思路转化为优化问题,即下面这样复杂的公式:

它考虑到人类下达指令可能范围很大,并且需上下文理解,于是将指令拆解成很多子任务,比如开头第一个示例就由抓住抽屉把手与拉开抽屉组成。

VoxPoser要实现的就是优化每一个子任务,获得一系列机器人轨迹,最终最小化总工作量与工作时间。

而在用LLM、VLM将语言指令映射为3D地图过程中,系统考虑到语言可传达丰富语义空间,便利用感兴趣的实体entity of interest来引导机器人进行操作,也就是通过3D Value Map中标记的值来反应哪个物体是对它具有吸引力,哪些物体具有排斥性。

还是以开头例子举例,抽屉是吸引,花瓶是排斥,这些值如何生成,就靠大语言模型理解能力。

在最后轨迹合成过程中,由于语言模型输出在整个任务中保持不变,所以我们可以通过缓存其输出,并使用闭环视觉反馈,重新评估生成的代码,从而在遇到干扰时快速进行重新规划。因此,VoxPoser有很强抗干扰能力。

将废纸放进蓝色托盘

以下分别是VoxPoser在真实、模拟环境中表现,衡量指标为平均成功率。

可以看到,无论是哪种环境、哪种情况(有无干扰、指令是否可见),它都显著高于基于原语的基线任务。

最后,作者惊喜发现,VoxPoser产生4个涌现能力:

1、评估物理特性,比如给定两个质量未知的方块,让机器人使用工具进行物理实验,确定哪个块更重;

2、行为常识推理,比如在摆餐具任务中,告诉机器人我是左撇子,它就能通过上下文理解其含义;

3、细粒度校正,比如执行给茶壶盖上盖子这种精度要求较高任务时,我们可以向机器人发出你偏离了1厘米等精确指令来校正操作;

4、基于视觉的多步操作,比如叫机器人将抽屉精准打开成一半,由于没有对象模型导致的信息不足,可能让机器人无法执行这样任务,但VoxPoser可根据视觉反馈提出多步操作策略,即首先完全打开抽屉,同时记录手柄位移,然后将其推回至中点就可满足要求。

李飞飞:计算机视觉的3颗北极星

大约1年前,李飞飞在美国文理学会会刊上撰文,指出计算机视觉发展的三个方向:具身智能Embodied AI、视觉推理Visual Reasoning、场景理解Scene Understanding。

李飞飞认为,具身智能不单指人形机器人,任何能在空间中移动的有形智能机器都是AI的一种形式。

正如ImageNet旨在表示广泛、多样化的现实世界图像一样,具身智能研究也需解决复杂多样的人类任务,从叠衣服到探索新城市。

遵循指令执行这些任务需视觉,但不仅是视觉,也需视觉推理、理解场景中的三维关系。

最后机器还要做到理解场景中的人,包括人类意图与社会关系。比如看到一个人打开冰箱能判断出对方饿了,或看到一个小孩坐在大人腿上能判断出他们是亲子关系。

机器人结合大模型,可能正是解决这些问题的一个途径。

巴伦专访Cathie Wood:为什么看好还要减持特斯拉

时间:2023年7月31日

来源:巴伦周刊

字数:3,048

ARK创始人兼CEO Cathie Wood,以对颠覆性创新与投资对象抱有的坚定信念而广为人知。

2020年,ARK旗下基金因利率大幅下降与成长股的飙升一举成名,吸引大批投资者,但在接下来2年里,这些基金因投资的公司股价下滑与利率上升出现亏损。

2023年,由于特斯拉TSLA、Coinbase Global、Roku等股票大幅上涨,ARK卷土重来。

截至7月26日,规模约80亿美元的旗舰基金ARK Innovation上涨54.5%,相比之下,标普500指数同期上涨19%。另外几只投资于基因组革命、自动化技术、机器人、金融技术创新等主题的基金,虽仍远低于2021年初峰值,但也以类似幅度跑赢大盘。

《巴伦周刊》近日就未来创新这一话题,对Cathie Wood进行专访,她谈到对特斯拉自动驾驶出租车车队的预测、依然看涨加密货币的理由、生成式AI受益者等。

《巴伦周刊》:2022年秋季~冬季期间,你在斯拉股价下跌时大举买入,2023年股价反弹后一直在减持,这么做原因是什么?

Cathie Wood:减持主要原因,是为了更好管理投资组合。过去6个月,特斯拉股价上涨超过2.5倍,我们投资的其他一些股票仍接近它们低点,当特斯拉在投资组合中权重超过10%时,我们就会减持,将资金配置给那些我们认为没有被其他人充分理解的股票。

《巴伦周刊》:你为特斯拉给出目标价仍为2,000美元,特斯拉近期股价为264美元,不少持怀疑态度的人,说你对电动汽车销量与自动驾驶出租车业务的预期过高。

Cathie Wood:特斯拉降价以来,我们对该公司更有信心,特斯拉是少数几家有能力降价的汽车制造商之一,因为公司电池成本正在下降,其他电池成本高得多的汽车制造商将受到不利影响。

2022年全球共售出700万辆电动汽车,到2027年,我们预计全球电动汽车销量将达到6,000万辆,我们还预计特斯拉能保持目前市场份额。

《巴伦周刊》:你对特斯拉自动驾驶出租车业务预期也很高,到2027年,息税折旧及摊销前利润EBITDA将达到2,270亿美元,比苹果目前的EBITDA还高。为什么对特斯拉这项业务如此有信心?

Cathie Wood:自动驾驶汽车已得到验证。2022年12月,我搭乘Cruise自动驾驶汽车前往我儿子在旧金山公寓,往返花了大约半小时时间。

特斯拉竞争优势在于,拥有数十亿英里(1英里=1.6公里)现实驾驶数据,这些数据被用来训练模型,教汽车如何适应罕见情况。目前没人能做到这一点,因为他们没有这么多数据。

我们认为,特斯拉在成为美国自动驾驶出租车平台方面拥有核心优势,该公司对这项服务定价将低于优步与Lyft。

在新技术帮助下,让成本下降的是单位增长率。我们认为,与电动汽车一样,特斯拉这项业务成本将随着规模扩大而下降。

《巴伦周刊》:出行安全角度看,人们在3~4年内会放心搭乘机器人出租车这一预期合理吗?

Cathie Wood:我不知道你怎么看这个问题,与搭乘一辆由我不认识的司机驾驶的汽车相比,我更愿意搭乘一辆我信任的无人驾驶汽车。

每年大约有4.5万人死于车祸,80%~85%是人为失误造成,如果我们把人为因素排除在外,事故就会少得多。

已有数据证明这一点:支持全自动驾驶的特斯拉汽车,每行驶320万英里/515万公里发生一次事故,而由人类司机驾驶的特斯拉汽车每行驶60万英里/97万公里发生一次事故,一般汽车平均每行驶50万英里/80万公里发生一次事故。

《巴伦周刊》:你最近还抛售英伟达股票,为什么?

Cathie Wood:很多人对我们旗舰基金清仓英伟达决定小题大做,一些人认为我们不关注估值,但其实正是估值让我们做出清仓英伟达决定,英伟达目前市销率太高了。

《巴伦周刊》:上个月你建仓Meta,是什么吸引了你?

Cathie Wood:Meta从元宇宙转向AI,是股票由跌转涨重要原因之一,用户黏度数据好于预期是另一个原因。

Meta有个细分策略,年龄较大人用Facebook,年轻人用Instagram与WhatsApp,Threads情况还有待观察,但我认为它不会与Twitter一样。

《巴伦周刊》:加密货币交易所Coinbase Global是你投资的另一家公司,在监管环境发生变化之际,过去1个月Coinbase上涨一倍,接下来呢?

Cathie Wood:过去6个月发生了一些非常重要的变化。起初,我们关注的只是行政部门的监管举措,主要是美国证券交易委员会SEC与该机构主席加里·詹斯勒Gary Gensler的监管举措。

但现在,美国政府司法部门与立法部门正在采取行动,它们认为SEC作为监管机构在行使权力时越界了。

法院正在对SEC章程提出质疑,此外,赔率公司认为,SEC将输掉对Grayscale Investment与Ripple Labs提起的诉讼。

与此同时,立法部门已意识到加密货币是新的资产类别,需设置新的立法机构给监管机构一些指导。司法部门与立法部门给了我们很大的信心,让我们相信Coinbase会成为赢家。许多Coinbase的竞争对手要么没有进入美国,要么因为美国的监管体系而退出,Coinbase一直在战斗,我们认为该公司会获得相应的奖励。

在《巴伦周刊》采访Cathie Wood后不久,美国一名地方法院法官裁定,Ripple在公开交易所出售XRP代币的行为并未违反联邦证券法,XRP代币相当于直接出售给机构投资者的未登记的证券。在加密货币行业与SEC就其产品是否属于SEC管辖范围展开斗争之际,这项裁决被视为该行业一个里程碑式的胜利。

《巴伦周刊》:你为什么仍然看涨加密货币?

Cathie Wood:我们看到加密货币带来三个变革。

第一个变革,货币革命由比特币主导,2023年早些时候地区性银行股崩盘时,比特币从19,000美元涨至30,000美元,这是最强有力的证据。

我们认为,那一轮上涨是因为投资者转向安全资产躲避风险,而且预计这一转向的速度会加快。

如今我们看到中央货币体系已走偏,我们可能会回到未来,即回到美联储诞生之前、没有政府监督的数字化、基于规则的货币体系下。

第二个变革,发生在金融服务领域,去中心化金融DeFi,它将以以太坊为基础,现在有很多基础设施供应商,这是适者生存的游戏,我很期待看到谁会胜出。

第三个变革,数字产权,非同质化代币NFT或元宇宙。人们已开始在虚拟世界买房产,我们公司一些年轻的研究助理不穿名牌牛仔裤与T恤,但他们正在虚拟世界里获得自己地位。

《巴伦周刊》:目前投资者非常关注AI发展,什么样的公司将从生成式AI中受益,投资者应怎样抓住AI带来的机会?

Cathie Wood:当我们从AI角度看股票时,我们主要看三点,首先是专业知识与有远见的管理层,第二是良好的分销网络,第三是专有数据,这一点非常重要,这些数据可用来训练AI模型,从而改进产品与服务,降低成本,提高生产率。

目前全球知识型工作者总薪酬是32万亿美元,如果我们看法是对的,现在是知识型工作者的装配线时刻,薪酬成本将下降,生产率将显著提高,任何没有考虑到这一点的公司都将在竞争中遇到问题,因为许多市场将出现赢家通吃的局面。

Twilio拥有企业与消费者间数万亿次互动的数据,我们认为该公司将成为巨大的受益者。

我们还认为,远程医疗服务公司Teladoc Health,最有可能成为美国医疗保健信息领域中坚力量,由于Teladoc上医生必须看到患者电子健康记录,因此该公司正在快速收集信息,未来Teladoc模型可以为医生提供最佳治疗方案的建议。

《巴伦周刊》:还有哪些颠覆性技术正在酝酿之中?

Cathie Wood:我预计会出现更多罕见疾病的治疗方法,因为各种各样的基因测序使我们能识别基因组中突变,使用Crispr基因编辑疗法来重新编程。

随着自动驾驶出租车平台兴起,与之相关成本将下降,道路将变得更加拥挤,这意味着更多商业活动将出现在空域,我们看好无人机运送食品、杂货与医疗用品的前景,未来我们会看到更多无人机与电动垂直起降飞行器EVTOLs。

几年之内,我们就能以今天搭乘出租车的价格,乘坐空中出租车从曼哈顿飞往肯尼迪机场。

《巴伦周刊》:有没有哪只股票你曾经很看好,但后来改变想法?

Cathie Wood:我们曾经很长一段时间里持有Illumina,但在2020年底退出对该公司投资。

我们认为Illumina把基因组测序价格维持在1,000美元,是犯了战略性错误,这是创新中的致命错误,你必须把成本下降转嫁给客户,才能让更多人使用这项技术,进而享受成本进一步下降。

这让Pacific Biosciences of California获得迎头赶上的机会,我们卖掉Illumina,尽可能多的买Pacific Biosciences of California。

特斯拉Autopilot负责人+首位号工Ashok Elluswamy最新自动驾驶、机器人基础模型、通用世界模型分享

时间:2023年7月20日

来源:有新Newin

字数:6,233

Ashok Elluswamy是特斯拉Autopilot团队第一位员工,在加入特斯拉之前,他曾在WABCO Vehicle Control System工作,并在大众电子研究实验室实习过。

Ashok Elluswamy拥有卡内基梅隆大学机器人系统开发硕士学位,卡内基梅隆大学期间,他一位老师在LinkedIn上称赞:他是顶尖学生之一,并展现出在广泛的主题上学习的积极性。

这期内容来自Ashok Elluswamy 6月在CVPR 2023上的分享。

自动驾驶中的基础模型

我是Ashok Elluswamy,今天我想介绍我们工作,这将成为自主驾驶与机器人技术的基础模型,这不仅是我一个人的工作,我代表着由才华横溢的工程师组成的大团队。

我们团队已将完整的自动驾驶测试版软件,交付给在美国与加拿大购买的所有用户,大约有4,000辆车。到目前为止,这些车辆已在FSD Beta平台上行驶250英里/402公里,总共行驶5,000万英里/8,047万公里。

这个令人兴奋的事情是,这是可扩展的自动驾驶系统,可带着车子去美国任何地方,只需设定目的地,车子就会试图导航到那里,自动处理转弯、购物、交通信号灯以及跟踪其他物体。

这一切主要由车辆周围八个摄像头驱动,这些摄像头能提供对车辆全方位360度覆盖。之所以能实现这样效果,是因为我们系统基于现代机器学习技术构建,许多自动驾驶心理学的能力都融入到神经网络中。

我想说,这与传统自动驾驶方法不同,传统方法使用本地化地图、雷达、超声波等来进行融合。相反,我们系统主要依靠摄像头。如果你拥有特斯拉汽车,你可自己购买并体验,否则请相信我的话或观看一些视频,效果非常好,我们正在努力改进它。

我还分享了关于占用网络一些重要内容,它是我们系统中一个重要组成部分。我认为这是基础模型任务之一,因为它非常通用,不需任何特定的本体知识,它只是预测三维空间中体素是否被占用,特点是可适用于任意场景,不需标注或设计本体知识。

除占用情况,我们还预测未来体素的流动情况,这也提供了任意运动的预测。所有这些都是实时运行,这与神经网络有些相似,但与神经网络或多视图重建不同,我们使用八个摄像头实时预测占用情况,而不是在后期进行处理。

网络架构看起来很复杂,但实际上并不复杂,它可从多个摄像头视频流中提取信息,并选择任意主干模型,然后在大型的Transformer块中将所有信息结合起来,通过特殊注意力机制构建特征,并进行时间注意力,还加入一些几何特征,最后通过采样得到最终预测结果。虽然图表看起来有些复杂,但整个过程其实非常直观。

这个模型的架构与建模方法不仅适用于占用情况,还适用于其他与驾驶相关的任务。显然,车道与道路对驾驶任务非常重要。

但我必须说,预测车道相当困难。首先,车道是高维对象,不仅是一维或二维,而且它们具有图形结构。例如,大部分物体(如车辆)都是自包含的,只在局部区域内存在,而车道可横跨整个道路,你可在视野中看到数英里车道,它们可分叉、合并,给建模带来各种麻烦。

车道预测还存在很大不确定性。有时,由于被遮挡或夜间条件,你可能无法看到车道全部。而且,即使一切都清晰明了,甚至连人都无法确定你所看到的是两条车道还是一条车道。所以车道预测存在很多不确定性,仅将其作为某种信息输出不够,这会导致在后续应用中很难使用。

因此,最好方法是将其预测为某种宏观表达形式,例如多段线、样条曲线、多项式等,以便使用,并且所有这些都需在几十毫秒内实时完成。

就像我说的,实时预测车道是非常困难的问题。这方面,我们采用最先进的生成建模技术,具体来说,我们使用自回归Transformer,它在车道建模方面与GPT非常相似。

我们可将车道进行标记化,逐个令牌进行预测。与语言不同的是,车道结构多样化,我们需捕捉到完整图形结构,并预测分叉点与合并点等。这一切都是端到端进行,几乎没有后期处理。另一个重要的驾驶任务,是移动物体,例如车辆、卡车、行人等。

仅检测到它们是不够的,我们需获取它们完整运动状态,并预测它们形状信息与未来轨迹等。前面所描述的模型,包括车道模型与物体模型,某种意义上说,都是多模态模型,因为它们不仅接收摄像头的视频流,还接收其他输入,例如车辆运动状态(速度、加速度、变速度等),并提供导航指令给车道,以引导车辆选择使用哪条车道等。

所有一切,都在网络内部进行处理,这就是我所说的现代机器学习技术栈的特点,我们将所有任务结合在一起,实现端到端感知。在这里,你可看到这些模型的预测效果。你看到的车道与车辆都是通过网络预测得到,并经过一些后期处理,其中没有跟踪等。

总的来说,这个系统非常稳定,你所看到车辆预测的绿色轨迹,是它们未来的预测轨迹,现在它可被视为一个固定的任务。所有这些都在实时环境中非常好的工作,一旦我们拥有所有这些感知信息,例如车道、占用情况、物体等,我们就可进行完整的运动规划。

关于具体实现细节,我不会深入讲解,但基本上可将其看作是另一个任务,而不是一个独立的部分。

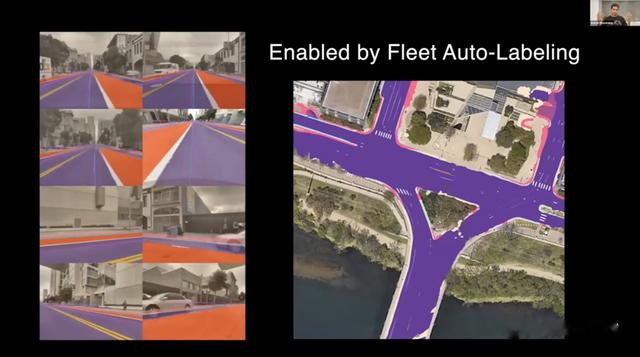

所有这些是如何实现的?我认为这是因为我们建立了复杂的自动标注流程,可从整个车队获取数据,可获得全球范围内数百万个视频片段。在左侧,你可看到多车辆重建的示例,我们选择一些位置,多辆特斯拉汽车驶向该位置,上传视频片段与车辆的运动数据等。

我们将所有数据整合起来,重建整个三维场景。所展示的多条曲线或多边形,是不同车辆在不同行程中路径,它们间的对齐非常好。这种多行程重建,使我们能直接从全球范围内车队获取车道等信息。

一旦你拥有来自所有摄像头的基本轨迹校准结构,你就可做很多有趣的事情,重建整个场景。视频可能无法流畅播放,但在我屏幕上,它看起来非常平滑,你可看到地面表面的重建效果非常好,没有双重视觉或模糊现象,物体看起来几何正确。

这是一种神经与3D重建的混合方法。有时,即使渲染的图像看起来很好,底层的几何结构可能仍然模糊不清。所以我们采用一种混合方法,效果非常好。你可看到,栅栏、车辆与卡车等都被相当准确重建出来。

一旦我们完成这些重建,我们会使用更多离线神经网络来生成我们想要的标签。正如我之前提到,对车道,我们需某种矢量表示来使其易于使用。

因此,我们不仅直接使用光栅图像,而是使用顶部运行的神经网络,然后生成矢量表示,这些表示可作为在线系统的标签。类似车道,一旦车道与道路被重建,我们还可自动标记交通信号灯,你可看到这里交通信号灯是由我们系统在没人工干预情况下进行水平化的。

它们具有一致的多视图,在再投影时,你可看到侧面白色交通信号灯在所有摄像头视角中都能正确重现。这得益于我们良好自动校准系统,它能联合校准所有摄像头,像素级精确的在三维空间中对齐。

所以,所有这些预测结果结合在一起,给我们提供对世界的超强理解。我已尝试称之为一种条件模型,可在许多不同领域中使用。这些预测结果真正有助于自动驾驶,在任何地方都能行驶,不必受地理限制,甚至有时可建造一条新的道路,开启它,它也会很好工作。

此外,它们还有助于人工驾驶,因为人类并不是完美驾驶员,有时需一些帮助。例如,在左侧,自动驾驶车辆由于某种原因忽略停车标志,几乎要撞到红车。我们系统进行干预,自动刹车。

在右侧的情况下,我们直行,然后有车突然插入并切入我们车道,这非常危险,但系统及时刹车。这种情况与你认为自动驾驶系统自1980年代以来一直存在的情况有所不同。

根据我所了解的情况,我认为特斯拉是第一家将此类紧急刹车技术交付给消费者的公司。与在同一车道行驶的车辆不同,穿越的对象更难处理,因为你不知道它们是否能及时停下来。我们需考虑停车线、交通信号灯、它们可能转弯的车道等许多因素,了解穿越对象的行驶路径与可能的行驶方向。这不像指导一辆车那么简单,只需速度与其他相关信息。

正如我所说,我相信特斯拉是第一家将穿越刹车技术应用于自动驾驶的公司,并且在过去几个月已交付给消费者。但基础模型真的只是将许多这些任务串联在一起吗?还是还有更多?我们认为,我们可激励这些任务,例如获取占用情况,虽然它很通用,但某些情况下,一些东西在该空间中更难以表示。

构建通用的世界模型

我们正在努力学习更加通用的世界模型,能真正表示任意事物。这种情况下,我们通过神经网络对过去或其他因素进行条件化,以预测未来。我相信每个人都一直希望能做到这一点,而且我认为随着最近通用模型(如Transformer、扩散等)兴起,我们终于有了机会。

你在这里看到的纯粹是生成的视频序列,给定过去视频,网络会预测一些未来的样本,希望是最可能的样本。你可看到它不仅为一个摄像头预测,它同时预测车辆周围所有八个摄像头情况,你可看到车辆颜色在所有摄像头中是一致的,物体运动在三维空间中也是一致的。

尽管我们没有明确要求它在三维空间中进行任何操作,也没有预先定义任何三维先验知识,但网络可自主理解深度与运动。

因此,由于所有预测只是对未来RGB值的预测,所以本体是非常通用的,你可使用任何驾驶视频片段,无论来自行驶中的视频、YouTube,还是你自己的手机,都可用来训练这个通用的世界动力学模型。

此外,它还可与动作相结合,例如在左侧,车辆保持在当前车道行驶,我们要求它继续在该车道行驶,你可看到模型能非常好预测几何形状与运动,对三维进行很好理解。

在右侧,我们要求车辆向右换道,也许我们可再回放一下。在左侧,车辆直行,我们要求它继续直行,模型直行;然后在右侧,我们要求车辆换道,它也换道。两种输出的过去上下文是相同的,这是相同的测试。

当我们请求不同的未来样本时,它们能产生不同预测,这非常强大,因为现在你实际上拥有一个神经网络模拟器,可根据不同动作模拟不同未来。与传统游戏模拟器不同,这更加强大,因为它可表示一些很难用显式系统描述的事物。

我将展示更多示例,但这非常强大,同时运动、意图与其他对象的自然行为(例如车辆)很难用显式方式表示,但在这个世界中很容易表示。

它不仅局限于RGB图像,你当然也可在对象分割或连接等其他特征上进行这种预测任务,三维空间中,你可基于过去与你的动作提示甚至在没有提示情况下,预测不同的未来。我个人对其工作效果感到惊讶,这是我们正在努力的令人兴奋的未来。

这里有一些例子,我认为这种模型将需要来表示场景中发生的事情,例如,烟雾弥漫在所有图片中,纸张飞舞,即使对占用情况,当纸张飞舞时,它可能很难识别,它可能对光传输也有一定影响,驾驶中有许多微妙之处,我们需解决所有这些问题,构建通用的驾驶技术栈,可在世界上任何地方行驶,具有人类般行为,快速高效,同时又非常安全,我认为我们正在寻找正确解决方案。

显然,训练所有这些模型需大量计算资源。这就是为什么特斯拉致力成为计算领域的世界领导者,我们自定义的训练硬件Compute Dojo,将在7月开始生产。通过这个硬件,我们认为我们正在成为全球顶级计算平台之一。

我们认为,为训练这些视觉基础模型,我们需大量计算资源,不仅是为训练一个模型所需的计算资源,还需计算资源来尝试许多不同实验,以确定哪些模型效果最好。这对我们来说非常令人兴奋,因为计算资源将变得丰富,并且将由工程师与技术人员创意监控。

这不仅是为了汽车而建立,也是为机器人。我们已在汽车与机器人间共享占用情况网络等一些其他网络,并且在这两个平台上都非常好地通用。我们希望将这个理念扩展到我们所拥有的所有任务上,不仅是车道与车辆等,如果机器人走到路上,环顾四周,它应能理解道路与车辆,以及它们可能的行驶方式等。所有这些都将被构建为这两个平台,以及未来其他机器人平台所使用。

总而言之,我们正在为视觉构建这些超酷的基础模型,它们真正理解一切,并且应该适用于汽车与机器人。它们将通过来自车队的大量多样化数据与大量计算来进行训练。所以,我对接下来12~18个月非常兴奋,看看这里会发生什么。

QA环节

观众:你能多分享一些关于世界模型的细节吗?例如,它是否类似BQ、GAN Tokenizer,然后在这些标记上进行自回归,或MASCOT或其他详细信息?

Ashok:我想说,这还在研究中,目前架构并不是固定的。我认为主要的信息是这种未来预测任务现在开始发挥作用。这既提供了一个可模拟不同结果的模拟器,也通过进行这些预测来学习表示。我认为这是关键信息。

观众:我有一个小问题,我对细节很感兴趣。我注意到当你预测线或车道时,你使用了自回归模型。我想知道在这里选择自回归逻辑是什么,而不是同时预测所有内容?你能解释一下这里的逻辑吗?

Ashok:车道可分叉、合并与做其他动作,它们有一个图形结构。你可同时预测它们,但这很困难,因为我们希望对高维空间中分布进行建模,对像车道数量这样的事物,存在不确定性。

我们不希望预测出两个半车道,我们希望预测一个车道或两个车道。因此,我们希望从分布中进行采样。如果你没有适当的三维模型来给出好的样本,你将得到模糊的结果,对下游任务来说非常难以使用。因此,这种方法对获得好的样本非常有用。

观众:我有一些关于技术细节的问题。我想看一下占用网络输出的可视化结果,它看起来是一个三维体素,并且我有一个关于实际体素大小的问题。在你们领域与长距离上,体素大小会有所改变吗?

Ashok:是的,这些都是超参数,任何人都可尝试不同体素大小。这实际上是在内存、计算与其他需求间进行权衡。

所以,它并不是固定的,不是一成不变,它根据应用的需求,可在机器人与汽车间进行不同配置,它们有不同需求。所以它是可进行配置的,也可作为一个可变的参数,通过一些小的多层感知器之类的方式查询到任意位置,这样你就可计算任意位置的结果。基于下游任务的设计来确定基本尺寸是需要的,你是否需单个单元块以及是否可使用一些简单的公式进行计算,这完全取决于具体的实现。

观众:我有一个关于你刚提到的通用世界模型的问题,例如,如何将其应用于人形机器人的任务,例如操纵?你们使用了哪些方法,使其从自动驾驶泛化到其他人形机器人任务?

Ashok:是的,我认为对人形机器人来说,同样的原理适用。你可让它完成任意任务,比如拿起一杯子,或走进一扇门之类。然后模型应该能想象拿起杯子的样子,或走进门的样子,我认为在汽车与机器人间没什么不同。

因为它们都是像素,形状也都是一样。所以最终展示的可能是一段视频,看起来像是手伸向杯子,或机器人的第一人称视角,走向门口,我认为这应该是可行的。

观众:你向我们展示了许多独立的模块,我想知道你是如何将这些模块统一到FST的端到端系统中。例如,在FST12中,如何将占用模块用于端到端系统?

Ashok:占用模块已用于许多避碰任务。有时当出现一些奇怪的车辆或施工车辆时,它们臂杆可能会上下移动,然后抓起物体,用立方体之类方式很难对其建模。当然你可用网格表示,但这样它们也变成高维对象,其分布比较复杂。而占用模块可被视为一种相对较低级别或更简单的任务,你可预测物体是否存在以及它们移动轨迹。这已足够用于避免碰撞。我们确保规划系统遵守占用模块提供的避碰信息。

观众:我对你们通用世界模型非常感兴趣。我是特斯拉忠实粉丝,我想知道这个模型推理时间是多少?我能否在不久的将来在汽车上看到它的应用?

Ashok:我能说的只是它尚未交付给客户,我们仍在进行优化,可能在今年晚些时候。

观众:我在你架构图中没有看到地图组件与融合步骤?它是否已被移除?如果还存在,在将地图信息与感知信息进行融合时,如何处理对齐问题?因为你们没有使用高精度地图,对吗?融合过程中,你们是如何处理?

Ashok:是的,这些不是高精度地图,因此对齐并不是非常关键。某种程度上,你可有20米或50米误差,仍然可工作正常。

实际上,它更像是你在手机上使用导航时看到的东西,比如Google Maps或其他地图应用程序给出的一些路线表示,这已足够告诉模型我们应该去哪里。

所以它实际上是低精度地图,这样设计是为了避免过度依赖地图,它只是大致指导我们选择哪条道路、哪条车道等。

【长期主义】栏目每周六、与长假更新,分以下系列:

宏观说:全球各大国政要、商业领袖等

社会说:比尔·盖茨等

成长说:洛克菲勒、卡内基等

科学说:历年诺奖获得者、腾讯科学WE大会等

科技说:马斯克、贝索斯、拉里·佩奇/谢尔盖·布林、扎克伯格、黄仁勋、Vitalik Buterin、Brian Armstorng、Jack Dorsey、孙正义、华为、马化腾、张小龙、张一鸣、王兴等

投资说:巴菲特、芒格、Baillie Giffrod、霍华德·马克斯、彼得·蒂尔、马克·安德森、凯瑟琳·伍德等

管理说:任正非、稻盛和夫等

能源说:曾毓群等

汽车说:李想、何小鹏、王传福、魏建军、李书福等

智能说:DeepMind、OpenAI等

元宇宙说:Meta/Facebk、苹果、微软、英伟达、迪士尼、腾讯、字节跳动、EpicGames、Roblox、哔哩哔哩/B站等

星际说:中国国家航天局、NASA、历年国际宇航大会,SpaceX、Starlink、蓝色起源、维珍银河等

军事说:全球主要航空航天展等

消费说:亚马逊、沃尔玛、阿里、京东、拼多多、美团、东方甄选等

每个系列聚焦各领域全球顶尖高手、产业领军人物,搜集整理他们的致股东信、公开演讲/交流、媒体采访等一手信息,一起学习经典,汲取思想养分,做时间的朋友,做长期主义者。

相关研报:

人类未来文明三部曲之二:智能时代专题预售开启,奇点临近,未来已来

九宇资本赵宇杰:智能时代思考,认知思维,存在原生、降维、升维三波认知红利

九宇资本赵宇杰:智能时代思考,以史为鉴,科技浪潮,从互联网到AI

九宇资本赵宇杰:智能时代思考,宇宙视角,从碳基生物,到硅基智能体

人类未来文明三部曲之一:元宇宙专题预售开启,59期45万字

九宇资本赵宇杰:1.5万字头号玩家年度思考集,科技创新,无尽前沿

九宇资本赵宇杰:1.5万字智能电动汽车年度思考集,软件定义,重塑一切

【重磅】前沿周报:拥抱科技,洞见未来,70期合集打包送上

【重磅】六合年度报告全库会员正式上线,5年多研究成果系统性交付

【智能电动汽车专题预售】百年汽车产业加速变革,智能电动汽车时代大幕开启

【头号玩家第一季预售】:科技巨头探索未来,头号玩家梯队式崛起

【头号玩家第二季预售】:科技创新带来范式转换,拓展无尽新边疆

【首份付费报告+年度会员】直播电商14万字深度报告:万亿级GMV风口下,巨头混战与合纵连横

【重磅】科技体育系列报告合集上线,“科技+体育”深度融合,全方位变革体育运动

【重磅】365家明星公司,近600篇报告,六合君4年多研究成果全景呈现

九宇资本赵宇杰:CES见闻录,开个脑洞,超级科技巨头将接管一切

【万字长文】九宇资本赵宇杰:5G开启新周期,进入在线世界的大航海时代|GBAT 2019 大湾区5G峰会

九宇资本赵宇杰:抓住电子烟这一巨大的趋势红利,抓住产业变革中的变与不变

【IPO观察】第一季:中芯国际、寒武纪、思摩尔、泡泡玛特、安克创新等11家深度研报合集

【IPO观察】第二季:理想、小鹏、贝壳、蚂蚁、Snowflake、Palantir等12家公司深度研报合集

【IPO观察】第三季:Coinbase、Roblox、快手、雾芯科技等12家公司深度研报合集

【重磅】年度观察2019系列合集:历时3个多月,超20万字近500页,复盘过去,展望未来,洞悉变与不变

【珍藏版】六合宝典:300家明星公司全景扫描,历时3年,210万字超5,000页,重磅推荐

九宇资本赵宇杰:对智能电动汽车产业的碎片化思考

九宇资本赵宇杰:九宫格分析法,语数外教育培训领域的道与术

【2023回乡见闻录】90、00后小伙伴们万字记录,生活回归正轨,春节年味更浓

【2022回乡见闻录】20位90、00后2万字,4国13地,全方位展现国内外疫情防疫、春节氛围、发展现状差异

【2021回乡见闻录】22位90后2万字,就地过年与返乡过年碰撞,展现真实、立体、变革的中国

【2020回乡见闻录】20位90后2万字,特殊的春节,时代的集体记忆

【重磅】22位“90后”2万字回乡见闻录,讲述他们眼中的中国县城、乡镇、农村

六合君3周岁生日,TOP 60篇经典研报重磅推荐

下午茶,互联网世界的三国杀

5G助推AR开启新产业周期,AR眼镜开启专用AR终端时代

新商业基础设施持续丰富完善,赋能新品牌、新模式、新产品崛起,打造新型多元生活方式

【重磅】中国新经济龙头,赴港赴美上市报告合辑20篇

知识服务+付费+音频,开启内容生产新的产业级机遇,知识经济10年千亿级市场规模可期

从APP Store畅销榜4年更替,看内容付费崛起

新三板破万思考:新三板日交易量10年100倍?

九宇资本赵宇杰:科技改变消费,让生活更美好|2017 GNEC 新经济新消费峰会

九宇资本赵宇杰:创业时代的时间法则,开发用户平行时间|2016 GNEC 新经济新智能峰会

九宇资本赵宇杰:互联网引领新经济,内容创业连接新生态|2016 GNEC 新经济新营销峰会

请务必阅读免责声明与风险提示