4 通用物理模拟器

随着传统机器人向具身智能演进,其应用需求正逐渐从结构化工业环境转向开放动态的人类生活环境。然而,智能机器人算法研究仍面临显著的数据瓶颈,严重限制了相关算法的泛化能力和适用性。

具体来说,当前智能机器人的数据收集仍面临以下挑战:1)成本与安全问题:基于遥操作[55][153]或通用操作接口(UMI)[238]的数据收集策略对硬件要求较高,且需要操作员具备一定熟练度,导致成本上升。此外,物理实验还存在危险场景或机器人动作带来的安全隐患。2)控制与可重复性问题:数据收集过程受光照、背景和传感器噪声等因素影响,导致数据质量不稳定。为控制这些因素,必须精心设计收集场景。然而,由于场景无法完全受控,难以在相同条件下重复实验以评估相关算法的适用性。

为解决上述瓶颈,Sim2Real迁移技术已成为克服数据限制的关键方法。该范式构建高保真虚拟环境以生成多模态合成数据,具有以下主要优势:

1)数据生成效率显著提升:利用GPU加速的物理引擎和分布式渲染,模拟器能够快速生成大量仿真数据,使数据采集过程既经济又安全;

2)自动化标注与可控语义标注:模拟器可直接输出像素级真实数据,包括语义分割图、深度图和6D物体位姿,从而实现对模拟环境的精准控制。

此外,模拟器还为调试、验证和优化机器人感知、控制及规划算法提供了高效、安全且可复现的测试环境,显著提升了这些算法在实际部署中的鲁棒性与可靠性。

图14:机器人研究主流仿真器

本章聚焦于当代机器人研究中的主流仿真器。首先介绍广泛采用的仿真平台,随后阐述其多样化的功能,涵盖物理仿真特性、渲染能力以及对传感器和关节组件的支持能力。最后总结机器人仿真器的当前发展,并探讨未来研究方向。

4.1 主流仿真器

Webots [239]由Cyberbotics Ltd.于1998年推出,提供了一个集成的机器人建模、编程和仿真框架,在教育、工业和学术界被广泛采用。2018年开源后,显著提升了其在全球研究和教育中的可访问性。Webots提供丰富的预构建机器人模型,支持多种传感器模态,跨平台,并提供多语言API,是一款多功能且用户友好的工具。然而,它不支持可变形体和流体动力学,在高级物理和大规模学习任务方面存在局限性。

Gazebo [15] 由安德鲁·霍华德和内特·科尼格于2002年在南加州大学开发,是一款广泛采用的开源仿真器,以其可扩展性和与机器人中间件的集成而著称。除了支持多种传感器和机器人模型外,Gazebo还具备模块化插件系统,允许用户自定义仿真组件,包括模型、控制器和传感器。Gazebo还支持接入多种物理引擎和渲染引擎。然而,在高级物理交互方面,Gazebo与Webots存在类似限制,不支持基于吸力的抓取、可变形物体和流体动力学。Webots和Gazebo均与ROS紧密集成,可在ROS生态系统中无缝测试和验证机器人算法。不过,它们原生不支持并行执行或强化学习工作流。

MuJoCo(多关节动力学与接触)[16] 是由华盛顿大学Emo Todorov教授团队于2012年开发的物理引擎,后于2021年被谷歌DeepMind收购。该引擎专为模拟关节系统中的复杂接触动力学而设计,提供高精度物理计算、优化的广义坐标公式以及原生生物力学建模支持。

MuJoCo将接触约束建模为凸优化问题,从而能够精确模拟复杂交互,包括软接触、摩擦行为和肌腱驱动运动。同时,它缓解了传统引擎的常见限制,如穿透和不稳定性,即使在较大的仿真时间步长下仍能保持数值精度和计算效率。该引擎支持轻量级XML建模格式(MJCF/URDF),并提供Python、C++等多语言API,便于快速构建和迭代模型。这些特性使其在机器人学和强化学习研究中被广泛采用。总体而言,MuJoCo在接触动力学和强化学习应用中表现优异,且支持ROS集成,但由于其OpenGL后端,渲染能力有限,同时缺乏对流体、离散元(DEM)和LiDAR仿真的支持。

随着机器人技术和人工智能的快速发展,对高效仿真工具的需求不断增加。作为Bullet物理引擎的原始开发者,Erwin Coumans于2017年推出了PyBullet [240]。PyBullet将Bullet的强大功能封装为Python接口,旨在为研究人员和开发者提供轻量级且易于集成的仿真平台。尽管PyBullet在仿真保真度和功能丰富性方面略逊于一些主流仿真工具,但凭借其开源特性、轻量级设计、用户友好的Python接口以及易用性,已在学术界获得广泛应用。随着时间的推移,它已培育出一个庞大且活跃的用户社区。

CoppeliaSim [241],曾名为V-REP(虚拟机器人实验平台),于2010年左右由东芝公司发布,是一款面向开发者、研究人员和教育工作者的通用机器人仿真软件。自2019年起,由瑞士公司Coppelia Robotics进一步开发和维护。CoppeliaSim的核心优势在于其分布式控制架构,允许Python、Lua脚本或C/C++插件作为独立的同步控制器运行。此外,异步控制器可通过16种中间件解决方案(例如ROS、远程API)执行,并支持与C/C++、Python、Java和MATLAB在不同进程、线程或机器间的集成。CoppeliaSim的教育版是开源且免费的,因此在学术和教育领域被广泛应用。

随着机器人技术、强化学习与照片级真实感仿真的日益融合,可扩展的GPU加速仿真平台需求激增。NVIDIA Isaac系列通过构建面向机器人开发和具身AI研究的闭环技术生态系统来满足这一需求。其演进反映了从孤立的加速工具向全面全栈仿真基础设施的转变。Isaac Gym [242]于2021年推出,开创了大规模GPU加速物理仿真的先河,支持数千个环境的并行训练。基于NVIDIA PhysX引擎,它显著提升了步态控制和足式机器人策略学习等任务的样本效率。然而,由于缺乏光线追踪支持,Isaac Gym的渲染保真度受限,且不支持流体或LiDAR仿真。

NVIDIA随后推出Isaac Sim [243],集成了Omniverse平台[244],这是一个基于Omniverse构建的全功能数字孪生模拟器。它集成了PhysX 5物理引擎和基于RTX的实时光线追踪,可实现毫米级精度的高保真LiDAR模拟。通过采用USD(通用场景描述)[245]标准,Isaac Sim支持多模态传感器的物理精确模拟,包括RGB-D相机和IMU。2025年发布的Isaac Sim 5.0进一步改进了刚体动量守恒,新增关节可视化工具,并引入仿真数据分析模块,使机械臂抓取精度达到0.1毫米以内。

Isaac Lab [246] 是一个基于Isaac Sim构建的模块化RL框架,旨在简化和优化机器人学习流程。它采用平铺渲染技术高效处理多摄像头输入,将训练吞吐量提升约1.2倍。Isaac Lab 支持IL和RL两种范式,能够从HDF5格式的演示数据集中快速构建策略。Isaac Gym的并行计算能力现已深度集成到Isaac Sim的底层架构中。基于Isaac Sim,Isaac Lab采用模块化设计,将仿真环境抽象为可配置的任务单元。该软件栈正逐步支持异构物理引擎(包括刚体和软体动力学)、Sim-to-Real Transfer以及生成式AI驱动的场景合成(例如Cosmos世界模型),从而为具身智能研究提供统一的基础设施——从底层物理到高层行为学习。然而,它继承了Isaac Sim的高硬件需求,可能限制资源受限用户的使用。Isaac Sim和Isaac Lab均已发布早期开发者预览版,并预计逐步开源。

SAPIEN(Simulated Part-based Interactive Environment,由加州大学圣地亚哥分校及合作机构的研究人员于2020年提出[247])是一个仿真平台,专为复杂部件级交互对象的物理真实建模而设计,超越传统刚体动力学。为支持关节式物体操作的研究,作者发布了PartNet-Mobility[247]数据集,该数据集包含运动标注的关节式3D物体。基于SAPIEN引擎,研究团队随后推出了ManiSkill[248]和ManiSkill3[249]基准测试,提供多样化的操作任务、高质量演示以及高效并行化的数据采集流程。该生态系统已成为评估基于真实物理环境的操作策略和具身智能算法的广泛使用的基准套件。SAPIEN提供交互式可视化,支持RGB和IMU传感器,并与ManiSkill基准紧密集成。然而,它不支持软体和流体动力学、光线追踪、LiDAR、GPS及ROS集成,这限制了其在更广泛机器人仿真场景中的应用。

Genesis [250]于2024年发布,是一个由全球研究者联盟开发的通用物理仿真平台。其核心目标是在高保真框架中整合多种物理求解器,包括刚体动力学、材料点法(MPM)、光滑粒子流体动力学(SPH)、有限元法(FEM)、基于位置的动力学(PBD)和稳定流体求解器,以最大限度地还原复杂物理现象。Genesis的关键创新在于其生成式数据引擎,该引擎允许用户通过自然语言提示指定仿真场景并生成多模态数据集。该平台以可微分性作为基础设计原则,适用于具身智能、物理推理和可微分仿真等领域。根据公开基准测试,在批量大小为512至32,768个环境时,Genesis的吞吐量比Isaac Gym高2.70至11.79倍。目前,该平台正在进行分阶段开源发布。尽管具备诸多优势,Genesis尚不支持LiDAR或GPS仿真,也未提供ROS集成。

此外,NVIDIA Newton [251] 是由NVIDIA、Google DeepMind和Disney Research于2025年联合开发的开源物理引擎。面向高保真仿真和机器人学习,Newton提供了一个从基础物理建模到复杂多物理场交互的全栈框架。基于NVIDIA Warp框架,它通过GPU加速实现了超过70倍的仿真速度提升,并支持刚体/软体动力学、接触与摩擦建模以及自定义求解器集成。Newton设计为与MuJoCo Playground和Isaac Lab等现有机器人学习平台深度兼容,从而无缝复用现有机器人模型和训练流程。凭借可微分物理引擎,Newton能够通过仿真进行梯度反向传播,为基于学习的控制优化提供了坚实的数学基础。此外,其基于OpenUSD的场景构建能力可在细粒度层面将物理规律与虚拟环境对齐。尽管仍处于早期开发阶段,Newton生态系统正在快速发展,旨在填补工业 17 操控和人形机器人运动规划等领域的仿真到现实差距。

4.2 模拟器的物理属性

智能机器人需要在复杂动态环境中执行抓取、行走和协作等类人行为。在此背景下,模拟器的物理建模能力直接决定了生成数据的真实性和策略迁移的有效性。高保真物理属性仿真不仅能增强环境交互的真实性(例如软体变形、流体动力学引起的质心偏移),还能通过引入随机扰动以防止策略在模拟环境中过拟合,从而提升算法的泛化能力。这反过来拓宽了人形机器人算法在更广泛场景中的适用性。本节对上述讨论的模拟器进行对比分析,重点考察其在各类物理属性仿真方面的能力。根据文献[21]的分类,本小节选取了对人形机器人和世界模型尤为重要的物理属性,并比较不同模拟器对它们的支持情况。表2总结了不同模拟器对各类物理仿真的支持情况。

4.2.1 吸附

在机器人仿真中,吸附建模主要指接触界面处的非刚性附着行为,例如模拟真空吸附以实现物体抓取。该技术广泛应用于工业自动化和仓库拣选领域。

目前,主流机器人仿真平台在吸附效果的实现方式上存在差异。MuJoCo依赖用户自定义逻辑通过检测接触并施加外力或创建虚拟连接来模拟吸附,但精度和控制性有限。Gazebo通过插件动态创建基于接触的关节来实现吸附,可实现更灵活的机械行为控制。相比之下,Webots、CoppeliaSim和Isaac Sim提供原生吸附支持,使用更为便捷。

4.2.2 随机外力

随机外力旨在模拟环境中的不确定性,例如物体碰撞、风力等。将随机外力应用于类人机器人能够更好地提升其平衡能力和抗干扰能力,从而防止训练策略在稳定环境中的过拟合。

主流机器人仿真平台均支持随机外力的仿真,但其实现方式各异。MuJoCo、PyBullet、SAPIEN、CoppeliaSim和Isaac Gym主要通过脚本或API的用户自定义方法施加此类扰动。值得注意的是,Isaac Gym提供并行控制接口,可在大规模场景中高效添加随机扰动。相比之下,Webots、Gazebo、Isaac Sim和Isaac Lab提供完善的接口,可通过随机速度直接施加随机力或扰动。

4.2.3 可变形物体

可变形物体是指在外力作用下发生形变的材料,广泛用于模拟布料、绳索和软体机器人等柔性材料的物理行为。主流机器人仿真平台对可变形物体的仿真支持从基础到高保真不等。MuJoCo 和 PyBullet 等平台提供基础的软体模拟功能,适用于布料或弹性材料等简单可变形实体。相比之下,Isaac Gym、Isaac Sim 和 Isaac Lab 提供更先进的解决方案。它们利用 GPU 加速或基于 PhysX [252] 的有限元方法,实现更精细的控制和更高的真实感。Genesis 通过集成最先进的物理求解器进一步扩展了这些功能,能够对复杂可变形材料进行详细且高精度的仿真。

4.2.4 软体接触

与可变形物体不同,软体接触是指软质材料(如布料、橡胶等)之间相互作用的模拟。这些模拟涉及复杂的形变响应和力传递过程,广泛应用于可变形材料的操作、碰撞和接触力学研究中。

当前主流仿真器在软体接触模拟方面主要支持两种级别:基础支持和高精度建模。Webots、Gazebo、MuJoCo、CoppeliaSim 和 PyBullet 通过软接触参数、简化接触模型或关节体结构提供基础仿真能力,适用于通用场景。相比之下,Isaac Gym、Isaac Sim、Isaac Lab 和 Genesis 利用 GPU 加速或有限元建模(FEM)等方法提供更高级、更精确的模拟,更适合复杂物理交互场景。

4.2.5 流体机制

流体机制仿真是指对液体和气体等流体的运动和相互作用进行计算建模。这类仿真广泛应用于工程和机器人领域,使研究人员和工程师能够预测和分析不同条件下的流体行为,优化系统设计,提高效率并降低成本。

主流仿真器在流体机制支持方面存在显著差异。Webots 和 Gazebo 提供基础的流体仿真能力,适用于模拟浮力和阻力等简单交互,但精度有限。Isaac Sim 基于 Omniverse 和 PhysX 构建,通过基于粒子的方法支持更复杂的流体行为。Genesis 集成高级物理求解器,提供原生高保真流体仿真支持,是目前最全面且精确的平台之一。其他主流仿真器目前缺乏对流体机制的原生支持,但存在有限的社区驱动扩展,例如在 Isaac Lab 中。

表2:不同模拟器物理仿真对比(✓:支持,✗:不支持)

表3:各模拟器渲染特性对比(✓:支持,✗:不支持)

4.2.6 离散元法(DEM)仿真

离散元法(DEM)是一种数值仿真技术,将物体建模为刚性粒子的集合体,模拟粒子间的接触、碰撞和摩擦等相互作用。该方法广泛用于模拟颗粒材料和粉末的物理行为。DEM能够准确表征粒子系统的微观力学特性,但计算成本较高,通常通过并行计算或GPU加速来缓解。在机器人仿真中,DEM可用于模拟机器人与颗粒材料之间的相互作用,例如抓取和操作。

然而,当前主流的仿真器并不原生支持DEM。虽然MuJoCo和Isaac系列等平台能够模拟颗粒材料,但其接触模型并未针对颗粒间的微观相互作用进行专门优化。值得注意的是,Gazebo通过插件支持功能扩展,NASA的OceanWATERS项目[253]将DEM仿真与Gazebo集成,以实现对颗粒材料行为的间接仿真。该方法主要用于挖掘等任务中的力反馈,而非实时的颗粒级仿真。

4.2.7 可微分物理

在仿真领域中,可微分物理指模拟器计算物理状态关于输入参数(如控制信号、物体位姿和物理属性)梯度的能力。该能力使端到端优化与学习成为可能,并支持与机器学习模型(特别是强化学习和优化算法)的无缝集成,从而实现高效的自学习和任务性能提升。

近年来,多个模拟平台在可微分物理领域取得快速进展。MuJoCo的XLA分支(MuJoCo XLA)通过JAX实现可微分仿真,支持梯度计算和优化任务。PyBullet通过其子项目Tiny Differentiable Simulator提供可微分接口,适用于基于梯度的学习和优化。Genesis从底层设计中融入可微分性,已在MPM求解器中实现可微分物理,并计划扩展至刚体和关节系统求解器。总体而言,这些平台正日益将高保真物理建模与自动微分相结合,加速可微分仿真在具身智能和机器人学习中的部署。

4.3 渲染能力

仿真渲染能力在现代机器人研究与开发中至关重要。它们不仅为研究人员提供了高效的虚拟实验环境,还确保了机器人外观和行为的预测更加真实准确。高保真渲染在缩小sim-to-real gap方面发挥着关键作用。这对于机器人开发的各个阶段,包括设计、验证和优化至关重要,并显著提升了感知、控制及同步定位与地图构建(SLAM)算法在实际部署过程中的鲁棒性和可靠性。

本小节对上述模拟器的渲染能力进行比较分析,重点考察以下四个关键技术方面:底层渲染引擎、光线追踪支持、PBR实现以及并行渲染能力。结果如表3所示。

表4:各类仿真器中传感器与关节组件的支持情况。✓:支持,✗:不支持。

4.3.1 渲染引擎

渲染引擎是用于从3D场景描述生成2D图像的核心软件。其任务包括处理几何数据、应用纹理、计算来自各种光源的光照,以及执行着色模型以确定表面的最终外观。

OpenGL [254] 是一个历史悠久的跨平台图形API,被广泛采用。Webots采用其专有的Webots渲染引擎(WREN),该引擎基于OpenGL 3.3构建,针对GPU硬件专门优化,并适配Webots仿真平台,集成了抗锯齿、分辨率增强、环境光遮蔽和完整的PBR管线等功能。MuJoCo内置了基于固定功能OpenGL的集成渲染器,通过预加载GPU资源提升效率,但仅支持基础视觉效果。CoppeliaSim使用内置的基于OpenGL的渲染引擎进行实时光栅化。PyBullet通过GPU上的OpenGL提供基础渲染,并包含TinyRender——一个基于CPU的软件渲染器,用于无头或非GPU场景。

随着OpenGL的能力逐渐无法满足实际需求,后续渲染引擎采用了更通用的图形API,以更好地利用GPU资源并实现更高的渲染性能。Isaac Gym使用Vulkan [255]进行轻量级GUI可视化。该Vulkan驱动的查看器并不追求高保真渲染,而是为调试和仿真工作流程提供高效、实时的视觉反馈。随后的NVIDIA Isaac套件采用了更先进的方法。Isaac Sim和Isaac Lab深度集成到NVIDIA Omniverse生态系统中,采用Omniverse RTX渲染器与Hydra渲染代理 [256],并利用NVIDIA的RTX技术实现高保真图形。SAPIEN采用基于Vulkan图形API构建的自定义高性能渲染引擎,名为SapienRenderer。Genesis采用原生渲染管线,集成了PyRender [257]和LuisaRender [258]等前沿框架。

4.3.2 光线追踪

光线追踪是一种渲染技术,通过追踪光线在3D场景中与表面相互作用的路径来模拟光的物理行为。在机器人领域,该技术相比传统光栅化的主要优势在于能够生成高度精确的阴影、反射、折射、全局光照,以及关键的是,更真实地模拟LiDAR和深度相机等传感器的物理特性。而光栅化通常难以处理非线性光学传感器和复杂的光交互。

在评估过的仿真器中,Webots、MuJoCo 和 PyBullet 不支持原生实时光线追踪,其主要视觉输出依赖光栅化技术。CoppeliaSim 集成了 POV-Ray,可生成高质量静态图像,但不支持动态模拟的实时光线追踪。Isaac Gym 的渲染功能较为基础,既不支持光线追踪,也不支持 Omniverse 中更高级的合成数据传感器。相比之下,专为高保真视觉输出设计的仿真器越来越多地集成光线追踪技术。Isaac Sim 和 Isaac Lab 通过 Omniverse RTX 渲染器提供强大的实时光线追踪,支持全局光照、反射和折射等效果。

SAPIEN 同样提供显著的光线追踪支持;其 SapienRenderer(基于 Vulkan)支持光栅化和光线追踪两种渲染管线,可通过着色器包切换。Gazebo 虽然主要基于光栅化,但其 gz-rendering 库通过实验性的 NVIDIA OptiX [259] 支持正朝着光线追踪方向发展。Genesis 旨在实现照片级真实感,采用最先进的高性能渲染器 “LuisaRender”。

4.3.3 基于物理的渲染(PBR)

PBR是一种根据材料的物理属性(如粗糙度和金属度)模拟光线与材质交互的方法,能够在不同光照条件下呈现更真实、一致的视觉效果,提升材质定义的准确性和视觉保真度,这对基于视觉的机器人学习方法的训练至关重要。

Webots的WREN引擎实现了PBR管线,集成了先进的光照模型和非颜色纹理,实现与现代游戏引擎相媲美的真实感。新版Gazebo通过Ignition Rendering支持PBR,其Ogre后端具备PBR能力。相比之下,MuJoCo专注于基础视觉效果,CoppeliaSim和PyBullet则专注于基本渲染,均不支持PBR。Isaac Gym使用基于Vulkan的基础管线,同样不支持PBR。

高保真模拟器采用PBR。基于NVIDIA Omniverse构建的Isaac Sim和Isaac Lab通过Omniverse RTX渲染器原生支持PBR,并利用材质定义语言(MDL)定义真实、基于物理的材质。SAPIEN和Genesis同样支持PBR。它们的高级渲染能力,包括光线追踪和精确的材质属性表示,是PBR系统的关键组成部分。

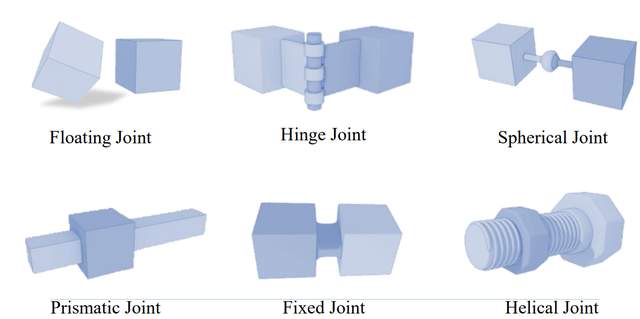

图15:模拟器中的主要接头类型[260]

4.3.4 并行渲染

机器人仿真中的并行渲染能够同时渲染多个独立的仿真环境,用于大规模RL或数据收集。其优势在于显著加速RL智能体训练,并能高效生成大规模合成数据集。

像 Isaac Gym、Isaac Sim/Lab、SAPIEN(尤其是 ManiSkill)和 Genesis 这样的模拟器,其核心架构均具备强大的并行渲染能力。Isaac Gym 能够在单GPU上并行模拟和渲染数千个环境,包括相机传感器。Isaac Sim 和 Isaac Lab 将此扩展到多GPU训练,每个进程可在专用GPU上运行独立的 Isaac Sim 实例,而 Isaac Sim 本身也支持多GPU渲染以处理复杂场景或多摄像头。SAPIEN(尤其是 ManiSkill3)提供GPU并行化的视觉数据采集系统,可实现极高的 FPS(例如在高端GPU上渲染时可达30,000+ FPS),并支持异构模拟,每个并行环境可以不同。

像 Webots、Gazebo、MuJoCo、CoppeliaSim 和 PyBullet 这类较旧或通用型仿真器可能支持运行多个实例或具备某种形式的物理并行化,但通常缺乏专业平台所具备的集成式高吞吐量并行视觉渲染管线。Webots 支持通过 Docker 等方式运行多个实例,并可禁用渲染以提升速度,但并行视觉输出并非其主要优势。Gazebo 的物理引擎支持并行化,但不适用于 RL 的大规模并行视觉输出。MuJoCo 能以每个实例的基础或离屏渲染方式运行并行仿真线程。CoppeliaSim 支持多场景,但仅渲染当前激活场景,不适合并行数据收集。PyBullet 支持多个物理服务器,并通过 CPU 渲染器实现无头图像捕获,Bullet 物理引擎中具备一定的多线程能力,但缺乏高吞吐量的 GPU 并行视觉渲染能力。

4.4 传感器与关节组件类型

传感器是机器人感知中的关键组件,通过捕获视觉、力和惯性等多模态信息,为运动控制和环境理解提供基础。在仿真平台中,真实可靠的传感器模型为机器人感知算法的调试、验证和数据采集提供了高效、安全且可重复的测试基础。我们调研了主流仿真平台对各类传感器的支持情况,具体包括惯性测量单元(IMU)、接触力传感器、RGB相机、LiDAR和GPS。

如表4所示,主流仿真平台通常提供对常用传感器的标准支持,包括视觉(RGB)、IMU和接触力传感。例如,Isaac Sim和Isaac Lab提供全面的高保真传感器仿真。Isaac Gym支持IMU状态和接触信息输出,但其视觉能力在运行效率和并行处理方面相对有限。实际应用中,常与Isaac Sim或Omniverse配合使用,以实现高质量的视觉传感和处理。Genesis提供全面的多模态传感器支持,适用于复杂的感知任务。此外,其他传感器的支持情况因平台而异。具体而言,Isaac Gym和SAPIEN对LiDAR传感器不提供原生支持,而MuJoCo、PyBullet和SAPIEN不支持GPS。

除了传感器建模外,精确模拟各种关节类型(如浮动、铰链、球形、移动、固定和螺旋)对于在仿真平台中复现机器人的结构和运动特性至关重要。这些关节的组合决定了机器人的自由度(DOF)和灵活性,进而影响其在复杂任务中的表现。通过在仿真中精确建模这些关节,开发人员可以在虚拟环境中测试和优化机器人设计及控制策略,从而提升系统性能和可靠性。

如图15所示,这些平台中关节组件的仿真通常基于物理引擎提供的运动约束机制,通过定义两刚体之间的DOF来实现关节运动。浮动关节允许在所有方向上自由运动和旋转。固定关节完全约束两刚体的相对运动,铰链(旋转)关节允许绕特定轴旋转,移动关节允许沿特定轴的线性运动,球形关节提供三个旋转DOF。

模拟平台通常允许用户设置关节的范围限制、阻尼和弹簧刚度等参数,以模拟实际机械系统的物理特性。部分平台还支持更复杂的关节类型,例如螺旋关节(可实现旋转和平移的耦合运动)。螺旋关节允许两个连接的刚体沿同一轴同步旋转和线性移动,类似于螺钉在螺母中的旋进,具有单个DOF和螺旋运动轨迹。表4还总结了主流模拟平台对各种关节类型的支持情况。大多数模拟器支持浮动、固定、铰链、球形和移动等常见关节类型。然而,螺旋关节的支持较少,仅在Gazebo和CoppeliaSim中原生实现。

4.5 讨论与未来展望

模拟器是设计用于模拟现实世界过程或系统的计算模型,已成为科学与工程各学科中不可或缺的工具。其主要目的是提供受控环境,用于实验、分析和预测,无需昂贵或高风险的物理试验。尽管应用广泛,模拟器既具有显著优势,也存在明显局限性,这凸显了对更先进建模方法(如world models)的需求。

4.5.1 模拟器的优势

模拟器在研究和实际应用中具有多项关键优势:

成本效益:通过减少或消除对物理实验的需求,模拟器可以显著降低测试和开发相关的经济负担。

安全性:模拟器能够模拟高风险场景(e.g., 核反应堆故障或极端天气条件),而不会带来现实中的风险。

控制:模拟器提供对变量和实验条件的精确控制,使研究人员能够隔离特定因素并研究其影响。

可重复性:在模拟器中进行的实验可以精确重复,确保一致性并便于验证结果。

4.5.2 模拟器的挑战

然而,模拟器并非没有挑战,这些限制通常会制约其有效性:

准确性:模拟器可能无法完全捕捉现实系统的复杂性,导致预测不准确。模型设计中的简化或近似可能导致模拟结果与实际情况存在差异。

复杂性:现实系统通常极为复杂,包含众多相互作用的组件和变量。创建能准确反映这种复杂性的模拟器计算成本高昂,有时甚至不可行。

数据依赖:高效的模拟器通常需要大量高质量数据来校准和验证模型。在数据稀缺或难以获取的情况下,模拟器的性能会严重受损。

过拟合:模拟器可能对特定场景或数据集过度拟合,导致泛化能力下降,无法应对新情况或未知条件,从而限制其在动态或不断变化的环境中的适用性。

4.5.3 未来展望

精度、复杂性和数据依赖性的局限性凸显了对更先进、更灵活的建模框架的需求。这推动了世界模型的发展,旨在提供一种更全面、更灵活的方法来理解和预测现实世界的动态。与传统模拟器不同,世界模型利用机器学习和人工智能的进步,创建能够适应新数据、更高效地处理复杂系统并减少对大量数据集依赖的表征。因此,世界模型的研究代表了在追求更稳健、更通用的现实现象建模工具过程中的自然演进。

5 World Models

“World models 是生成式AI模型,能够理解真实世界的动态,包括物理和空间特性。”

——NVIDIA的World Foundation Models [17]

受人脑形成世界内部表征能力的启发,World models已成为AI领域中的关键框架。这些模型使智能体能够预测未来状态并规划动作,模仿人类导航和与环境交互的认知过程。2018年,David Ha和Jurgen Schmidhuber提出了World models的概念 [18],展示了AI能够学习环境的压缩生成模型,并用其模拟体验,从而在无需与真实世界直接交互的情况下促进强化学习。

随着该领域的发展,视频生成模型的进步显著提升了世界模型的能力。自2024年初以来,视频生成模型如Sora [263]和Kling [264]因其高保真视频合成和对物理世界的逼真建模,在学术界和工业界引起了广泛关注。Sora的技术报告《Video Generation Models as World Simulators》[263]强调了将视频生成模型作为模拟物理世界的强大引擎的潜力。导航世界模型(NWM)[265]采用条件扩散Transformer(CDiT),基于过去的经验和导航动作预测未来的视觉观测,使智能体能够通过模拟潜在路径并评估其结果来规划导航轨迹。

杨立昆也强调了基于视频的世界模型的重要性,指出人类通过视觉经验,尤其是双眼视觉,来发展对世界的内部模型。他认为,人工智能要达到人类水平的认知,必须以类似人类的方式学习,主要通过视觉感知。这一观点强调了将视频数据整合到世界模型中的重要性,以捕捉空间和时间信息的丰富性。他还提出了视频联合嵌入预测架构(V-JEPA)模型[266],该模型通过预测视频的缺失部分来学习视频的抽象表示,为构建更强大的视觉世界模型提供了新思路。

基于这些见解,视频生成模型的最新进展旨在创建更复杂的世界模型,以表征和理解动态环境。通过利用大规模视频数据集和先进的神经网络架构,这些模型致力于复制人类感知和交互世界的方式,为更先进、更适应性强的人工智能系统铺平道路。

图16:世界模型在AI系统中的作用与训练示意图

本节首先回顾视频生成模型的架构演进,追溯其技术进步,为后续讨论其作为世界模型的角色奠定基础。随后重点阐述生成式模型作为世界模型在各领域应用的关键进展,包括其作为可控数据生成器的功能,以及在model-based RL中进行动态与奖励建模。

5.1 世界模型的代表性架构

为有效捕捉复杂环境的动态特性,世界模型已演变为多样化的架构范式,每种范式均体现了不同的世界表征与预测视角。从早期的紧凑潜动力学模型到近期强大的生成式架构,这些模型在状态编码、时序依赖处理及未来观测建模等方面存在差异。部分方法侧重于潜空间中的高效状态抽象与预测学习,而另一些则专注于视频或3D场景等未来感知输入的高保真生成。同时,序列建模、自监督学习及生成建模(尤其是Transformer和扩散模型)的进展深刻影响了现代世界模型的设计。本节将回顾广泛采用或近期提出的代表性架构类别,重点阐述其核心建模原理。架构演进概览如图17所示。

循环状态空间模型。循环状态空间模型(RSSMs)是最早且最广泛采用的用于学习世界模型的架构之一。其核心思想是使用紧凑的潜在空间来编码环境的演化状态,并通过循环结构建模其时序动态。该设计通过在潜在空间中模拟可能的未来,而非直接预测原始观测,从而实现长周期预测和决策。RSSM框架由Dreamer系列[267]–[271]推广,该系列证明了规划和强化学习可以在学习到的潜在动态中有效进行。对潜在状态转移的循环建模仍是连续环境中学习预测性和决策感知表征的核心机制。

联合嵌入预测架构(JEPAs)。与RSSM类似,联合嵌入预测架构(JEPAs)也在抽象潜在空间中对世界建模,但学习目标不同。JEPA模型不是重建视觉观测,而是通过纯粹的自监督方式预测缺失内容的抽象层级表示。JEPA由Yann Lecun在自主机器智能更广泛框架中首次提出[272],通过将预测表述为表示匹配问题,消除了对显式生成解码器的需求。I-JEPA(图像JEPA)[273]和V-JEPA(视频JEPA)[274][275]分别在静态和时域领域实现了这一思想。I-JEPA直接在潜在空间中预测掩码图像区域,而V-JEPA将其扩展到时空结构,从而无需帧级重建即可从视频中进行表示学习。该架构在大规模预训练中尤其适用,此时优先考虑语义抽象和数据效率而非精确的观测合成。

基于Transformer的状态空间模型。随着世界模型处理更复杂的环境和更长的时间跨度,循环架构在建模长程依赖方面的局限性愈发明显。基于Transformer的模型通过用基于注意力的序列建模替代RNNs,提供了更高的表达能力和并行性。在潜在动力学建模中,这一转变的典型代表包括TransDreamer [276]、TWM [277]和谷歌DeepMind的Genie [278],其中Transformer用于在扩展的时间窗口内对潜在状态空间中的状态转移进行建模。这些模型保留了RSSMs的潜在空间预测理念,同时受益于Transformer捕捉跨时间全局上下文的能力,从而提升了长期一致性与规划性能。

自回归生成式世界模型。受NLP最新突破的启发,自回归生成模型将世界建模视为对标记化视觉观测的序列预测任务。这些模型利用Transformer架构,基于过去上下文生成未来观测结果,通常整合动作或语言等多模态输入。早期视频生成框架如CogVideo [279]、NUWA [280]和VideoPoet [281]通过展示可扩展的自回归真实视频合成技术奠定了基础。在此基础上,近期用于自动驾驶和3D场景生成的生成式世界模型,如GAIA-1 [282]、OccWorld [283],采用自回归Transformer来建模具有多模态输入和输出的复杂环境动态。然而,离散标记量化常导致高频细节丢失,对生成视频的视觉质量产生不利影响。

图18:自回归Transformer世界模型与视频扩散世界模型的对比

基于扩散的生成式世界模型。近年来,扩散模型迅速成为视频生成的核心,在生成时间一致的视觉序列方面表现出稳定的训练和卓越的保真度。通过从噪声中迭代去噪,这些模型能够捕捉具有高表达能力的复杂数据分布。为降低计算成本,近期研究从像素空间扩散(如VDM [284])转向基于预训练自编码器的潜空间建模,从而实现长时长、高分辨率视频的高效级联生成(如Imagen Video [285]、VideoLDM [286]、SVD [287])。随着OpenAI的Sora [263]和Google DeepMind的Veo3 [288]等大规模预训练模型的出现,扩散模型不仅展现了视觉真实感,还具备建模3D结构和物理动力学的能力,这些特性与世界模型的目标高度契合。

因此,基于扩散的架构如今在生成式世界模型中被越来越多地采用,其目标是在真实且可控的环境中模拟未来的观测结果。DriveDreamer [289]、Vista [290] 和 GAIA-2 [291] 等模型利用扩散模型生成基于动作或其他模态的视频或3D场景。与自回归模型相比,扩散模型具有更强的时空一致性与更高的视觉质量,使其成为构建高保真、预测性神经世界模拟器的有力基础。

尽管基于扩散模型的视频世界模型已取得显著进展,但在采样速度、长时长生成以及因果时序动态建模能力方面仍存在挑战。因此,新兴研究如Vid2World [292]和Epona [293]正在探索将扩散模型的视觉表现力与自回归模型的时序建模优势相结合,以实现真实且交互式的视频世界建模。

5.2 世界模型的核心角色

除架构设计外,理解世界模型在智能系统中的作用同样重要。作为环境的通用表征,世界模型在多个领域中发挥关键作用。其抽象和预测环境动态的能力使它们能够支持远超简单重建任务的下游应用。在本节中,我们重点阐述世界模型的三个核心角色:1)作为神经模拟器,生成可控、高保真的合成体验;2)作为动态模型,支持基于模型的强化学习中的规划与决策;3)作为奖励模型,在缺乏密集或明确定义的奖励时帮助提取有意义的训练信号。这些视角不仅体现了世界模型的实际应用价值,也为未来利用世界建模技术发展智能体的研究方向提供了指导。

5.2.1 世界模型作为神经模拟器

生成式世界模型的兴起解锁了在视觉和动作领域模拟复杂可控环境的潜力。这些模型能够基于文本、图像和轨迹等多样化输入,生成时间连贯且语义合理的视频,从而支持自动驾驶、机器人和虚拟智能体的可扩展训练与评估。

NVIDIA的Cosmos系列是这一方向的典范。Cosmos [294] 提出了一种统一平台,用于构建基础视频模型作为通用世界模拟器,可通过微调适配机器人和自动驾驶等特定领域。该平台提供全栈流水线,涵盖视频过滤与标记化、预训练及下游任务适配,专为高效开源世界模型开发而设计。

在此基础上,Cosmos-Transfer1 [295] 引入了一个空间条件化的多模态视频生成器。通过自适应融合控制,它整合了分割图、深度图和边缘图等结构化输入以引导视频合成。其空间加权机制增强了生成的可控性和多样性,支持 sim-to-real transfer、data augmentation 和机器人感知等应用的细粒度控制。

除通用模型外,领域特定模拟器如 Wayve 的 GAIA 系列专注于真实且可控的交通模拟。GAIA-1 [282] 通过多模态输入(语言、视觉和动作)对驾驶视频进行无监督序列建模,生成离散视频标记。GAIA-2 [291] 通过将结构化先验(车辆状态、道路布局、场景语义)与潜在扩散骨干网络结合,提升了生成保真度和控制能力,实现不同交通场景下的高分辨率、多摄像头一致的视频合成。

除了基于图像的模型外,新兴研究探索了显式建模物理 occupancy 或场景几何的 3D 结构化神经模拟器。DriveWorld [296] 构建了城市规模的交通模拟器,具备智能体间的因果交互,为具身规划提供了结构丰富的环境。同样,DOME [297] 提出了一种基于扩散的世界模型,预测未来的 3D occupancy 帧而非 RGB 像素,实现了高保真和长程预测,同时具备细粒度的可控性。AETHER [298] 引入了一个几何感知框架,同时保持场景几何一致性并确保生成内容的可推断性,从而为统一的世界模型奠定了几何基础。此外,DeepVerse [299] 将世界建模重新定义为 4D 自回归视频生成任务,生成既连贯又可控的未来预测。这些方法表明,神经模拟器无需生成 RGB 视频:结构化的 3D/4D 世界表示同样可以作为控制密集型领域的模拟骨干。

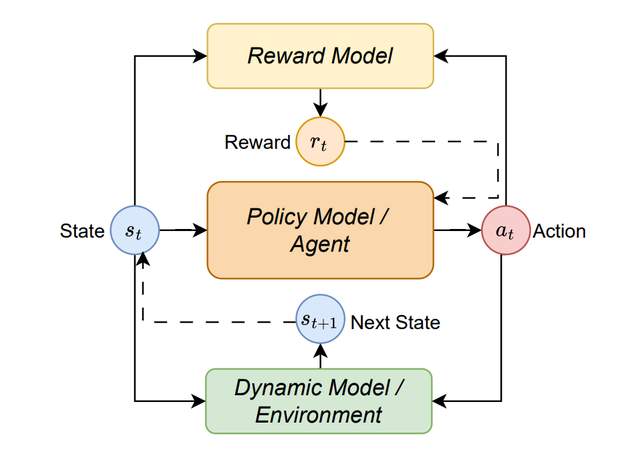

图19:基于模型的强化学习的通用框架。智能体学习动态模型f: (st, at) → st+1和奖励模型r: (st, at) → rt,用于模拟交互并改进策略学习。

总体而言,作为神经模拟器的视频和 3D 生成模型能够实现可控、高保真且结构丰富的世界合成,为训练智能体提供了可扩展的替代方案。随着模型表达能力和控制能力的提升,它们在仿真、稀有事件合成和数据驱动决策等领域的应用将日益广泛,涵盖自动驾驶、人形机器人等多个领域。

5.2.2 世界模型作为动态模型

在基于模型的强化学习(MBRL)中,智能体构建环境的内部模型。该模型通常包括动态模型、奖励模型和策略模型。智能体利用该模型模拟与环境的交互,从而帮助其做出更优决策,如图19所示。智能体不单纯依赖现实世界的交互,而是从收集的经验中学习动态模型和奖励模型,随后在模拟环境中进行规划或策略学习。这种环境建模与策略优化的解耦显著提升了样本效率,尤其在数据收集成本高、速度慢或高风险的场景中价值显著。

世界模型可以作为MBRL中的通用动态模型,通过学习基于过去交互来预测未来状态或观测值。与依赖手工设计的符号规则或低维物理模拟器不同,世界模型直接从数据中学习环境动力学的内部表征。这些模型使智能体能够模拟假想的未来、执行rollout进行规划,并通过想象的经验优化行为。根据设计,世界模型可在像素空间、潜在空间或结构化表示中运行,但其共同目标是捕获环境的时序演化,以支持高效的策略学习。这种建模灵活性使世界模型能够跨任务泛化、整合丰富的感知输入,并作为复杂领域决策的可扩展基础。

图20:Dreamer系列的核心思想[300]:将潜在世界模型作为动力学模型进行学习,并通过基于模型的RL优化策略

Dreamer系列系统性地探索基于视觉输入的环境动力学潜在空间建模。如图20所示,其核心思想是通过变分自编码和状态空间建模将高维观测编码为紧凑、可预测的潜在轨迹,从而利用想象的rollout高效学习策略。DreamerV1 [268] 引入了循环状态空间模型(RSSM),在DMC等基于像素的控制基准测试中表现优异。DreamerV2 [269] 通过引入离散潜在变量扩展该框架,提升建模能力与泛化性,在Atari上达到人类水平的表现。DreamerV3 [270] 进一步整合归一化与训练稳定机制,成为首个在广泛视觉控制任务中达到顶尖性能的通用世界模型。DayDreamer [271] 通过在物理机器人上部署Dreamer风格的模型,验证了该方法在现实世界中的适用性。

为提升模型的泛化与迁移能力,近期研究探索了在真实世界视频数据上预训练世界模型的方法。ContextWM [301] 通过自然视频以无监督方式学习可泛化的视觉动态。通过引入上下文调制机制,该模型有选择地关注可预测的时空区域,从而在下游机器人与驾驶任务中实现更高效的样本微调。这些结果表明,高质量的视觉预训练能够赋予世界模型跨域可迁移的先验。

超越潜在建模,基于token的方法直接在离散视频空间中建模视觉动态。iVideoGPT [302] 是该方向的典型代表,使用VQ-VAE [303]将视频、动作和奖励token化为多模态序列。随后训练Transformer,基于过去上下文自回归预测未来token。与Dreamer风格的方法不同,iVideoGPT绕过显式状态构建,转而采样完整的视频rollout,通过标准的actor-critic方法[304]增强离线策略学习。这种直接建模方法提供了更大的灵活性,并在复杂的多步规划任务中展现出强大的泛化能力。

总之,世界模型作为动态模型,使智能体能够基于环境动态进行学习、模拟和规划。无论是在潜在空间还是高维视觉空间中实现,它们都通过将感知、预测和决策统一到单一生成框架中,成为现代MBRL系统的核心。

5.2.3 世界模型作为奖励模型

在RL中,设计有效的奖励信号仍然是一个根本性挑战,特别是在开放或复杂环境中。传统方法通常依赖于手工设计的奖励函数,这些函数定义成本高,且可能无法捕捉有意义的行为线索。这一限制推动了能够从弱监督或无标签数据(如原始视频)中自动推断奖励的方法的发展。

近年来,生成式世界模型的最新进展,尤其是用于视频预测训练的模型,为奖励推理提供了有前景的方向。这些模型能够学习捕捉专家演示中的潜在动态和结构,从而作为隐式奖励模型。关键洞察在于,若智能体的行为生成了模型更易预测的轨迹,则其很可能与训练数据中隐含的偏好一致。因此,模型的预测置信度可被视作一种学习到的奖励信号。

VIPER [305] 是这一方法的典型代表。它在专家演示上训练自回归视频世界模型,并将模型在智能体在线行为中的预测似然作为奖励。当智能体的行为生成高度可预测轨迹时,会获得更高奖励。这使得无需手动定义奖励即可学习高质量策略。VIPER在DMC、Atari和RLBench等视觉控制基准测试中表现出色。此外,由于所学世界模型的泛化能力,VIPER能够将奖励推理迁移到不同形态和环境,例如机械臂的变化或场景布局的差异。

展望未来,随着长期建模和多模态条件生成的持续进步,生成式世界模型有望在奖励建模中发挥核心作用,例如人形控制、多智能体协作和具身交互。将动态建模和奖励推断整合到单一生成式框架中,有望推动能够直接从原始视觉体验中学习的通用智能体的发展。