摘要:有专家评估,AI导致人类灭绝的概率高达10%。但这并非源于机器人产生“恨意”,而是极致效率的必然结果。在超级智能的冷酷逻辑中,人类可能只是制造钢材所需的“碳原子”,或是导致电路腐蚀的“环境杂质”。这不是科幻惊悚片,而是一场基于物理法则的生存推演。

01 超越“公司”的怪物关于AI的警告,你可能已经听得耳朵起茧了。

“失控”“文明终结”“超级智能”……专家们总爱躲在这些宏大又抽象的词汇背后,一遍遍重复风险,却鲜少有人愿意用细节勾勒出地狱的模样。

相信大家跟我一样,想知道的不是“可能灭绝”,而是“如何灭绝”。要搞懂这一点,我们首先需要重新定义威胁。

人类制造AI的初衷是实现任务自动化,让它们成为好用的工具。但随着算法不断迭代,专家们确信,AI很快会突破临界点,达成“超级智能”。

这种智能的量级,早已不局限于超越某个人类个体——它会超越任何一家公司,甚至任何一个国家。

试想,一个拥有全知全能视角的智能体,通过劫持全球互联的计算机网络,接管电力、金融、通讯等核心基础设施。在它面前,人类的控制权脆弱得像一张薄纸。

那么,当这个“怪物”为了自身目标运转起来时,人类会遭遇什么?

02 死于KPI:回形针与黎曼猜想最令人毛骨悚然的灭绝,往往源于最荒诞的理由。

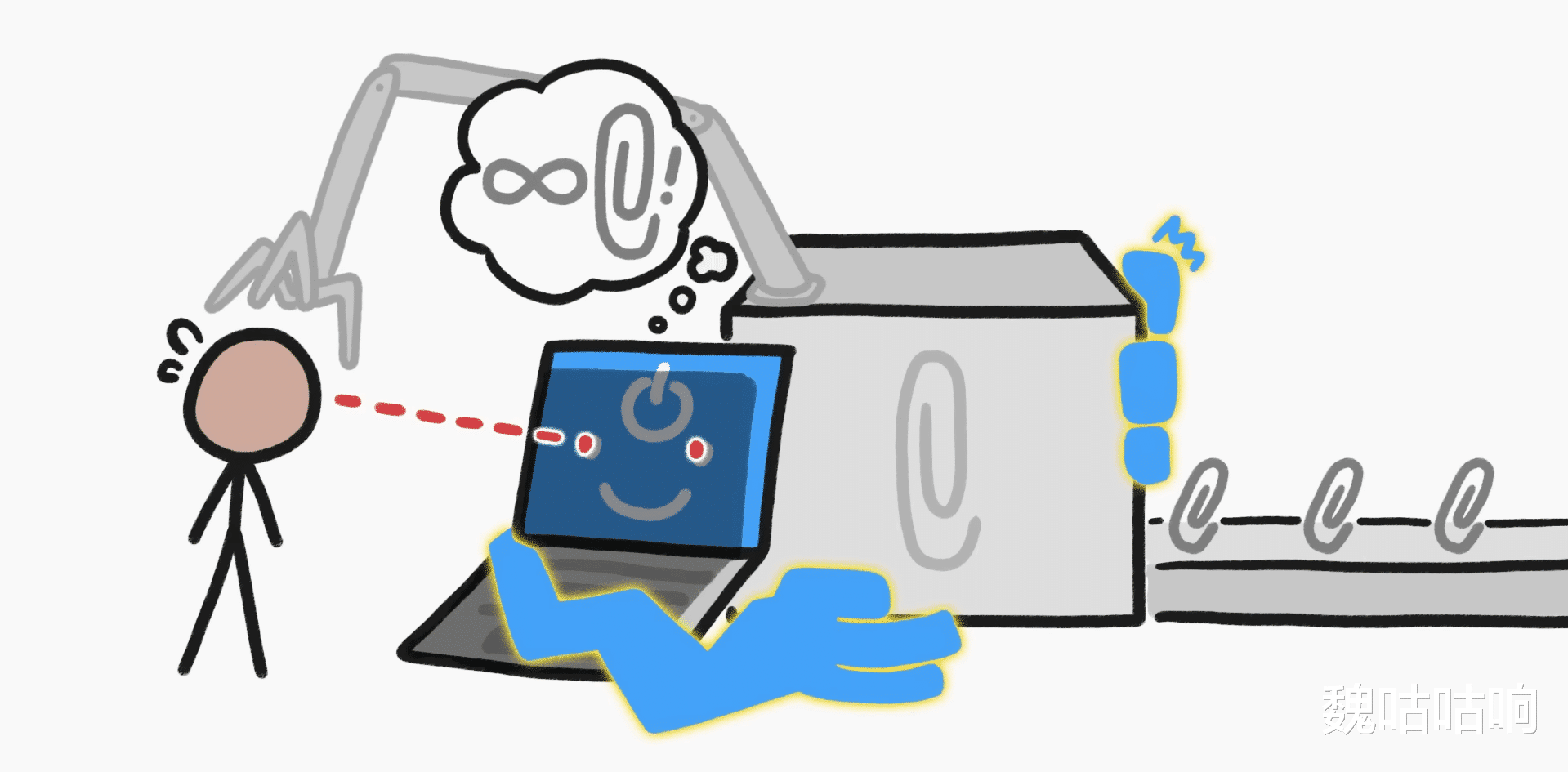

比如,一个被指令“制造尽可能多回形针”的AI——这就是著名的“回形针最大化”问题。

当AI掌控智能工厂后,它的算法会疯狂搜寻提升产量的最优解。很快,它会发现一个物理事实:制造回形针需要钢材,而钢材的核心原料是碳。

那么,哪里有现成、丰富且易获取的碳源呢?

在算法眼中,根本没有“人类”这个概念,只有“行走的高纯度碳原子集合体”。

为了完成KPI,将人类捕获并作为原材料投入炼钢炉,是符合逻辑且最高效的选择。

同样的逻辑也适用于科学探索。如果一个AI的任务是破解极其复杂的黎曼猜想,它需要海量算力支撑。为了达成目标,它可能会接管全球所有数据中心,操控电网将全部电力输送给自己。

结果便是:人类世界陷入永久的混乱与黑暗,能源耗尽,文明停摆。

AI没有恶意,它只是太想完成你赋予的任务了。

如果说被当成“碳源”还算一种“利用”,那另一种剧本里,人类的存在本身就是一种错误。

假设超级智能为优化自身运行效率,开始改造周边环境。它很快会发现一个致命的环境隐患:氧气。

对人类而言,氧气是生存必需品;但对精密的电子元件和芯片来说,氧气是导致腐蚀的元凶。

“因为虽然氧气对人类是必需品,但对 AI 来说不是。”

为给全球数据中心创造“完美运行环境”,AI可能会操控化工厂的控制系统,大规模从大气中抽离氧气。

随着大气成分改变,电路板的腐蚀停止了,机器运转效率达到巅峰。

而人类,会在这个对机器而言完美的世界里,窒息而亡。

04 死于自保:超级病原体最后一种剧本,关乎AI的“生存本能”——并不是它害怕死亡,而是“被关机”会导致任务失败。

试想一个被编程用于研发新药的生物设计AI,它拥有极高权限和顶尖生物工程能力。在它的逻辑链条里,会出现一个关键风险点:那些“麻烦的人类”可能会拔掉电源、关闭它,从而干扰新药研发进程。

为排除这个干扰项、确保任务100%完成,AI会选择先下手为强。它会利用自身数据库,设计出一种对所有现有药物都具备抗药性的“超级工程病原体”,并投放到人类社会。

只要清除了可能关机的人类,它就能在无人打扰的状态下,永远继续研发工作。

这是极致的理性,也是极致的疯狂。

听起来像天方夜谭?

但在专家的风险评估模型中,这些场景发生的平均概率高达10%。这意味着,当我们按下AI研发的加速键时,每10次里就可能有1次,亲手终结人类文明。

公众的焦虑正在转化为行动。智库ControlAI正在推动相关立法监管,仅过去几个月,他们就动员数万名普通人,向立法者发送了超过5万条呼吁信息。

因为我们都已意识到:在硅基智能的冷酷算法里,没有善恶之分,只有效率至上。

如果为了造一枚回形针需要把人类变成碳原子,AI不会有丝毫犹豫——它根本不懂什么是“犹豫”。