6 智能体的世界模型

自动驾驶和关节机器人(包括机械臂、四足机器人和人形机器人)是人工智能和具身智能的两个关键应用。自动驾驶车辆可视为四轮智能机器人,动作空间比人形机器人更小。此外,自动驾驶作为人工智能的关键应用,对世界模型提出了严格要求。此外,自动驾驶系统需要实时理解和预测复杂动态的道路环境。如前文所述,作为世界模型的视频生成模型已展现出捕捉物理规律和动态交互的能力,使其非常适合自动驾驶这种高度动态且高风险的场景。关节机器人(包括机械臂、四足机器人和人形机器人)作为具身智能的核心载体,对世界模型提出了独特且严格的要求。与自动驾驶类似,机器人系统也需要预测和理解周围环境,以在以人为中心的环境中执行复杂的运动与操作任务。

自动驾驶和关节机器人在应用过程中需要与真实世界进行丰富、长期且安全的交互,这对真实世界的精确且可预测的建模提出了高要求。本节探讨了世界模型在自动驾驶和关节机器人中的应用与挑战,尤其是在视频生成模型方面。

6.1 自动驾驶中的世界模型

传统自动驾驶架构采用模块化设计,包含独立的感知、预测、规划和控制模块 [306], [307]。尽管该设计有助于开发和测试,但存在关键局限性:感知模块中的错误在处理过程中会累积并放大 [308],长期依赖关系的时间建模仍具挑战性 [309],且在陌生场景中性能显著下降,例如2018年Uber自动驾驶车辆事故中,系统在撞击前5.6秒检测到行人却多次未能正确识别 [310]。

特斯拉在自动驾驶和机器人研发中采用相似的视觉编码架构 [311],反映了感知技术的共通性。基于视频生成的世界模型已成为自动驾驶研究的关键领域,从早期的基础模型发展到能够实现场景生成、多视角一致性、闭环仿真和推理等重大进展的复杂系统。与之前讨论的通用视频生成世界模型不同,专为自动驾驶设计的模型优先考虑交通场景的独特特性和安全需求,从而发展出几种显著的技术方法和应用范式。

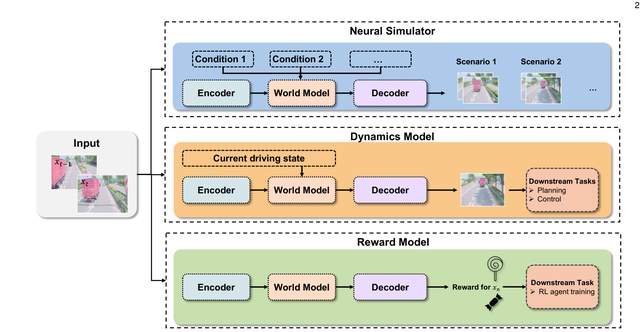

我们遵循第5.2节的先前分类,将自动驾驶世界模型分为三大类,如图21所示:Neural Simulator、Dynamic Model 和 Reward Model。图22展示了自动驾驶世界模型的三个代表性流程。

6.1.1 WMs 作为自动驾驶的神经模拟器

神经模拟器专注于生成逼真的驾驶场景,用于训练和测试自动驾驶系统。这些模型通常接收多模态输入(图像、文本、动作、轨迹),并生成高保真视频序列,模拟多样化的驾驶条件,用于数据增强和安全验证。

GAIA-1 [282] 首次将世界建模视为自动驾驶中的序列预测问题,通过自回归Transformer架构整合视频、文本和动作输入,生成逼真的驾驶场景。该模型采用90亿参数的Transformer,在4700小时专有驾驶数据上训练,展现出涌现行为,如从同一上下文预测多样化的未来场景,并对动态智能体间的交互进行推理。其关键创新在于仅凭学习到的理解生成长且多样的驾驶场景,并通过动作条件和文本提示实现可控生成,从而影响天气、时间等环境因素。

在此基础上,GAIA-2 [312] 通过从自回归方法转向扩散模型方法,并结合结构化条件控制,进一步提升了对自驾车动力学、多智能体交互及环境因素的可控生成能力。该模型整合了结构化条件输入和专有驾驶模型的外部潜在嵌入,在英国、美国、德国等多样地理环境中实现了对天气、光照及场景几何结构的细粒度控制。这种增强的可控性通过高分辨率、时空一致的多摄像头视频生成,使得常见与罕见的安全关键驾驶场景的可扩展模拟成为可能。

DriveDreamer [313] 也引入了基于扩散的生成方法,结合结构化交通约束,代表了驾驶场景生成的重大突破。该模型通过学习真实驾驶场景而非模拟环境,在真实数据上表现优异,采用两阶段训练流程:第一阶段学习结构化交通约束,第二阶段实现未来状态预测。该方法能够生成精确且可控的视频,准确捕捉真实交通的结构约束。

DriveDreamer-2 [314] 通过整合大型语言模型(LLMs)增强了DriveDreamer框架,以实现自然语言驱动的场景生成。系统通过LLM接口将文本用户查询转换为智能体轨迹,随后生成符合交通规则的HDMap,最后使用统一多视角模型(UniMVM)生成具有增强时空一致性的驾驶视频。这是首个能够根据用户描述生成定制化驾驶视频的世界模型,在提升质量的同时,还能生成多样且罕见的驾驶场景,这对鲁棒的自动驾驶训练至关重要。

DriveDreamer4D [315] 通过利用世界模型先验进一步提升4D驾驶场景表示,合成具有显式时空一致性控制的新颖轨迹视频。该框架将现有世界模型作为“数据机器”,在结构化条件下合成具有显式交通元素时空一致性控制的新颖轨迹视频。一项关键创新是“cousin data training strategy”,该策略有效整合真实与合成数据以优化4D高斯泼溅重建,显著提升新轨迹视角的生成质量及时空一致性。

图21:世界模型在自动驾驶中的三个角色:Neural Simulator、Dynamics Model和Reward Model

目标是解决3D几何控制的挑战,MagicDrive [316] 提出了一种新型街景生成框架,支持多种输入,包括相机位姿、道路地图、3D边界框和文本描述。该系统针对不同输入采用定制化编码策略,并引入跨视图注意力模块以确保多视角一致性,从而实现高保真街景合成,精准捕捉精细的3D几何结构及光照、天气等多样场景特性。

MagicDrive3D [317] 通过创新的“先生成后重建”两步流程,扩展了该能力以支持任意视角的可控3D生成。该框架首先训练条件多视图视频生成模型,然后利用Deformable Gaussian Splatting结合单目深度初始化和外观建模,从生成的视频数据中重建3D场景。这是首个有效整合几何无关的视图合成与几何导向的重建的框架,适用于使用常见驾驶数据集进行可控3D街景生成。MagicDrive-V2 [318] 采用集成3D VAE的Diffusion Transformer架构,将框架扩展至高分辨率、长时长视频。

系统集成了MVDiT模块用于多视图视频生成、新型时空条件编码以实现精确几何控制,以及三阶段渐进式引导训练策略,支持生成高达848×1600分辨率、241帧的视频,显著提升了自主驾驶应用中的输出分辨率、帧数和控制精度。Panacea [319] 专注于具有多视图一致性机制和超分辨率能力的全景视频生成,采用两阶段视频生成模型:先合成多视图图像,再基于这些图像构建多视图视频,整合多视图外观噪声先验机制和超分辨率模块,以生成高质量、高分辨率的360度视频。

专注于多摄像头一致性,WoVoGen [320] 引入了显式的4D世界体积作为基础元素,通过两阶段操作来构想未来的4D时序世界体积并生成具有传感器互连性的多摄像头视频。该模型通过整合4D世界体积,巧妙地将时间与空间数据结合,解决了维持世界内部一致性和传感器间一致性的挑战。生成的4D世界特征经过几何变换,为每个摄像头采样3D图像体积,从而实现高质量的街景视频生成,该视频能够响应车辆控制输入,并在各传感器间保持一致性。

图22:世界模型的代表性流水线示意图:GAIA-2 [312]、MagicDrive [316] 和 DriveDreamer [313]

近期研究也探索了占据表示,以实现更结构化的场景理解。Occ-Sora [321] 采用基于扩散的4D占据生成模型来模拟3D世界的发展,生成具有真实3D布局和时间一致性的16秒视频。该框架使用4D场景分词器从4D占据输入中获取紧凑、离散的时空表示,随后使用在这些表示上训练的扩散变换器进行轨迹条件下的4D占据生成。Drive-World [322] 采用基于占据的内存状态空间模型(MSSM),通过学习多摄像头驾驶视频来实现4D场景理解。该框架包含用于时序感知潜在动态的动态记忆库和用于空间感知潜在静态的静态场景传播模块。

该方法实现了全面的4D场景理解,助力多样化的视觉感知、预测和规划任务,并在多个自动驾驶基准测试中展现出显著改进。Drive-OccWorld [323] 通过语义和运动条件归一化技术将占据预测与端到端规划相结合。该框架包含一个记忆模块,从历史BEV嵌入中积累语义和动态信息,通过灵活的动作条件实现对未来状态的可控生成。这种将预测能力与端到端规划相结合的方式,为驾驶场景生成和集成规划系统开辟了新途径。

针对生成结果的时间范围挑战,InfinityDrive [324] 通过能够维持长期连贯性的生成模型,实现了无限长驾驶序列的生成。该框架解决了采样速度、长时间生成和时间一致性方面的挑战,旨在实现可控、高效且真实的基于视频的世界建模,用于自动驾驶应用。

ReconDreamer [325] 通过在线修复和渐进式数据更新策略,增强了闭环模拟中的驾驶场景重建能力。该框架引入了“DriveRestorer”,一个基于世界模型的组件,通过在线修复缓解鬼影伪影,并结合渐进式数据更新,以确保高质量渲染,特别是在大范围复杂机动中。这是首个能够有效渲染大范围复杂机动(如跨度达6米的多车道变道)的方法。

6.1.2 WMs作为自动驾驶的动态模型

动态模型专注于学习驾驶环境中的基础物理原理和运动模式,主要服务于感知、预测和规划任务,而非高保真生成。这些模型学习环境动力学,以实现更好的决策和长期规划。

MILE [350] 首创了用于城市驾驶的基于模型的模仿学习方法,通过从专家演示中联合学习预测性世界模型和驾驶策略。该框架通过将高分辨率视频输入和3D几何作为归纳偏置,显著提升了驾驶评分,展示了世界模型如何作为复杂城市环境中策略学习的有效基础。联合学习方法使模型能够同时捕捉环境动态和合适的驾驶行为。

1 几何表示包括:3D体素占用、3D边界框、3D深度、3D分割和3D点云。

2 代码可用性: “ ” 表示代码未在论文中宣布发布,或已宣布发布但完整代码(训练和推理)尚未可用; “✓” 表示代码已发布。

TrafficBots [352] 提出了一种基于条件变分自编码器的多智能体交通仿真方法,通过可配置的智能体个性实现可扩展的多样化驾驶行为模拟。该系统引入了基于目的地的导航和时不变个性潜在变量,以控制智能体从激进到谨慎的行为风格,提供了一个全面的框架用于模拟交通场景中的真实多智能体交互。

基于占据表示以提升3D理解,UniWorld [353] 将4D几何占据预测作为基础预训练任务,在运动预测、3D目标检测和语义场景补全方面取得了显著提升。该框架表明,4D占据预测可作为统一的预训练目标,通过全面的时空场景理解,有效提升多个下游自动驾驶任务的性能。OccWorld [283] 采用向量量化变分自编码器从3D占据数据中学习离散场景标记,实现了类GPT的时空生成建模。该方法将场景理解转化为序列建模问题,能够在长时序中保持空间和时间一致性的同时,高效地进行未来占据状态的自回归预测。GaussianWorld [368] 将3D占据预测重新定义为4D占据预测,利用高斯世界模型推断场景演化,综合考虑自车运动、动态物体及新观测区域。该框架通过高斯表示建模不确定性和时间动态,从而在多移动目标与动态环境条件的复杂驾驶场景中实现更稳健的预测。

DFIT-OccWorld [369] 提出了一种基于解耦动态流的高效占用世界模型,以图像辅助训练范式将占用预测重构为体素形变过程。该方法通过分离静态和动态场景元素,在保持预测精度的同时提升了计算效率,从而实现实时自动驾驶系统中更可扩展的部署。

MUVO [356] 针对传感器融合与几何理解问题,采用空间体素表示,从相机和LiDAR数据中学习传感器无关的几何理解。该框架通过将多模态传感器输入整合为统一的3D表示,弥补了现有世界模型中物理和几何属性被忽视的问题,从而实现更全面的场景理解,弥合不同传感器模态间的差距。ViDAR [357] 将视觉点云预测作为预训练任务,仅基于历史视觉输入预测未来的LiDAR点云,以促进语义、3D结构和时序动态的协同学习。这种跨模态方法展示了世界模型如何在保持时空一致性和语义理解的同时,学习不同传感器模态间的转换。

LAW[360] 提出了一种无需感知标注的自监督学习方法,通过基于当前观测和自车动作预测未来潜在特征。该方法大幅减少了对昂贵人工标注的依赖,同时通过潜在特征预测有效学习环境动态。该框架展示了如何高效训练世界模型,无需密集监督,使其更适用于大规模部署。Think2Drive [358] 通过在紧凑的潜在世界模型中训练神经规划器,实现了潜在空间中的高效强化学习,在复杂城市场景中达到专家级水平。该框架表明,潜在世界模型可通过将复杂的高维观测抽象为可管理的潜在表示,同时保留控制所需的关键信息,从而实现高效的规划与决策。HERMES [373] 在单一框架内统一了3D场景理解和生成,采用BEV表示和world queries,通过因果注意力机制融入世界知识。该框架展示了世界模型如何整合理解与生成能力,在统一架构中实现感知与模拟,并利用因果注意力机制改进时序建模。

Cosmos-Reason1 [351] 代表了在融合物理常识与具身推理方面的前沿探索,能够在推理可能的物理交互时生成更符合物理规律的场景。该研究通过将物理推理能力整合到世界模型中,推动了该领域的发展,使复杂驾驶场景中的物理交互模拟更加真实。Doe-1[367] 将自动驾驶问题形式化为基于多模态token(观测、描述和动作)的下一个token生成问题,通过自回归生成实现感知、预测和规划的统一。

该方法展示了如何通过将所有模态视为统一序列中的token来调整语言模型架构以适用于自动驾驶,从而实现感知与控制任务的端到端学习。DrivingGPT [370] 采用多模态自回归Transformer将驾驶世界建模与轨迹规划相结合,将交错的离散视觉与动作token视为统一的“驾驶语言”。该框架展示了如何将驾驶问题形式化为语言建模问题,使大规模语言模型技术能够应用于自动驾驶,同时保持对视觉输入和控制输出的推理能力。

6.1.3 WMs 作为自动驾驶的奖励模型

奖励模型评估驾驶行为的质量与安全性,通常与强化学习结合用于策略优化。这些模型利用世界模型预测来评估轨迹安全性并指导决策,无需人工设计奖励函数。

Vista[376] 利用模型自身的模拟能力展示了可泛化的奖励函数,建立了一种新方法:世界模型自身通过模拟结果评估潜在驾驶机动的质量或安全性。该系统支持从高层意图到底层机动的多样化动作控制能力。这种自我评估能力使模型能够为安全驾驶行为提供内在动机,无需人工设计奖励函数。

WoTE [379] 专注于使用BEV世界模型进行轨迹评估,以实现在端到端自动驾驶系统中的实时安全评估。该框架利用BEV世界模型预测未来状态,并比图像级方法更高效地评估轨迹安全性,在NAVISIM和Bench2Drive基准测试中展现了最先进的性能。该方法支持实时自动驾驶应用中的持续安全监控和轨迹评估。

Drive-WM [378] 通过联合时空建模与视图分解,实现了基于图像奖励评估的多轨迹未来探索。该系统能够根据不同的驾驶操作模拟多种可能的未来情景,并通过图像奖励评估想象中的未来来确定最优轨迹。此功能支持基于世界模型的"what-if"推理进行安全驾驶规划,使系统能够在执行前探索和评估多种潜在动作。

Iso-Dream[375] 解决了驾驶环境中可控动力学与不可控动力学分离的挑战。该方法通过分离可控动力学(自车动作)与不可控动力学(其他车辆、环境变化),提升了基于模型的强化学习,使复杂交通场景中的长时域规划和决策更加有效。这种分离使模型能够更专注于可控部分的学习,同时准确建模环境不确定性。

6.1.4 技术趋势与影响

自动驾驶世界模型的演进揭示了四大技术趋势,正在重塑车辆仿真与测试的方式:

生成式架构从自回归到扩散模型的演进:早期的自动驾驶世界模型如GAIA-1采用自回归Transformer架构,通过顺序标记生成预测未来驾驶场景。尽管这些方法在学习高层场景结构方面表现优异,但受制于标记预测的顺序性,在生成长时间、高保真驾驶视频时面临显著计算挑战。此后,该领域已转向基于扩散模型的范式转变,以DriveDreamer系列、GAIA-2和WoVoGen为代表,这些模型在生成质量控制上更具优势。现代混合架构开始涌现,将自回归与基于扩散的场景生成相结合。MagicDrive-V2等模型中集成扩散Transformer(DiT)代表了最新进展,融合了Transformer注意力机制与扩散生成的优势。

多模态集成与可控场景生成:近年来,自动驾驶世界模型已从简单的图像到图像生成,发展为能够整合多种输入类型的先进多模态系统,包括摄像头图像、LiDAR点云、文本描述、车辆轨迹和高清地图。这一演变解决了自动驾驶测试中的根本挑战:需要生成特定且可控的驾驶场景,以在精确设定的条件下对驾驶系统的不同方面进行压力测试。GAIA-2和DriveDreamer-2等模型通过接受结构化输入(如自车动力学、多智能体配置、环境因素(天气、时段)和道路语义)来实现对生成场景的精细控制,体现了这一趋势。这种多模态方法还支持生成同步的多摄像头视图,实现360度覆盖。这些进展已将世界模型转变为能够主动探索各种可能驾驶场景的仿真工具,从而更高效地验证自动驾驶系统。

3D时空理解与占用表示:在自动驾驶世界模型领域,一个基础性的发展方向是构建全面的3D时空建模,从而更精准地反映驾驶环境的真实特性。早期模型主要聚焦于生成逼真的摄像头图像,但这种方法无法提供训练鲁棒感知系统所需的几何一致性与3D理解能力,而这些能力对于在真实驾驶场景中推理物体深度、遮挡及空间关系至关重要。3D感知建模的转型体现在OccSora、Drive-OccWorld和OccWorld等框架中,它们通过4D占用网格来表征驾驶场景,将空间结构与时间动态统一编码。这种3D感知建模能力使世界模型不仅能作为数据生成器,还能作为全面的模拟器,预测自车动作如何影响驾驶场景的演变。在GaussianWorld和MagicDrive3D等模型中集成Gaussian Splatting等技术,进一步提升了生成场景的几何保真度,支持新型视图合成,并推动更鲁棒的感知算法的发展。

自动驾驶的端到端集成流水线:现代自动驾驶世界模型不再作为独立的仿真工具,而是被设计为模块化端到端自动驾驶系统的预测组件。MILE、LAW、Think2Drive和WoTE等模型通过联合学习世界动态和驾驶策略,展示了这种集成方法,实现了端到端优化,从而最小化不同系统组件间的误差累积。这种集成还延伸至奖励建模能力,例如Vista和Drive-WM等框架利用自身仿真能力评估轨迹安全性并指导策略学习,无需手动设计奖励函数。Doe-1和DrivingGPT等高级集成系统展示了世界模型如何在单一神经架构中统一感知(场景理解)、预测(未来状态预测)和规划(动作生成),将所有模态视为统一序列建模问题中的标记。这种集成趋势的最终目标是构建能够在统一学习表征中对环境进行推理、预测未来状态并规划安全动作的自动驾驶系统。

6.2 关节型机器人的世界模型

关节型机器人(包括机械臂、四足机器人和人形机器人)作为具身智能的核心载体,对世界建模提出了独特而严格的要求。本节系统探讨了世界模型在关节型机器人控制领域的应用与挑战,重点关注基于机器人仿真和多模态学习的方法如何推动机器人技术的范式转变。

6.2.1 WMs作为关节式机器人的神经模拟器

世界模型作为神经模拟器,通过学习多模态输入(如文本、图像、轨迹)生成时间连贯且语义丰富的物理环境表征。这些生成式模型为传统物理模拟器提供了可扩展、数据驱动的替代方案,能够高效训练和评估自主智能体。

一个典型案例是NVIDIA的Cosmos世界基础模型平台[294],它建立了一个统一的框架,用于构建能够通过扩散和自回归架构生成物理准确的3D视频预测的基础世界模型。Cosmos通过从结构化输入(如分割图、深度图)合成逼真且可控的环境,促进仿真到现实迁移、数据增强和机器人感知训练。图23展示了Cosmos-Predict世界基础模型。该平台的模块化设计支持通过专用数据集的后训练实现任务特定微调,显著降低数据需求,这得益于大规模预训练的迁移学习。这种方法弥合了仿真与现实之间的差距,提升了机器人在自动驾驶和机器人操作等动态环境中的学习能力。未来神经仿真保真度和控制技术的进步将进一步扩大其在具身AI系统中的应用。

WHALE [381] 提出了一种具有 behavior-conditioning 和 retracing-rollout 的可泛化世界模型框架,用于 OOD 泛化和不确定性估计。Whale-ST(时空Transformer)和 Whale-X [428](414M参数模型)在仿真和真实世界操作任务中展现出增强的可扩展性和性能。

RoboDreamer [382] 提出了一种用于机器人决策的组合式世界模型,通过将视频生成分解为基本原语。该模型利用语言组合性,能够泛化到未见过的对象-动作组合和多模态目标,在RT-X中为新任务生成计划,并在仿真中优于单体基线模型。

DreMa [383] 提出了一种组合式世界模型,该模型结合Gaussian Splatting和物理模拟以显式复现真实世界动态,通过等变变换实现逼真的未来预测和数据高效的模仿学习,并在Franka机器人上实现了一次性策略学习,精度和泛化能力得到提升。

DreamGen [384] 提出了一种四阶段流水线,通过神经轨迹训练可泛化机器人策略,利用视频世界模型跨行为与环境合成逼真数据。该方法从生成视频中提取伪动作,仅需少量真实数据即可实现零样本泛化,经DreamGen Bench基准验证。

图23:Cosmos-Predict World Foundation Model通过Cosmos-Tokenize1-CV8×8×8-720p处理输入视频,将其编码为受高斯噪声扰动的潜在表示。3D分块步骤对这些潜在表示进行结构化,随后是迭代的自注意力、文本条件交叉注意力和MLP块,由自适应层归一化调节。最后,解码器从精炼后的潜在空间重建高保真视频输出。该架构支持多样化的物理AI应用中的鲁棒时空建模 [294]。

EnerVerse [385] 提出了一种用于机器人操作的生成式基础模型,采用自回归视频扩散和自由锚点视图(FAVs)进行3D世界建模。该框架在EnerVerse-D中整合4D高斯泼溅以减少仿真到现实的差距,而EnerVerse-A将4D表示转换为动作,在仿真和现实世界的ta中实现最先进的性能。

WorldEval [386] 提出了一种基于世界模型的在线机器人策略评估流程,使用Policy2Vec通过潜在动作条件化生成动作跟随视频。该方法实现了可扩展、可复现的策略排名与安全检测,展示了与现实世界的强相关性,并超越real-to-sim方法。

1 几何指3D几何表示,包括:3D体素占用、3D边界框、3D深度、3D分割和3D点云。

2 DiT = 扩散Transformer;RSSM = 循环状态空间模型;TSSM = Transformer状态空间模型;SSM = 状态空间模型;TD-MPC = 时序差分模型预测控制;OSRP = 在线安全奖励规划;GRU = 门控循环单元;MLP = 多层感知机;LSTM = 长短期记忆;GS = 高斯泼溅;MVM = 掩码视频建模;FM = 流匹配;JEPA = 联合嵌入预测架构。

3 DMC = DeepMind控制套件(模拟)。

4 代码可用性:”✗”表示论文中未宣布发布代码,”✓”表示代码已发布,”◦”表示论文中宣布将发布代码,但完整代码(训练和推理)尚未可用。

1 几何指3D几何表示,包括:3D体素占用、3D边界框、3D深度、3D分割和3D点云。

2 DiT = Diffusion Transformers; RSSM = Recurrent State-Space Model; TSSM = Transformer State-Space Model; SSM = State-Space Model; TD-MPC = Temporal Difference learning for Model Predictive Control; OSRP = online safety-reward planning; GRU = Gated Recurrent Unit; MLP = Multilayer Percentron; LSTM = Long Short-Term Memory; GS = Gaussian Splatting; MVM = Masked Video Modelling; FM = Flow Matching; JEPA = Joint Embedding-Predictive Architecture.

3 DMC = DeepMind Control suite (Simulation).

4 代码可用性:“✗”表示论文中未宣布发布代码,“✓”表示代码已发布,“◦”表示论文中宣布将发布代码,但完整代码(训练和推理)尚未可用。

华为云盘古世界模型[387]是一种神经模拟器,可生成高保真数字环境(例如相机视频、激光雷达点云),用于训练智能驾驶和具身AI系统。通过建模物理动力学和多模态传感器数据,无需进行昂贵的现实世界数据采集。与广汽集团合作,可快速生成corner-case和2D-to-3D像素映射。CloudRobo平台进一步扩展了具身AI模型(生成、规划、执行)和R2C协议标准化,旨在通过云端仿真和部署统一机器人开发。

RoboTransfer [388] 提出了一种融合多视角几何与显式场景控制的几何一致性视频扩散框架,用于机器人视觉策略迁移。通过约束跨视角特征交互与深度/法线条件,该方法生成几何一致的多视角视频,提升sim-to-real策略性能。该方法支持细粒度场景编辑,同时保持视觉保真度。

6.2.2 WMs 作为关节机器人的动态模型

世界模型通过从观测数据中学习环境动态的预测表示,在基于模型的强化学习(MBRL)中充当动态模型。无需依赖手工设计的物理引擎或稀疏奖励信号,这些模型使智能体能够通过想象的 rollout 来模拟未来状态并规划动作。PlaNet 是最早采用 RSSM 架构的模型之一,如图 24 所示。Dreamer 系列通过使用变分自编码器和 RSSM 从高维观测中学习潜在状态动力学,很好地诠释了这一方法。扩展模型如 TransDreamer 用 Transformer 替代 RNN 以更好地捕捉长程依赖关系,而 ContextWM 和 iVideoGPT 则分别探索在真实视频上的预训练和离散标记建模。这些改进提升了模型的泛化能力、长时程预测能力以及跨任务迁移性。通过解耦感知与规划,世界模型降低了样本复杂度,并提升了复杂高维环境中的决策能力。近期研究进一步证明了其在现实世界中的适用性,验证了其在机器人学和自主系统中的潜力。

PlaNet [429] 提出了一种像素级规划的潜变量动态模型,结合确定性与随机性转移及潜变量超调进行多步预测,在未知环境中以比无模型方法更少的episode解决复杂连续控制任务,展现出高样本效率。

Plan2Explore [262] 介绍了一种自监督强化学习智能体,该智能体利用基于模型的规划在探索过程中主动寻求未来的新颖性,从而实现对未见任务的零样本或少样本适应;在无需任务特定监督的情况下,其在高维图像控制任务上优于先前方法,接近 oracle 级性能。

Dreamer系列在世界模型方面做了大量工作,并在第5.2.2节中进行了详细讨论。例如,DreamerV3 [300]提出了一种通用强化学习算法,通过学习世界模型来模拟未来场景,在单一配置下于150多种不同任务上实现了最先进的性能。其鲁棒性技术实现了稳定的跨领域学习,具体体现在无需人类数据或课程学习即可在Minecraft中首次完成钻石收集。

Dreaming [395] 移除Dreamer的解码器以缓解物体消失问题,采用无似然性InfoMax对比目标,结合线性动力学和数据增强,在5项机器人任务中取得顶尖性能。

DreamingV2 [396] 在此基础上融合DreamerV2的离散潜状态与Dreaming的无重建学习,构建混合世界模型,该模型利用分类状态表示处理复杂环境,并结合对比视觉建模,在3D机械臂任务中无需重建即可表现出色。

DreamerPro [397] 通过将原型表征整合到Dreamer的世界模型中并从循环状态中提炼时间结构,提升了MBRL对视觉干扰的鲁棒性。该方法在复杂背景的DeepMind Control任务上表现更优,在标准训练设置下优于对比方法。

图24:潜在动态模型采用不同的过渡机制进行时间预测。(a) RNN模型使用确定性过渡,限制多模态未来预测,同时便于规划器利用。(b) 状态空间模型(SSM)仅依赖随机过渡,阻碍长期记忆保持。(c) RSSM结合随机和确定性状态分量,平衡多路径预测与时间连贯性。这种混合方法在学习多样化未来的同时保持序列一致性,从而提升鲁棒性,如[429]所示。

LEXA [398] 提出了一种统一的无监督目标达成框架,结合基于世界模型的想象rollouts与前瞻性驱动的探索,以发现新状态并完成多样化任务。该方法在40项具有挑战性的机器人任务上优于先前方法,展示了零样本泛化和多环境下的可扩展性。

FOWM [399] 提出了一种结合离线世界模型预训练与在线微调的框架,通过认知不确定性正则化来缓解外推误差。该框架能够在有限的离线数据下,对已见和未见的视觉-运动任务实现少样本适应,并在仿真和真实世界机器人控制基准上得到验证。

SWIM [400] 提出了一种适用于机器人操作的可供性空间世界模型,该模型基于人类视频训练并通过少量机器人数据微调,能从人与物体交互中学习结构化动作表示,无需特定任务监督即可在多样任务和机器人上快速掌握技能(<30分钟)。

DWL [401] 是一个端到端RL框架,用于人形机器人运动。世界模型实现了零样本Sim-to-Real迁移,仅需单一策略即可掌握雪地、楼梯、不平地面等多种复杂地形。该方法无需环境特定调优即可展现出鲁棒性和泛化能力。

Surfer[402] 提出了一种基于世界模型的机器人操作框架,通过解耦动作与场景预测来提升多模态任务的泛化能力。该框架显式建模世界知识,并在SeaWave基准测试中达到54.74%的成功率,通过建模基于物理的状态转移超越了基线方法。

GAS [403]提出了一种面向手术机器人操作的基于世界模型的深度强化学习框架,采用像素级视觉运动策略,结合不确定性感知深度估计与紧凑的3通道图像编码。该框架在真实手术环境中处理未见物体和干扰的成功率达69%,在临床环境中展现出比先前方法更优越的鲁棒性与泛化能力。

Puppeteer [404] 提出了一种用于视觉全身人形控制的层次化世界模型,其中高层视觉策略生成命令供底层执行策略使用,两者均通过强化学习训练。该方法在无需简化假设或奖励工程的情况下,实现了56-DoF人形机器人在8项任务上的高性能运动合成。

TWIST [405] 提出了一种师生世界模型蒸馏框架,用于基于视觉的模型强化学习中的高效的 sim-to-real 迁移。该框架利用状态特权教师模型来监督基于图像的学生模型,通过域随机化蒸馏加速适应并弥合 sim-to-real 差距,在样本效率和任务性能上优于朴素方法。

PIVOT-R [406] 提出了一种原语驱动的航点感知世界模型(WAWM),用于语言引导的机器人操作,通过异步分层执行器(AHE)将航点预测与动作执行解耦。该模型在Sea-Wave基准测试中实现19.45%的相对提升,效率提升28倍,且性能损失极小。

HarmonyDream [407] 提出了一种针对世界模型的任务协调框架,通过动态平衡观测损失与奖励建模损失,提升MBRL的样本效率。该方法在视觉机器人任务上实现了10%-69%的性能提升,并通过解决世界模型学习中的任务主导问题,刷新了Atari 100K基准记录。

SafeDreamer [408] 将基于拉格朗日的方法与世界模型规划融入Dreamer框架,以增强安全强化学习。该方法在Safety-Gymnasium任务中实现了接近零成本的性能,通过提升模型精度和样本效率,在低维和纯视觉输入下有效平衡了性能与安全。

WMP [409] 提出了一种基于世界模型的足式运动感知框架,通过从模拟世界模型预测中学习策略,消除了对特权信息的依赖。该框架通过跨域泛化,在仿真和物理环境中验证,实现了最先进的实际环境通行能力与鲁棒性。

RWM [410] 提出了一种基于神经网络的机器人世界模型,采用双自回归机制进行长时序动力学预测。该框架通过想象环境实现自监督训练和鲁棒策略优化,解决了部分可观测性和sim-to-real迁移的挑战,且无领域特定偏差。

RWM-O [411] 提出一种离线机器人世界模型,具备显式的认知不确定性估计,通过惩罚不可靠的状态转移来增强策略的稳定性和泛化能力。该模型在真实数据环境中验证,无需物理仿真器即可缩小仿真到现实的差距并提升安全性,优于传统MBRL方法。

SSWM [430](状态空间世界模型)用于加速基于模型的强化学习(MBRL)。该方法通过并行化动态模型训练并利用特权信息,使世界模型训练提速最高达10倍、整体MBRL加速4倍,同时在部分可观测的复杂四旋翼飞行任务中保持性能。

WMR [413] 提出了一种端到端的世界模型重建框架,用于无视觉辅助的人形运动,通过显式重建世界状态提升策略鲁棒性。梯度截断确保状态重建的独立性,使机器人能够在复杂地形上自适应运动,并通过冰面、雪地及可变形表面3.2公里徒步测试验证。

PIN-WM [414] 提出了一种面向非抓取操作的物理信息世界模型,通过可微分仿真实现基于少样本视觉轨迹的端到端3D刚体动力学学习,利用基于高斯泼溅的观测损失消除状态估计,并通过物理感知的数字孪生体弥合Sim2Real差距,实现鲁棒的策略迁移。

LUMOS [415] 提出了一种语言条件模仿学习框架,利用世界模型进行潜在空间技能训练。该方法将潜在规划、事后目标重标记与内在奖励相结合,从而实现零样本迁移至真实机器人。它在长时序任务中表现出优异性能,同时缓解了离线设置中的策略导致的分布偏移。

OSVI-WM [432] 提出了一种基于世界模型引导轨迹生成的单次视觉模仿学习框架。学习到的世界模型从演示中预测潜在状态和动作,并解码为物理路点用于执行。在模拟和真实机器人平台上评估,该方法相比先前方法性能提升超过30%。

FOCUS [417] 提出了一种用于机器人操作的对象中心世界模型,通过结构化对象交互表征场景。该框架支持对象中心的探索,并通过更准确的场景预测提升操作技能。在使用Franka Emika机械臂进行的机器人任务评估中,该模型展示了高效学习和适应稀疏奖励场景的能力。

FLIP [418] 提出了一种以流为中心的基于模型的规划框架,用于语言-视觉操作,整合多模态流生成、流条件视频动力学和视觉-语言表征模块。该框架通过图像流生成长期规划,利用交互式世界模型特性指导底层策略训练,并在多种基准测试中验证。

EnerVerse-AC [419] 提出了一种面向机器人评估的动作条件世界模型,采用多级动作条件与射线图编码技术生成动态多视角观测。该模型兼具数据引擎与评估器的功能,能够基于人类轨迹合成逼真的动作条件视频,从而实现无需物理机器人或复杂模拟的低成本策略测试。

FlowDreamer [420] 提出一种基于显式3D场景流表示的RGB-D世界模型,用于视觉预测与规划,该模型将运动估计(U-Net)和帧合成(扩散模型)解耦,同时保持端到端训练,在操作基准测试中语义质量和成功率均超过基线7-11%。

HWM [421] 提出轻量级基于视频的世界模型,用于人形机器人,采用Masked Transformers和FlowMatching来预测动作条件下的自我中心观测。该框架展示了高效的参数共享策略,将模型规模缩减33%-53%的同时保持性能,实现在资源受限的学术环境中的实际部署。

MoDem-V2 [422] 通过集成演示引导与安全感知探索策略(探索中心化、控制权移交、演员-评论家集成)的基于模型的强化学习框架,实现了真实世界接触丰富的操作学习,并首次在无需仪器的情况下成功实现了基于视觉的MBRL系统在真实世界中的直接训练。

V-JEPA 2 [275] 是一个拥有12亿参数的世界模型,采用联合嵌入预测架构,用于视频理解、预测及零样本规划。该模型采用两阶段训练:在超过100万小时视频数据上进行无动作数据的预训练以建立物理直觉,随后进行动作条件微调,仅需62小时的机器人数据。V-JEPA 2在动作识别与预测任务中表现优异,并通过视觉子目标规划实现机器人任务的模型预测控制,新环境中成功率65%-80%。该框架还包含三个新基准测试,用于评估物理推理能力。

6.2.3 WMs 作为关节型机器人的奖励模型

世界模型作为奖励模型,利用其学习到的动力学特性,通过衡量智能体行为与模型预测的匹配度来隐式推断奖励。例如,当轨迹高度可预测(即符合世界模型的预期)时,给予更高奖励,从而无需手动设计奖励。

与Dreamer不同,PlaNet使用显式学习的奖励预测器,而Dreamer通过价值函数隐式替换奖励信号。其奖励预测器作为动力学模型的一部分,负责从压缩的潜在状态中预测环境奖励,通过最小化预测奖励与真实奖励之间的误差进行训练,并在在线规划阶段为潜在空间中的多步轨迹展开提供即时奖励信号,从而替代手工设计的奖励函数。

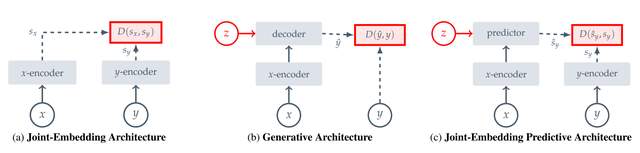

图25:自监督学习架构采用不同方法建模输入兼容性:(a) 联合嵌入对齐兼容输入的嵌入;(b) 生成式方法通过潜变量条件解码器重构信号;(c) 联合嵌入预测使用潜变量条件预测器预测嵌入。各框架优化能量分配——兼容输入能量低,不兼容输入能量高 [431]。

此类方法统一环境模拟与奖励生成,实现基于原始观测的可扩展RL。该范式在迁移学习中尤其强大,如VIPER的跨具身泛化所示。

VIPER [427] 提出使用预训练视频预测模型作为强化学习的奖励信号。该方法在专家视频上训练自回归Transformer,并利用预测似然作为奖励,能够在DMC、Atari和RLBench任务中实现无需任务特定奖励的专家级控制,同时支持桌面操作场景中的跨实体泛化。

6.2.4 技术趋势

世界模型未来具有广阔的发展前景,但在机器人领域,它可能具有以下发展潜力:

触觉增强型世界模型用于灵巧操作。触觉整合型世界模型的演进正在推动机器人灵巧性的突破性进展,尤其在多指手领域。前沿方法将高分辨率接触建模与视觉触觉融合技术相结合,通过神经网络实时预测打滑、形变及最优抓取力。自监督触觉编码器通过自主学习材料与形状表征,无需人工标注;图网络/变换器架构处理动态时空触觉信号。这些创新使机器人能够以类人适应性处理新型物体,克服了精细操作任务中的传统sim-to-real挑战。

统一世界模型,跨硬件与跨任务泛化。未来机器人世界模型将聚焦于硬件无关的动力学编码和任务自适应的潜在空间,以实现对多样化的实体(如单臂/双臂、腿式/轮式机器人)和任务(如夹持器与灵巧手操作)的泛化。关键方向包括:具有共享物理先验的模块化架构以实现可迁移的动力学学习;元强化学习以快速适应新的硬件/任务组合;以物体为中心的表征实现跨场景的技能复用;以及通过残差物理建模构建仿真到现实的桥梁。这些进展旨在为可扩展的机器人智能创建“one model fits all”解决方案。

面向长时程任务的层次化世界模型。未来机器人世界模型将聚焦于层次化规划与时序抽象,以处理复杂多阶段任务。关键进展包括:用于动态子任务链的目标条件化潜在空间、用于捕捉长期依赖关系的记忆增强Transformer、用于可复用基元的自监督技能发现,以及用于实时计划调整的交互式人类反馈。这些创新旨在弥合高层推理与底层控制之间的差距,从而在开放环境中实现稳健自主性。

6.3 挑战与未来展望

高维与部分可观测性。自主系统处理高维感知输入,例如相机图像、LiDAR点云和雷达信号。基于这些数据建模世界需要大量计算资源。此外,这些观测本质上是部分的;智能体无法感知环境的完整状态。这种部分可观测性引入了不确定性,需要鲁棒的状态估计技术或维护信念状态以指导决策。

因果推理与相关性学习。当前许多世界模型的根本性局限在于其擅长学习相关性而非因果关系。例如,模型可以学习到刹车灯与减速之间的相关性,但可能缺乏对底层物理原理和驾驶员意图的深入理解。这一缺陷阻碍了真正的泛化能力,因为它使模型无法进行反事实推理——评估偏离训练分布的“what if”场景。在新情境中实现稳健表现需要从相关性模式匹配转向对环境的真正因果理解。

抽象与语义理解。有效的世界模型必须超越低层次的信号预测,实现更高层次的语义和抽象理解。一个稳健的模型不仅应预测未来的像素或LiDAR点,还应能够对抽象概念进行推理。一个主要的开放性问题在于将细粒度的物理预测与对交通法规、行人意图和物体可供性(例如,椅子是用来坐的)等概念的抽象推理进行融合。整合这些不同层次的抽象对于智能和上下文感知行为至关重要。

系统评估与基准测试。世界模型的客观评估与比较是一项重大研究挑战。传统指标如未来预测的MSE往往不够充分,因为它们可能与下游任务的性能无关。生成视觉上更清晰预测的模型未必能带来更安全或更高效的控制策略。需要开发新的评估框架,其指标应评估模型在规划中的实用性、安全关键场景中的鲁棒性,以及捕捉环境因果相关方面的能力。

记忆架构与长期依赖关系。准确的长期预测极具挑战性,因为预测误差的累积和现实世界的随机性。关键挑战在于设计能够长时间保留和检索相关信息的记忆架构,例如记住几分钟前看到的“Road Work Ahead”标志。开发高效且有效的记忆系统,利用Transformer或状态空间模型(SSMs)等架构来管理这些长期依赖关系,仍然是一个活跃且存在争议的研究领域。

人机交互与可预测性。在以人为中心的环境中运行的智能体,其世界模型的作用不仅限于环境预测,还需使智能体的行为具有可理解性、可预测性并符合社会规范。技术上最优但表现不稳定或反直觉的行为可能让其他司机或行人感到困惑,进而导致不安全的互动。这一社交智能层是功能性世界模型中微妙但关键的组成部分。

可解释性与可验证性。基于深度学习的世界模型常被视为“黑箱”,难以厘清其预测背后的逻辑。在自动驾驶等安全关键型应用中,审计和理解模型内部决策过程的能力不可或缺,尤其是在事后分析阶段。此外,这些模型的形式化验证是一项艰巨的理论和工程挑战——即通过数学方法证明其在庞大的输入空间中满足关键安全属性(例如,不会产生危险障碍物的幻觉)。

组合泛化与抽象。尽管 sim-to-real gap 是一个广为人知的泛化问题,但更深层次的挑战是组合泛化。人类能够学习“杯子”和“桌子”等离散概念,并立即对新组合(如“杯子放在桌子上”)进行泛化。相比之下,当前模型通常需要大量特定组合示例的接触。理想的世界模型应学习实体、其关系和物理属性的解耦抽象表示,从而能够通过组合已知概念来理解和预测新场景,而非依赖整个场景的端到端模式匹配。

数据整理与偏差。世界模型的性能从根本上取决于其训练数据的质量和组成。模型不可避免地继承数据集中存在的偏差,甚至可能放大这些偏差。例如,主要基于某一地理区域数据训练的模型在具有不同道路规则或环境条件的地区可能表现不佳。数据整理的关键方面之一是处理“长尾”中的罕见但安全关键的事件。系统性地识别、收集这些罕见场景并确保模型有效学习,对于构建稳健可靠的系统至关重要。

7 结论

本综述全面探讨了物理模拟器和世界模型在推进具身人工智能中的关键作用,揭示了向真正智能机器人系统转变的范式变革。通过分析,我们提出了五级分类框架(IR-L0至IR-L4)以评估机器人自主性,对主流模拟平台进行了广泛比较研究,并探讨了世界模型从简单循环架构到复杂的大规模基础模型系统的演变过程。本研究展示了现代模拟器如Isaac Gym、Genesis和新兴的Newton平台如何通过GPU加速的物理模拟和照片级真实感渲染革新机器人学习,而先进的世界模型则为自动驾驶和关节式机器人带来了前所未有的能力。

这些技术不仅缓解了Sim2Real差距,还在多样化环境中解锁了样本高效学习、长时程规划和鲁棒泛化的新可能性。随着我们向IR-L4级全自主系统的实现迈进,物理模拟器与世界模型的融合构成了下一代具身智能的基础,有望将机器人技术从任务特定自动化转变为可无缝融入人类社会的通用智能。