OpenAI 发布 Sora,AI 文生视频大模型跨越性突破

OpenAI 首个文生视频大模型 SORA 重磅推出

文生视频大模型Sora重磅发布,可生成长达1分钟的视频。2月16日,OpenAI推出其首 个文生视频大模型Sora。根据官网介绍,Sora可以生成长达1分钟时长的视频,同时 还能保证视频质量,并遵循用户的提示(prompt)。

将视觉数据转换为patches,有效用于Sora大模型训练。LLM范式的成功部分受益于使 用tokens,tokens能够将文本的多种模态(代码、数学、各种自然语言)统一起来。 OpenAI基于LLMs使用文本tokens的灵感,将所有视觉数据转化为patches,在Sora中 实现类似的效果。根据OpenAI的介绍,patches此前就已经被证明是视觉数据模型的 有效表示,同时OpenAI还发现,patches在训练生成不同类型视频和图像模型中是一 种高度可扩展且有效的表示。

Sora是一个扩散transformer(diffusion transformer),通过在潜在空间训练 patches生成视频。具体来看视频生成的过程,

1)首先将视频压缩到低维的潜在空间: OpenAI训练了一个降低视觉数据维度的网络,通过这个网络原始视频会在时间和空间 上都被压缩,并输出为潜在表示;

2)用时空潜在patches训练Sora:Sora在这个压缩 后的潜在空间中接受训练,基于从原始视频中提取的时空潜在patches,OpenAI能够 使得Sora对不同分辨率、持续时间和长宽比的视频和图像进行训练(图像相当于单帧 视频);

3)解码生成新视频:OpenAI训练了对应的解码器模型,将Sora在潜在空间训 练生成的视频(潜在表示)映射回像素空间;在推理时,OpenAI还可以通过在适当大 小的网格中排列随机初始化的patches来控制生成视频的大小。

Sora是一种扩散模型, 通过给出输入的静态噪声以及相关的文本提示(prompt)等调节信息,训练生成原始 的“干净”patches。与GPT模型类似,Sora使用transformer架构,释放出卓越的扩 展性能。

训练计算的增加可以显著提升视频质量。在固定种子和输入的情况下,可以看到训练 计算的增加能显著提升样本视频的质量。

立足DALL·E 3和GPT模型,Sora具有强大的语言理解能力,能够生成更准确、更高质 量的视频。OpenAI将DALL·E 3的re-captioning技术应用在Sora中,先训练一个高度 描述性的字幕生成器模型,然后使用它为训练集中所有视频生成文本字幕,通过对高 度描述性视频字幕进行训练,能够提供文本的保真度以及视频的整体质量。此外, OpenAI还利用GPT将简短的用户prompt转化为较长的详细字幕,然后发送到视频模型 中,使得Sora能够生成更加准确遵循用户提示的高质量视频。

多维度跨越式突破,视频质量飞跃性提升

Sora的采样更具有灵活性,同时改进了框架和构图。过去的图像和视频生成方法通常 需要调整大小、进行裁剪或者是将视频剪切到标准尺寸,例如4秒的视频分辨率为 256x256。而OpenAI的研究发现在原始大小的数据上进行训练,采样更具灵活性、同 时可以提高视频质量。Sora可以采样宽屏1920x1080p的视频、垂直1080x1920的视频 以及介于两者之间的所有视频。这让Sora可直接以不同的原始长宽比创建内容。Sora 还支持在生成全分辨率的内容之前,以较小的尺寸快速创建内容原型——所有内容 都使用相同的模型。

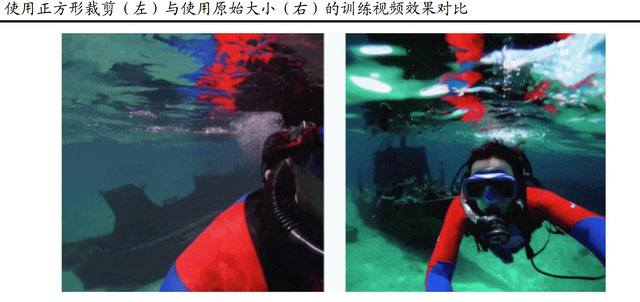

OpenAI还通过经验发现,在视频的原始长宽比上进行训练可以改 善构图和框架。研究团队将Sora与其他模型的一个版本进行比较,该版本将所有训练 视频裁剪为方形。在正方形裁剪上训练的模型有时会生成仅部分显示主题的视频(左 图),相比之下,来自Sora的视频有改进的帧内容(右图)。

Sora还支持图生视频、视频生视频,能够向前/向后扩展视频。Sora能基于DALL·E 3 的图像生成视频,还能执行广泛的图像和视频编辑任务,创建完美的循环视频、动画 静态图像、向前或向后扩展视频等。以下是Sora从一段生成的视频向后拓展出的三个 新视频,可以看到新视频的开头各不相同,但拥有相同的结尾。

在连接视频上,Sora能将两个输入视频无缝衔接在一起。如下图所示,左上图是村庄, 右下图是海洋,看似毫不相关的场景,Sora通过逐渐放大河流,合理、无缝地从左上 →左下→右上→右下实现两个视频的转化连接。

虽然目前Sora仍然有一些缺陷和局限性,但已经开始理解物理世界,并出现许多有趣 的涌现能力。

Sora目前还存在许多局限性,例如不能准确模拟许多基本交互的物理现 象,如玻璃碎裂;如吃食物,并不总能产生正确的物体状态变化。但我们认为Sora已 经接触到了世界模型的范畴。Sora能够生成具有多个角色、特定类型的运动以及主题 和背景的准确细节的复杂场景。该模型不仅了解用户在提示中要求的内容,还了解这 些东西在物理世界中的存在方式。OpenAI发现,视频模型在经过大规模训练后,会表 现出许多有趣的新能力。这些能力使Sora能够模拟物理世界中的人、动物和环境的某 些方面。这些特性的出现没有任何明确的三维、物体等归纳偏差,它们纯粹是规模现 象。例如三维一致性:Sora可以生成动态摄像机运动的视频,随着摄像机的移动和旋 转,人物和场景元素在三维空间中的移动是一致的。

重塑 AI 文生视频行业格局,或冲击 AI 文生图赛道

Sora在生成视频长度上大幅领先,多角度镜头能力也显著领先行业竞品。与此前的文 生视频产品相比,Sora在视频长度上实现了质的飞跃,此前的产品还停留在4s左右拓 展的阶段,拓展的连贯性一直是众多产品的研发重点。而此次Sora则是直接能够生成 最长60s的视频,这对AI文生视频行业来说是质的突破。同时,此前的文生视频产品 只能通过单角度镜头生成视频,而Sora可以在单个生成的视频中创建多个角度的镜 头,以准确保留角色和视觉风格,更准确地解释提示并生成表达生动情感的引人注目 的角色。

同样的prompt,Sora生成的视频长度、质量都显著领先。根据用户Gabor Cselle的测 试,将Sora和Pika、RunwayML和Stable Video进行了对比。在采用了与OpenAI示例中 相同的prompt的基础上,结果显示其他主流工具生成的视频都大约只有5秒钟,而Sora 可以生成一段长达17秒的视频,并在视频场景中保持动作和画面一致性。

画质大幅提升,或冲击AI文生图片行业。OpenAI通过在一个时间范围为一帧的空间网 格中排列高斯噪声块来实现生成图片。该模型可以生成可变大小的图像,最高可达 2048×2048分辨率。可以看到,Sora生成的图片画质有了大幅提升,非常清晰,此前 的文生视频产品由于清晰度不足的原因,与文生图赛道暂未有强烈地竞争,但我们认 为随着文生视频画质能力的提升,图片作为单帧的视频,文生视频领域的产品或将冲 击文生图行业。

OpenAI推出的AI文生视频产品Sora,让文生视频行业实现了跨越式的发展,生成视频 时长的突破、多角度镜头、强大的语言理解能力等都让Sora大幅领先行业竞品,也让 AI文生视频、文生图、图生视频、视频生视频的落地性大幅提升,有望在多个行业领 域应用落地。此外OpenAI的研究证明,训练计算的提升可以提升生成视频的样本质量, 因此Sora的推出也展现出文生视频行业对大量算力的强烈需求。

建议关注:

1)AI文生 视频行业发展带动AI行业应用落地的机遇;

2)AI行业发展对算力、光模块等基础设 施的持续需求;

3)AIGC在媒体、游戏等行业的加速落地带来的投资机遇。

特别声明:内容仅代表个人观点,不构成任何投资指导,据此买卖,盈亏自负,股市有风险,投资需谨慎!