OpenAI新近推出的o1模型,确实成了当下人工智能领域备受瞩目的焦点。不过这款号称“学会思考”的AI究竟怎样定义“思考”还有它是否真的达成了认知上的质变,还得更理性深入地去剖析。

到了2025年,随着o1模型慢慢推广开来,它不但带来技术上的细微改进,而且让我们瞧见了智能辅助时代的潜在契机,可这可不是一次彻底颠覆性的变革,而是技术发展里不容小觑的里程碑。

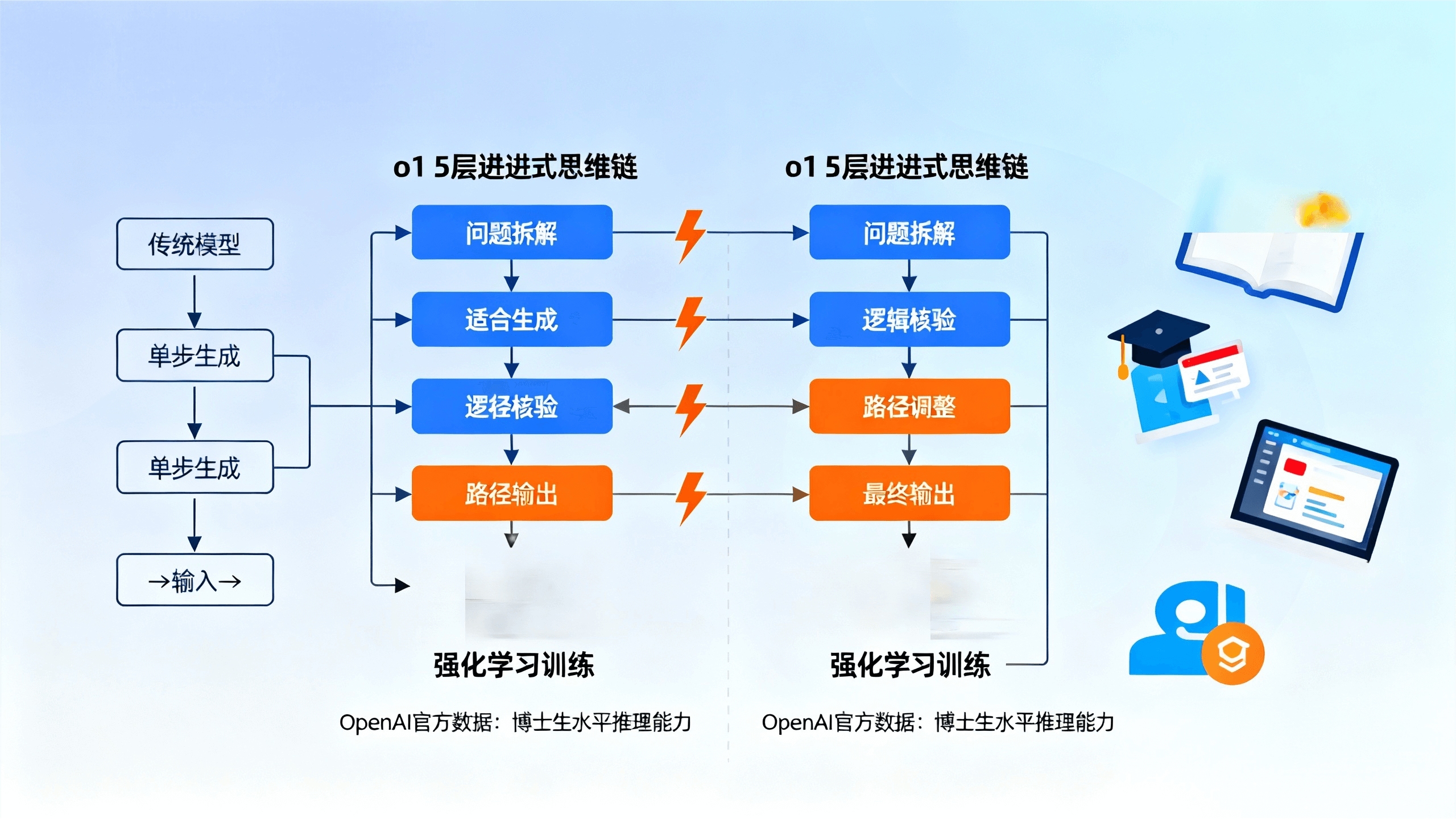

o1模型的发布,延续了OpenAI近年来聚焦强化学习与多步推理的发展方向。

其最为突出的特点是依循模拟人类“思考链”的运作机理,开展分步式推理、自行修正以及策略方面的调整,而且这样便会提高解决复杂问题时的精准程度。

在多项公开测评中,o1于科学、数学及编程领域展现出色,特别是在GPQAdiamond这类高难度考核中,表现近乎达到博士水准。

不过最新公开的数据也表明,o1虽说有明显提升,但还是存在局限,它可不是什么都能行,特别是在一些基准测试里,竟然比不上同期的其他模型像o3。而且“思考”大多是模型靠算法模拟出来的复杂逻辑处理,并非真正人类那样的认知。

这场技术革新正不断促进各行各业加快智能化步伐。

o1模型在多步推理方面的能力大幅提升,着实让内容创作、软件开发以及技术研究的效率得以提高,而且还使得众多传统的劳动力密集型工作有了优化的态势。

然而与此同时,也加大了劳动力市场的结构性调整压力,特别是在高技能职业人群当中。

社会所遭遇的挑战不单单是自动化引发的就业方面的变化,而且还有众人对于智能技术伦理、安全以及隐私的担忧。

于治理层面,智能推理技术被用于决策辅助与舆论引导,催生了新的监管难题以及权力博弈,国际社会对此呈现出高度关注且有策略性布局。

不过,技术壁垒和伦理争议仍不可忽视,

o1模型尽管在技术层面实现了“长思考”与“自我纠错”,但其本质仍是复杂运算的产物,所谓的“思考”并不包含主观意识,因此在伦理责任的界定、偏见的消除以及系统安全性方面,仍未实现根本性突破。

更为严峻的是,由于模型能产出极具欺骗性的内容,可能被用来炮制误导性信息乃至深度伪造内容,从而引发新的社会安全风险。

随着用户对AI依赖程度的加深,容易陷入信息茧房,进而削弱判断能力,影响社会交往。

在这种情况下,个人、行业以及政策制定者都需要重新调整对人工智能的理解与应对策略。

就个人来讲,保持独立思考与批判性判断挺重要的。而且还要主动去掌握AI运用的窍门,来适应那新兴的工作模样。

行业与监管部门需携手建立多样化的伦理规范与合规准则,促进技术公开透明以及责任的有效落实。

未来的方向大概率是人与机器协同共存的模式,而不是相互取代或完全分开,这要求社会在技术进步与价值取向之间实现平衡。

综合来看,OpenAIo1模型是AI技术朝着更高智能水准迈进的典范之作,然而它并没有真正达成拥有人类意识般的“思索”反而是凭借更繁复、更精准的计算来模拟从而获取更优解答的进程。

咱们可不能盲目迷信AI的“思考”本事而且也绝不能对它所引发的深刻变革和挑战视若无睹。

在“思考型”人工智能面前,是主动迎接变革,还是保持警惕规避潜在风险?

此抉择会深远左右今后社会的发展走向,着实值得每一位关注科技的人去思索并参与探讨。

参考来源和文献清单:

OpenAI. (2024).Introducing o1. OpenAI Blog Post.

2.OpenAI. (2024).Learning to reason with process-based rewards. OpenAI Blog Post.

3.Lightman, H., et al. (2024).Weak-to-strong generalization: Eliciting strong capabilities with supervised fine-tuning. OpenAI Research Preprint.

4.OpenAI. (2024).o1: Our first model capable of reasoning. OpenAI Technical Report.

5.Vaswani, A., et al. (2017).Attention is all you need. In Advances in Neural Information Processing Systems (NeurIPS), 30.

声明:本文旨在探索科技趣味,超90%内容为原创撰写。创作中使用AI工具增效,所有知识点均经人工核实。图片素材均为实拍或AI生成。坚持分享前沿科技,传播正能量。