2026年1月,瑞士达沃斯世界经济论坛上演了一场关于AI的世纪辩论。

当有人质疑"美国AI投资是否存在泡沫"时,英伟达CEO黄仁勋给出了截然相反的答案:这不是泡沫,而是人类历史上最重要的基础设施建设。

数据显示,全球已经为AI基建砸下数千亿美元,但黄仁勋却断言"还需要再投入几万亿美元"。

背后那个惊人数字的后面,到底是资本胡乱地乱花钱,还是技术革新的必定需求?

要弄明白这场争议,首先得弄清楚AI算力战争的真实情况。

黄仁勋的判断:几万亿只是开胃菜,算力永远不够用在达沃斯的对话中,黄仁勋给出了一个颠覆认知的预测:到2030年,全球需要投入3万亿美元用于AI基础设施建设。

他的逻辑很简单——AI算力需求的增长速度,远远超过任何人的想象。

英伟达在CES2026上发布的最新VeraRubin平台,GPUAI推理性能提高了5倍,不过黄仁勋说这还不够。

AMDCEO苏姿丰也在同期表示,未来几年AI算力需求将增长100倍。

这不是科技巨头的危言耸听,而是基于一个残酷的现实:当AI从"能聊天"进化到"能办事",算力消耗呈现指数级爆炸。

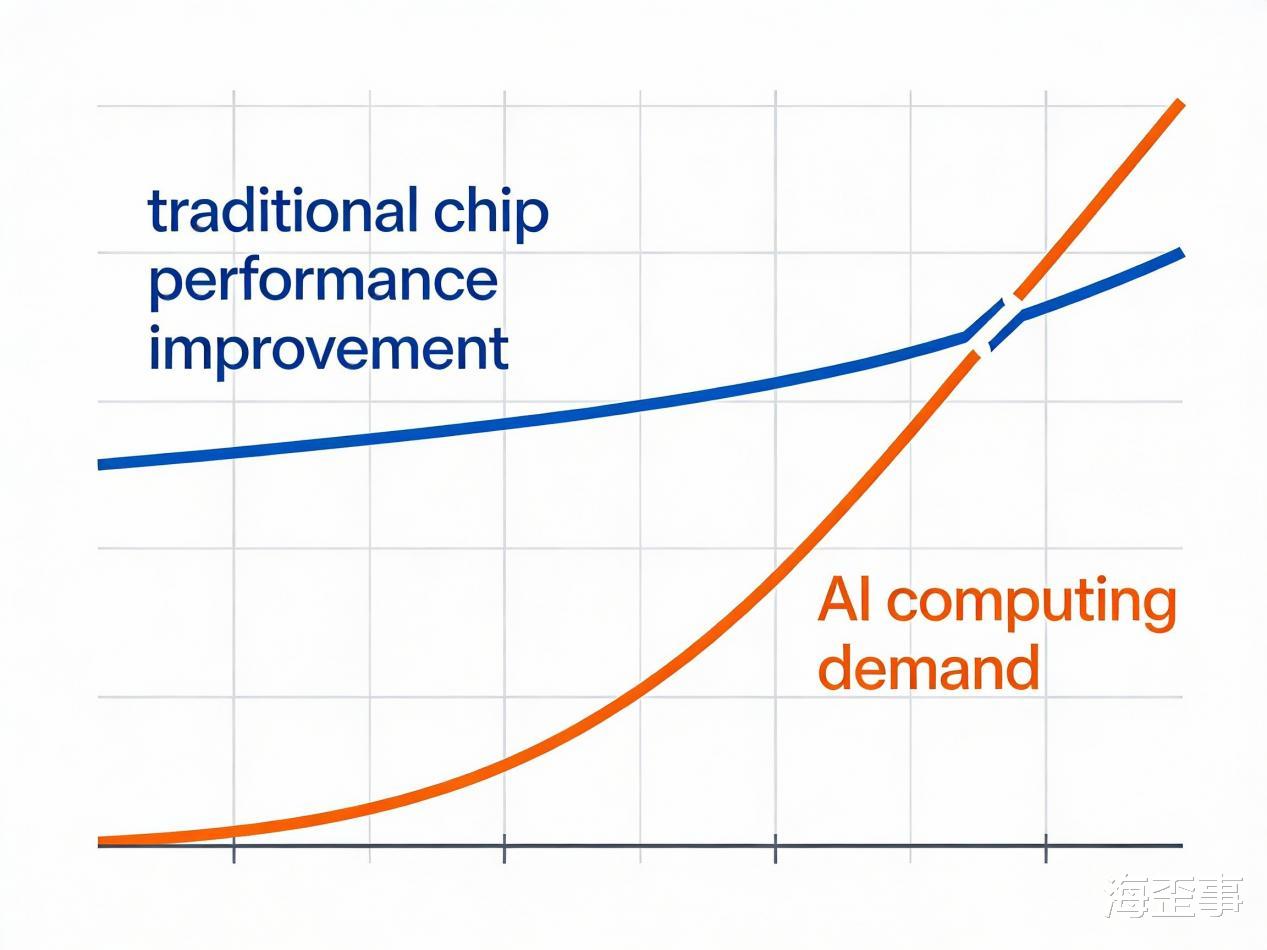

一个让人很吃惊的数据显示出问题很严重,AI算力需求每3.4个月就翻倍,一年增长幅度达到10倍,这意味着什么?

对比一下就知道——摩尔定律预测芯片性能每18个月翻倍,而AI算力需求的增速是摩尔定律的5倍还多。

贝恩公司2025年技术报告显示,全球算力因为这种供需不均衡正出现危机。

更直观的例子就是,训练一个GPT-4级别的大模型所消耗的电力,够给一座中型城市供好几个月的电,而随着多模态AI、AIAgent等新应用爆发,这个"电老虎"的胃口还在持续扩大。

芯片制造技术的进步速度,根本追不上AI模型的"吃饭"速度。

你看看,最近AI有新进展就知道算力有多重要。

2023年,ChatGPT火得全世界都知道,而背后却是上万块英伟达A100 GPU日夜运转,再到后来的DeepSeek-V3,训练成本约558万美元,使用2048块H800芯片,总计耗时278万GPU小时。

更疯狂的是,谷歌、Meta、亚马逊这些科技巨头,为了不依赖英伟达,各自拿出好几百亿美元来自己研究AI芯片。

抢算力的话语权,本质上,谷歌的TPU、特斯拉的Dojo、苹果的M系列芯片都是如此。

这场"芯片军备竞赛"背后的逻辑很简单:谁掌握了算力,谁就能在AI时代占据制高点。

未来预期:AIAgent、具身智能、自动驾驶都在排队等算力如果说现在的AI已经"很费电",那未来的需求只会更夸张。

黄仁勋在达沃斯预测,未来十年世界上大部分汽车将实现自动驾驶或高度辅助驾驶,每辆车都需要强大的AI算力支撑。

人形机器人、AIAgent(智能体)、脑机接口这些技术正从实验室往产业化走,它们得实时处理大量的数据,还要做出毫秒级的决策。

更关键的是,AI正在从云端往边缘走你的手机、汽车、家电都会内置AI芯片,组成分布式算力网络,不光在数据中心,算力需求会很快变多,而且,它还会进到生活的每一个地方。

黄仁勋口中"10亿倍算力提升"的未来,指的正是这种全场景AI时代。

回到开头的问题:1.5万亿美元够不够?

答案显然是不够。

但这场算力战争,可不只是科技巨头的事儿,它正在偷偷改变每一个普通人的生活。

你的手机为什么越来越智能、为什么电动车能自动泊车、为什么AI助手开始真正"听懂人话",背后都是算力基础设施在支撑。

黄仁勋说得对,这不是泡沫,而是像修高速公路、建电网一样的基础设施投资。

前所未有的,是这次建设的速度以及规模,这便是区别所在。

对于我们来说,弄清楚这场算力革命意味着什么很重要,因为它和你未来的职业方向、创业机会,还有生活方式的根本改变都有关系。

这个时代,算力就是新的石油和电力。