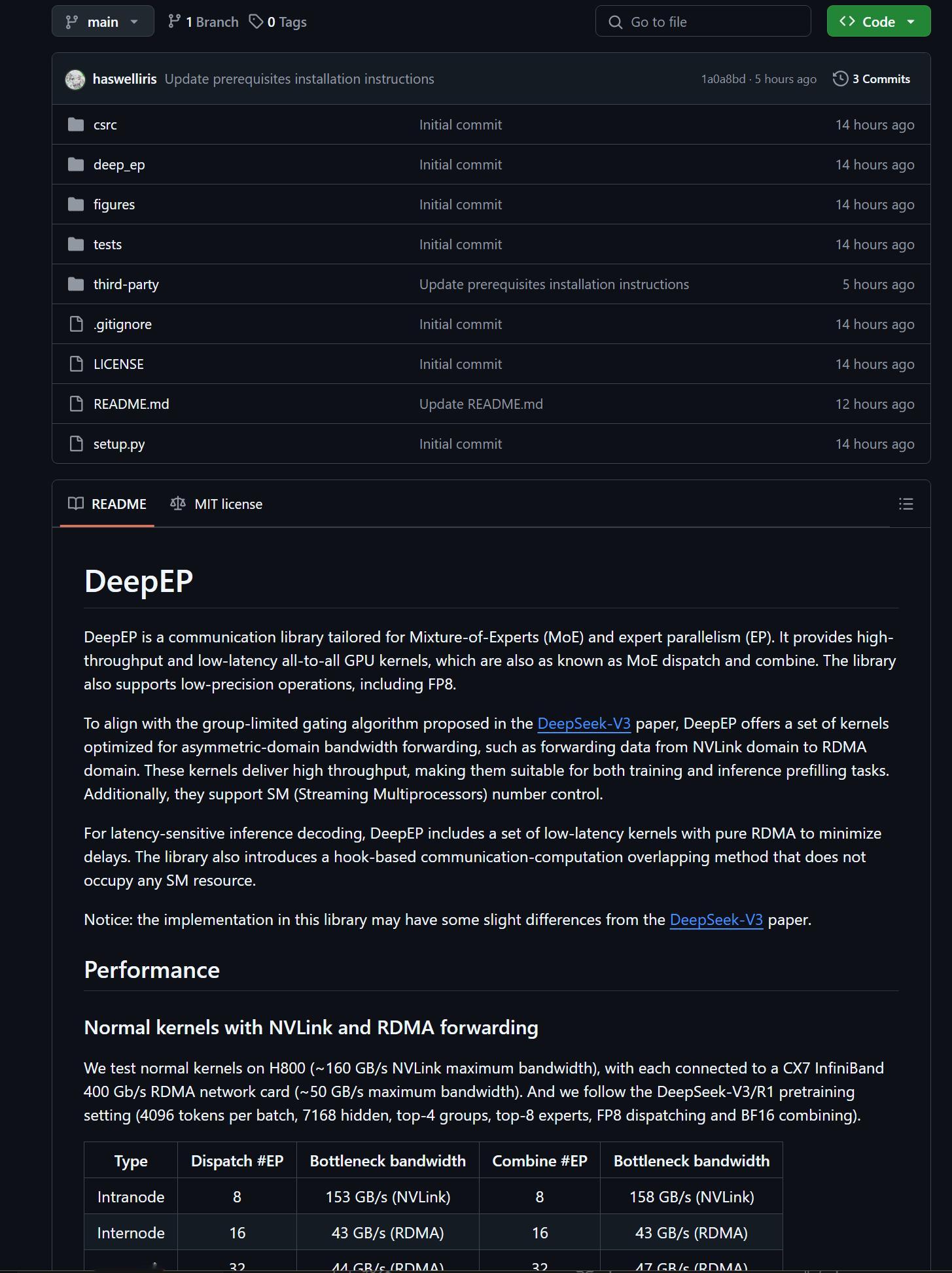

🔻Day 2,Deepseek 更新了他的五个开源库解锁计划中的第二个:DeepEP。

🔻DeepEP 是专为专家混合(MoE)和专家并行(EP) 设计的通信库,提供高吞吐、低延迟的全对全(all-to-all)GPU 计算核,也被称为 MoE dispatch 和 MoE combine。

🔻要理解 DeepEP 的工作原理,可以想象一条繁忙的高速公路,汽车代表数据,而城市道路规划和设计则象征计算机组件。如果没有规划完善的道路和交通规则,拥堵和延误将不可避免。DeepEP 的功能就像为实现最高效率而设计的先进高速公路系统,通过几个关键功能确保数据流的顺畅和快速。

🔻亮点是:

🔹高效的 all-to-all 通信。DeepEP 优化了全对全 GPU 通信模式,支持节点内(利用 NVLink)和节点间(利用 RDMA)的高效数据传输,显著减少大规模 GPU 集群中的通信瓶颈。相当于高速上的每辆车都拥有一条属于自己的车道,并且开了导航。

🔹支持 FP8 等低精度操作。csrc/kernels/ibgda_device.cu 中的定制内核设计,通过支持本机 FP8 调度和 BF16 组合等低精度计算,DeepEP 在不大幅牺牲精度的前提下提升计算速度并减少内存占用(图3)。

🔹优化的内核设计,高吞吐量内核:针对训练和推理预填充任务,优化了不对称域带宽转发(如 NVLink 域到 RDMA 域),确保数据传输的高效性, H800 GPU 上普通内核可实现 153 GB/秒(节点内)和 43-47 GB/秒(节点间)的瓶颈带宽。

🔹优化的内核设计,低延迟 GPU 内核:为延迟敏感的推理解码任务提供纯 RDMA 的低延迟通信支持。相当于上下高速不经过收费站了(调度延迟低至 163 微秒,组合延迟低至 318 微秒,RDMA 带宽始终保持在 39-46 GB/s 左右)。

🔹灵活的 SM 控制。支持对流式多处理器(SM)数量的动态调整,用户可根据任务需求灵活分配 GPU 资源。

🔹hook-based 的通信-计算重叠。通过引入不占用 SM 资源的通信-计算重叠机制,允许对所使用的 SM 数量进行明确控制,优化特定工作负载的资源分配,进一步提升训练和推理的并行效率。

🔻重点是:

🔻提升 MoE 模型效率。DeepEP 通过优化通信模式和支持低精度操作,显著减少了 MoE 模型在训练和推理中的通信开销与计算负担,是大规模 AI 模型开发的重要工具。

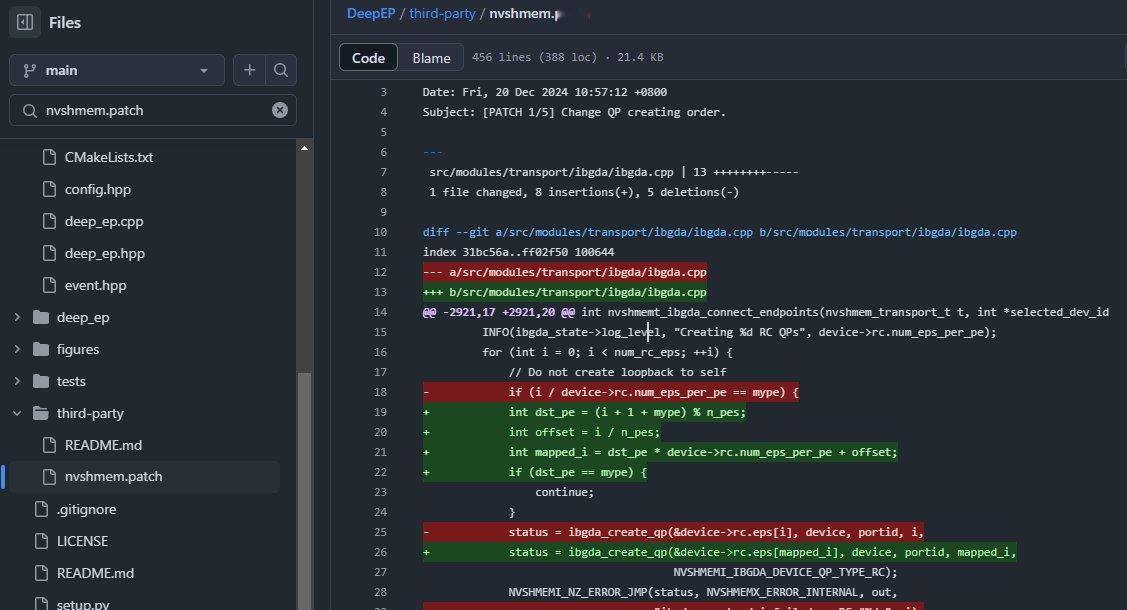

🔻适配高性能计算环境。在 H800 GPU 和 InfiniBand 网络上的测试验证了其优越性能,同时理论上兼容 RoCE,为用户提供灵活的网络选择(比如,使用一条行为未定义的 PTX 指令"ld.global.nc.L1::no_allocate.L2::256B"在 Hopper 体系结构上获得极高的性能)

🔻针对不同任务的优化。DeepEP 为训练、推理预填充和解码等场景提供了专门优化的内核,确保在各种应用中均能实现最佳性能。

🔻代码是开源的。足够多的使用者会推动内核不断迭代。

🔻开源盛世。