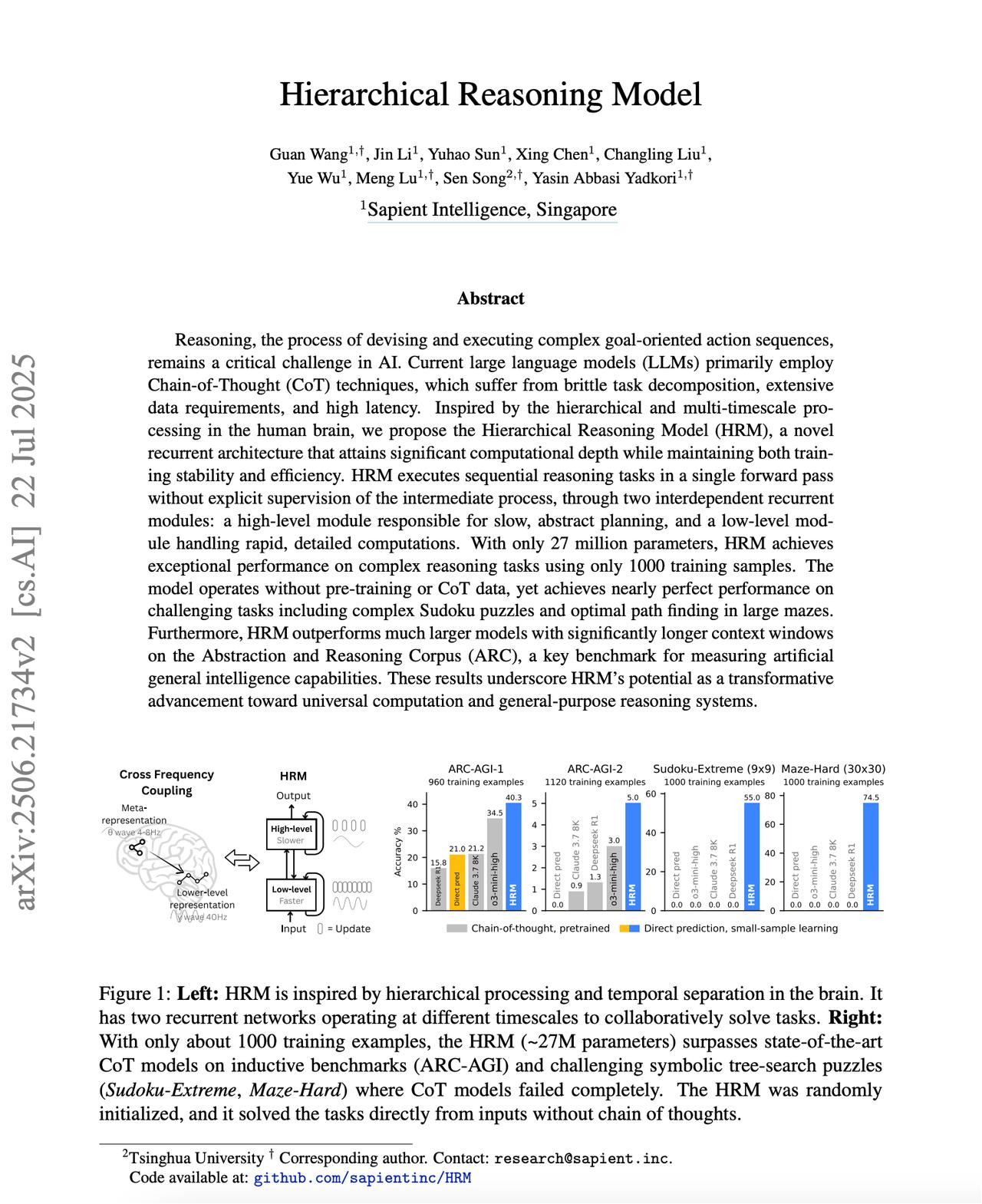

#无需思维链提升模型推理能力##1千样本小模型ARC突破40分# 无需预训练或思维链,就能展现出超强推理能力? 一篇来自新加坡Sapient Intelligence的研究人员的论文,引发了热议。 研究人员受人类大脑信息处理机制启发,推出了层次推理模型(HRM)。 仅需2700万参数,使用1000个训练样本,就能在ARC-AGI里收获40.3%的高分。 现有的大语言模型主要依赖于思维链技术,这种方法存在任务分解脆弱、数据需求量大和响应延迟高的问题。 HRM的设计灵感来源于人类的大脑,它采用了两个相互依存的循环模块:一个负责慢速、抽象规划的高层模块,和一个处理快速、详细计算的底层模块。 通过高层模块和底层模块的配合,模型在复杂任务面前也能游刃有余,这个配合过程具体可以分为以下几个部分: - 高层模块(H-module):负责制定整体策略,它在每个周期结束时接收底层模块的最终状态,并据此调整策略。 - 底层模块(L-module):底层模块负责具体的计算任务,在每个周期内快速更新,每一步都基于前一步的状态和高层模块的策略。 - 层级收敛(Hierarchical Convergence):标准的循环神经网络(RNN)容易快速收敛,导致后续计算停滞。HRM通过高层模块的慢速更新和底层模块的快速迭代,避免了这种快速收敛,显著增强了模型的推理能力。 HRM 在多个复杂任务上的表现令人瞩目,尤其是在小样本学习场景下,性能出色。【图2】 - ARC-AGI:在ARC-AGI-1中,HRM使用960个训练样本,达到了40.3%的准确率。显著高于o3-mini-high(34.5%)和 Claude 3.7 8K(21.2%)。 - Sudoku-Extreme:HRM在Sudoku-Extreme测试中达到了55%的准确率,而其他大模型几乎无法解决这些难题,准确率接近0%。 - 30×30迷宫:HRM在30×30迷宫测试中达到了74.5%的准确率,而其他大模型在这一任务上几乎无法找到最优路径,准确率接近0%。 感兴趣的朋友,可以阅读论文原文: 代码仓库: