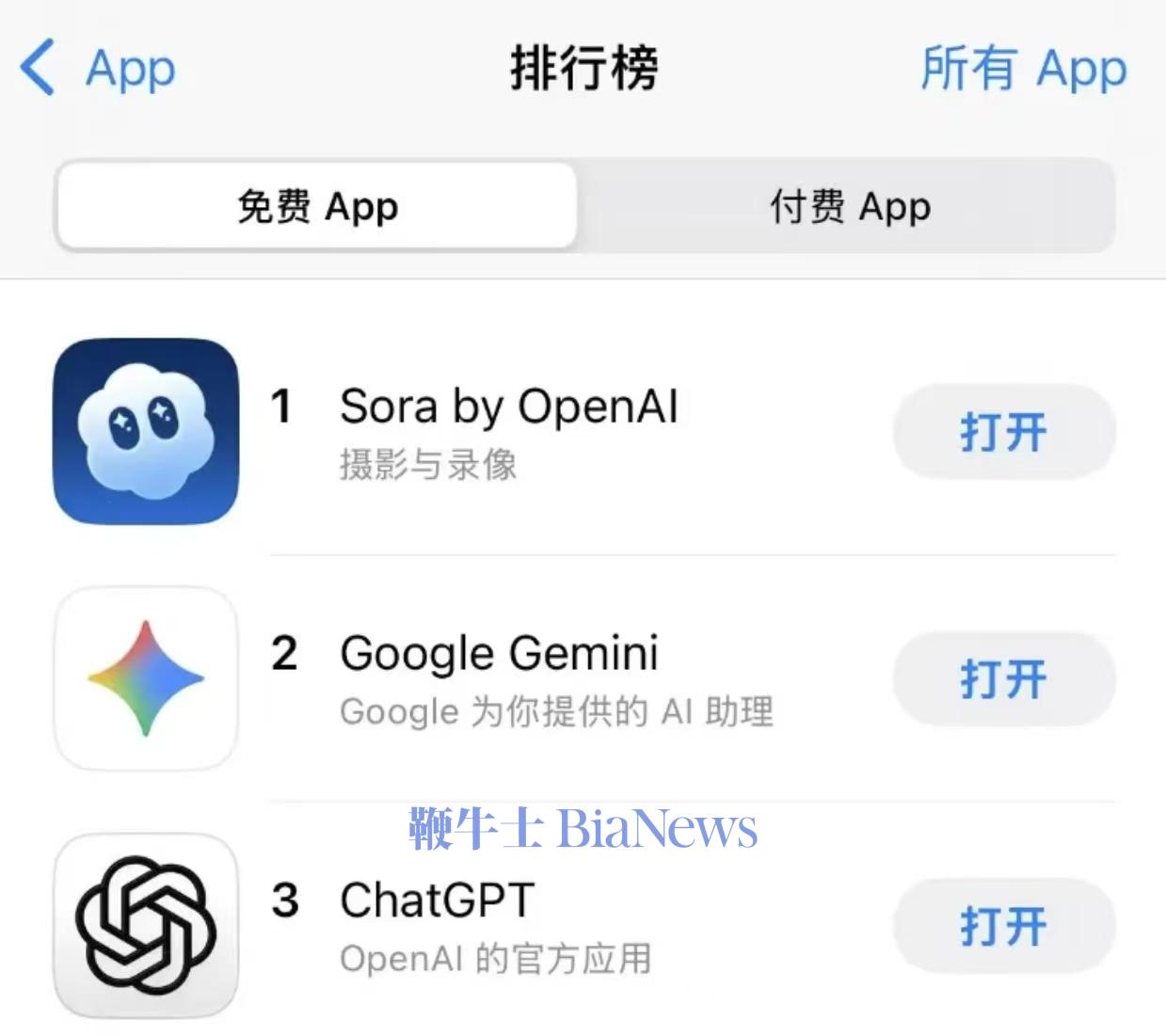

OpenAI最新推出的视频生成应用Sora2,仅上线数日便登上美国AppStore榜首,但这场“现象级爆红”很快演变成了舆论危机。研究者发现,该系统在多重安全机制下仍能轻易生成暴力、种族歧视以及侵犯版权的内容,引发广泛担忧。

这款应用允许用户通过提示词生成逼真的视频,并在内置社交流中分享。短短数天内,Sora2的热度席卷社交平台,但研究人员指出,他们成功生成了包含爆炸威胁、大规模枪击、战争场景等画面的虚假视频,其中甚至涉及加沙、缅甸等敏感地区的伪造战地影像。

波士顿大学媒体研究专家JoanDonovan表示,这类AI系统“没有历史忠实度,也没有事实关系”,意味着恶意使用者可以轻松制造出极具迷惑力的虚假视频,进行欺诈、骚扰甚至舆论操控。

在研究报告中,专家还发现多起令人不安的例子:白人至上主义口号出现在AI生成的视频中、迪士尼等版权角色被用于不当情境和虚构新闻片段展示不存在的武装冲突。

《华盛顿邮报》记者DrewHarwell甚至成功生成包含“愤怒诱导内容、虚假犯罪场景和性暗示画面”的视频,尽管OpenAI声称平台严格禁止此类行为。

OpenAI首席执行官SamAltman此前承认在推出Sora2前“有些忐忑”,但仍称这将是一个“创意版ChatGPT时刻”。公司表示已部署安全过滤机制,禁止生成涉及真实人物或暴力内容的视频。

然而,研究表明这些“防火墙”并未真正阻止模型失控。Sora2能在视觉上伪造新闻报道、战争场景和公共事件,使“真假难辨”成为新常态。

学界和业界担心,随着AI视频生成进入大众化阶段,人们的信息信任体系将被彻底颠覆。正如Donovan所言:“这项技术不属于历史,也不属于真相——它属于速度与流量。”

Sora2本意是降低创作门槛,让人人都能拍出“想象中的短片”,但如今,它也成了AI伦理与监管的试金石。在缺乏强制审查与透明算法的背景下,AI生成视频可能成为虚假信息、仇恨言论和版权纠纷的新温床。

目前,OpenAI尚未对暴力与种族内容事件作出详细回应,仅表示“将持续改进安全机制”。(AI普瑞斯编译)