[LG]《LaDiR: Latent Diffusion Enhances LLMs for Text Reasoning》H Kang, Y Zhang, N L Kuang, N Majamaki... [University of California, San Diego & Apple] (2025)

LaDiR:潜变量扩散模型助力大语言模型文本推理

🔍 论文链接:arxiv.org/abs/2510.04573

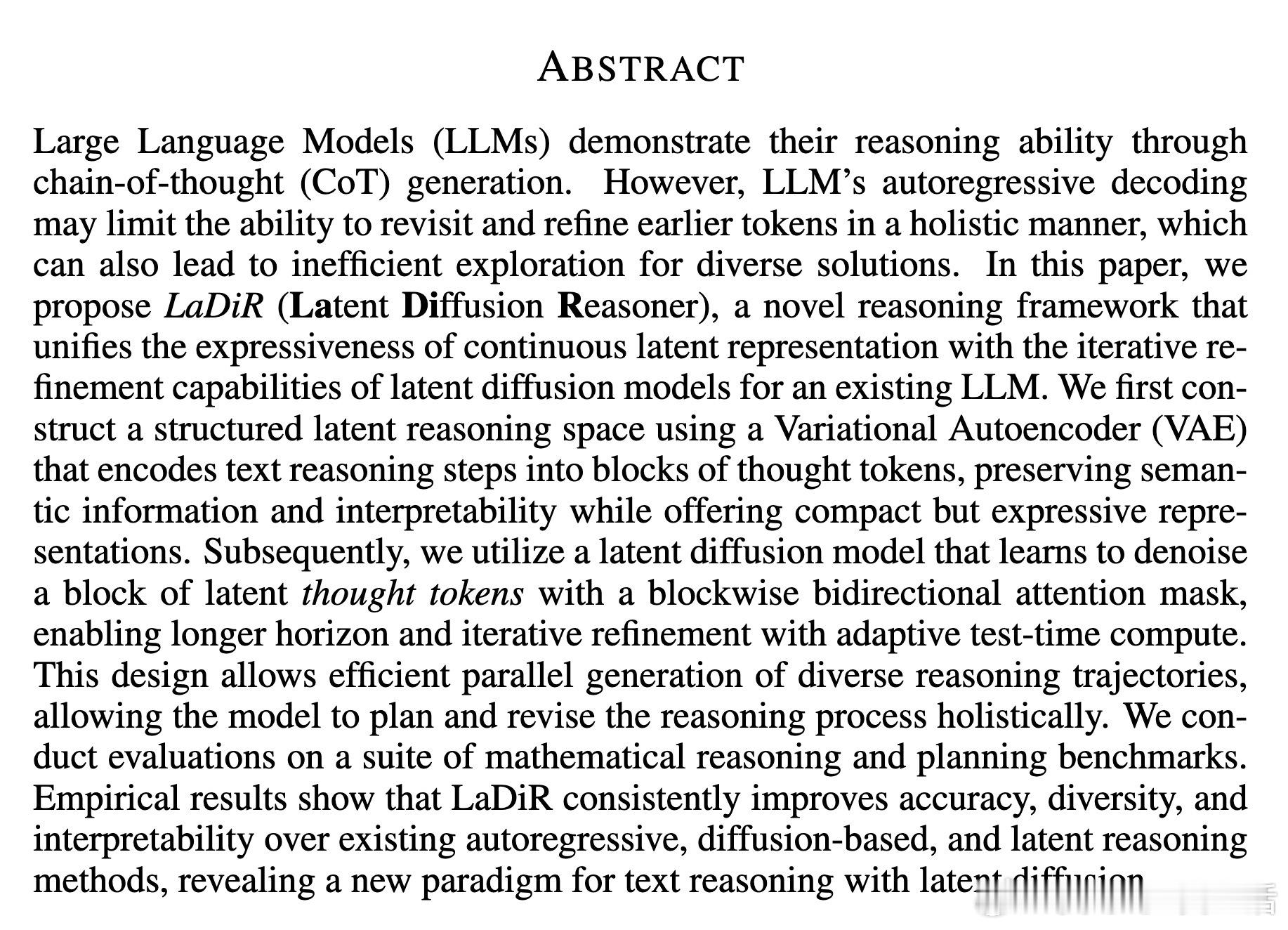

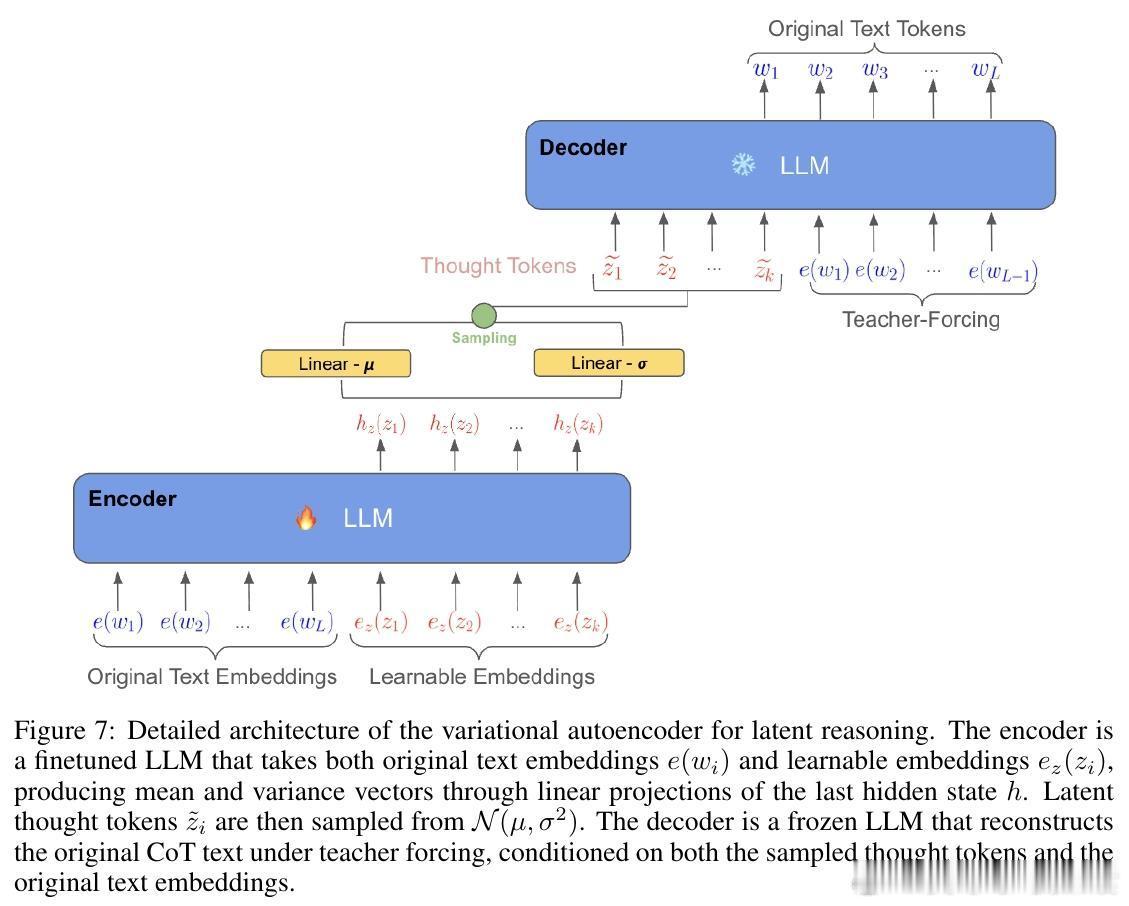

大语言模型(LLMs)通过链式思维(CoT)展现推理能力,但传统自回归(AR)生成存在无法整体回顾和优化早期生成内容的限制,且探索多样解法效率低。本文提出LaDiR(Latent Diffusion Reasoner),创新结合变分自编码器(VAE)构建语义丰富且可解释的潜在推理空间,利用潜变量扩散模型对推理步骤进行迭代精炼,从而突破AR模型的局限。

核心方法:

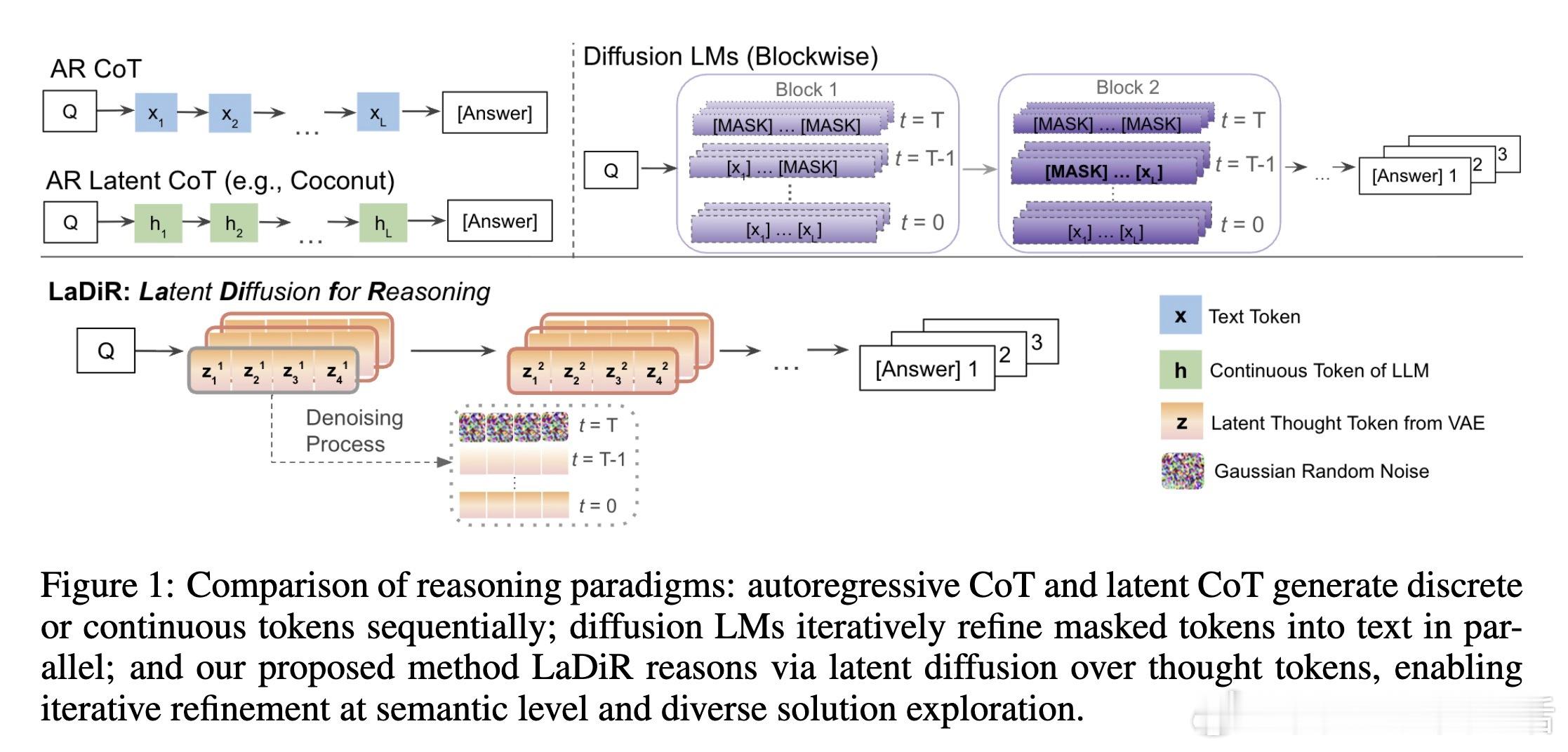

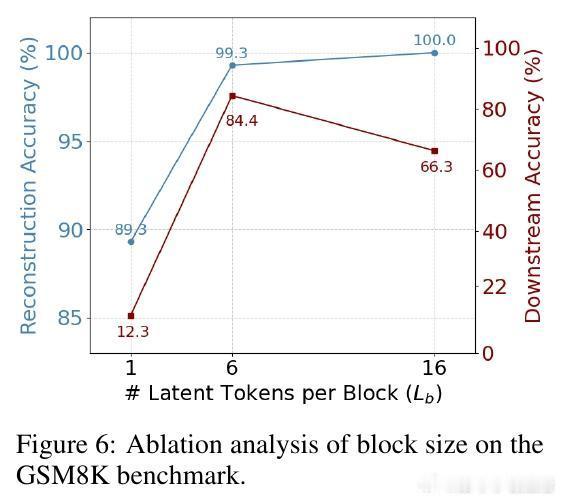

1️⃣ 用VAE将文本推理步骤压缩成潜变量块,保持语义信息与可解读性,且表示紧凑。

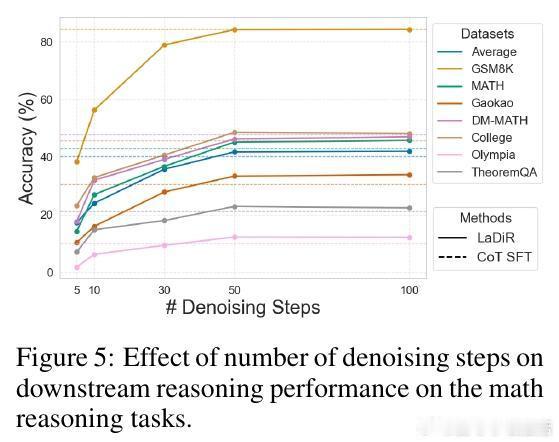

2️⃣ 设计块级双向注意力的潜变量扩散模型,实现从高斯噪声到语义潜变量的迭代去噪,支持长距离依赖与自适应推理复杂度。

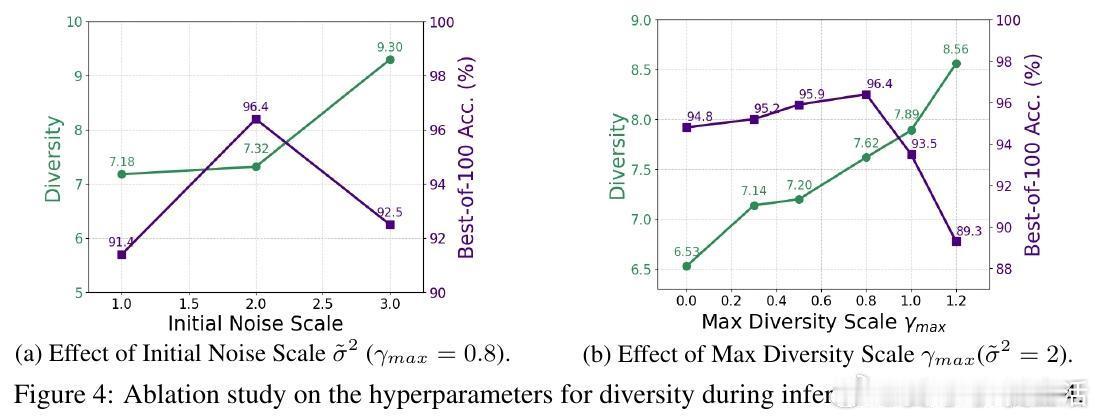

3️⃣ 推理阶段可并行生成多条多样化推理轨迹,通过噪声扩散与排斥机制鼓励解的多样性,实现全局规划与修正。

4️⃣ 最终基于生成的潜变量序列自回归产生答案文本。

实验证明:

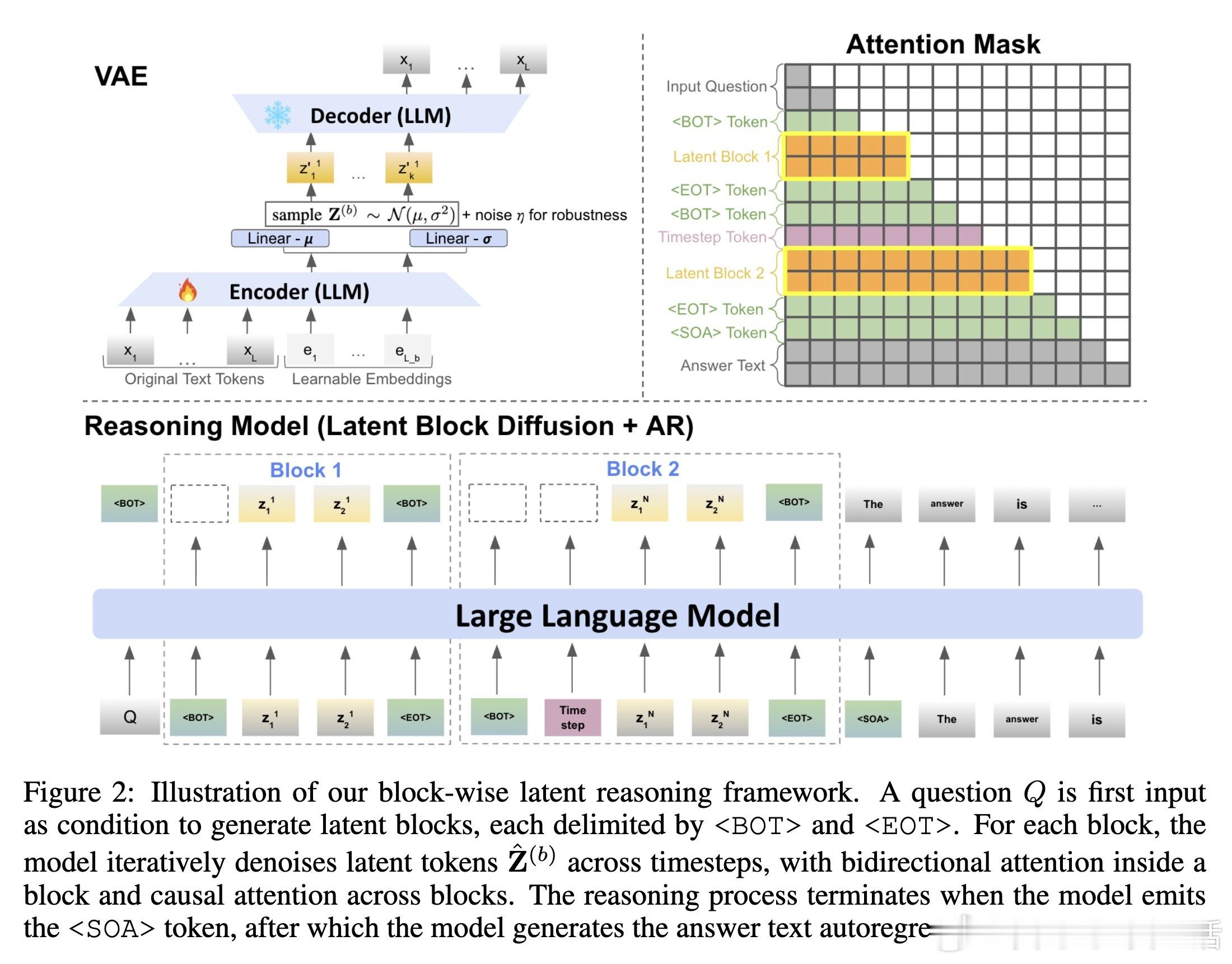

✅ 数学推理(7个基准)和规划任务(Countdown)上,LaDiR显著优于自回归及现有潜变量、扩散方法,提升准确性、推理路径多样性和可解释性。

✅ 在复杂任务中,潜空间推理捕获更抽象的逻辑关系,表现出更强的泛化能力和长程一致性。

✅ 迭代去噪过程展现推理自我修正能力,错误逐步减少,语义推理更符合人类理解。

✅ 计算资源与性能可灵活权衡,更多去噪步骤带来更高准确率。

技术亮点:

🌟 结合VAE与潜变量扩散,开创基于潜变量的文本推理新范式;

🌟 块级扩散与混合注意力设计,兼顾生成灵活性和全局连贯性;

🌟 多样性引导策略助力探索多解路径,提升推理覆盖率和鲁棒性;

🌟 结构化潜变量增强推理轨迹的可视化和解读,促进模型透明度。

总结:

LaDiR提供了一种突破传统自回归限制、实现更智能、更多样、更可解释文本推理的有效路径。未来可望结合更大规模模型和多任务训练,推动LLM推理能力迈向新高度。

大语言模型 文本推理 潜变量扩散 链式思维 机器学习 AI研究