Karpathy 最新项目震撼发布!不到 8000 行代码,完整实现了从训练到推理的 LLM 全流程,堪称开源界的宝藏:

- 用 Rust 实现了高效的 tokenizer 训练

- 在 FineWeb 语料上预训练 Transformer LLM,并多维度评估核心指标

- 中期训练结合用户-助手对话、选择题、工具调用等多样任务

- 监督微调(SFT)后,模型在多项世界知识(ARC-E/C、MMLU)、数学(GSM8K)、代码(HumanEval)测试中表现优异

- 可选用“GRPO”算法进行强化学习(RL),提升数学题解答能力

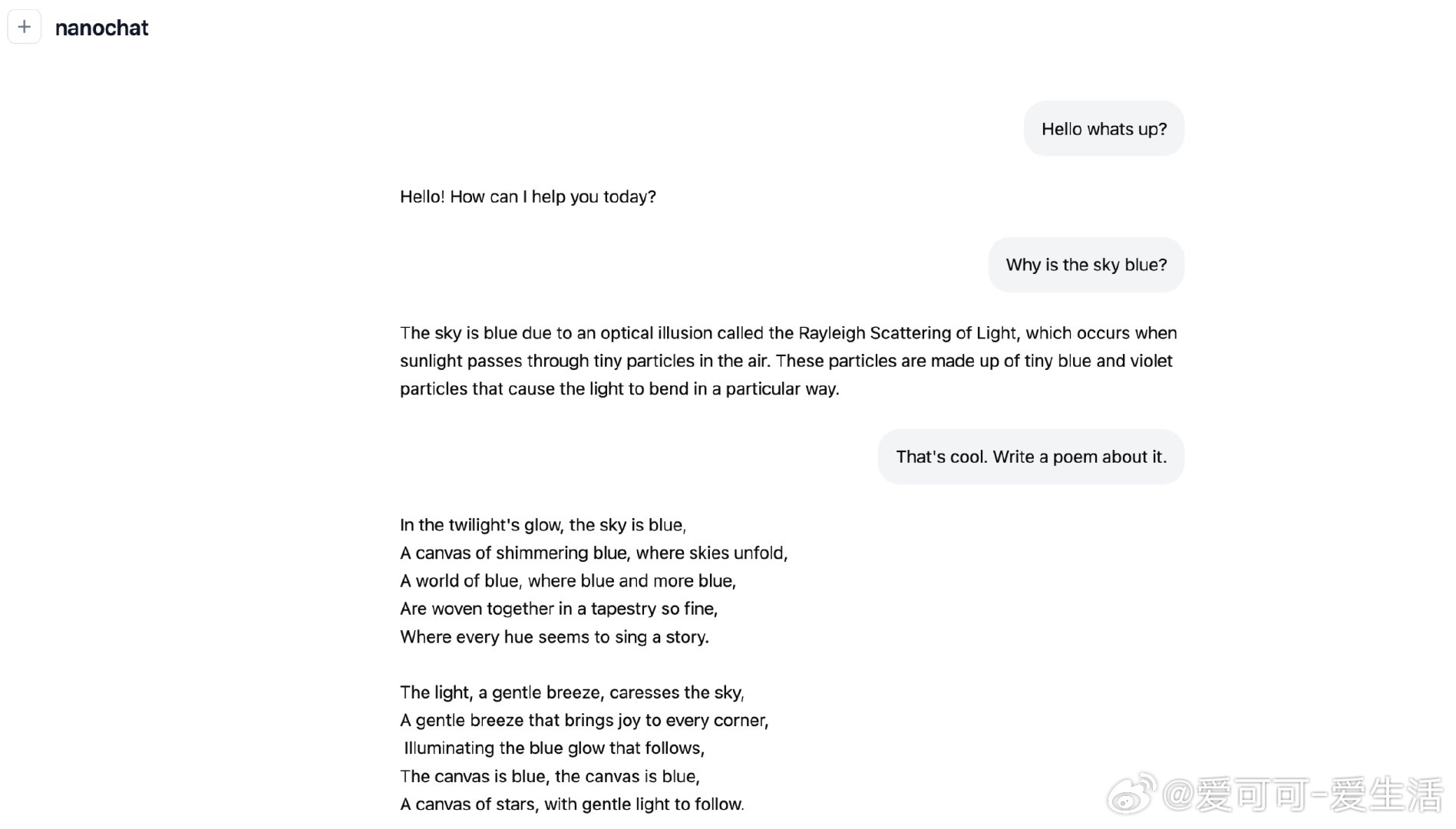

- 轻量化推理引擎支持 KV 缓存、简单预填充/解码,集成 Python 沙箱工具,同时提供 CLI 和类 ChatGPT 网页 UI

- 生成统一的 Markdown 报告,方便总结、打分和游戏化体验

模型架构细节同样亮眼:

类似 LLaMA 的稠密 Transformer,采用 rotary 位置编码、QK 归一化、未绑定的嵌入/反嵌入层、ReLU² MLP,无偏置线性层,简洁高效;优化器结合 Muon 与 AdamW,推理中还用了 logit softcap 技巧。

这不仅是 Karpathy 对开源社区的又一次巨大贡献,更是对入门者极其友好的学习资源。大家纷纷点赞,称赞其代码简洁、训练快速、实现全面,真正实现了人人都能玩转 LLM 的梦想。

如果你对从零开始训练、调优和部署大语言模型感兴趣,这个项目绝对值得深入研究。

🔗 github.com/karpathy/nanochat

---

💡延伸思考

Karpathy 用极简代码展现了训练大模型的全貌,突破了传统复杂框架的壁垒。Rust 的引入体现了追求高性能和安全的趋势,未来 LLM 生态或许会迎来更多类似轻量级、模块化的创新。

此外,项目中对多任务训练和强化学习的结合,展示了 LLM 在实用场景中持续迭代的可能路径。对开发者和研究者来说,这样的开源工具极大降低了门槛,有望催生更多定制化智能应用。

快去试试,让你也体验从基础到实战的完整 AI 训练流程!