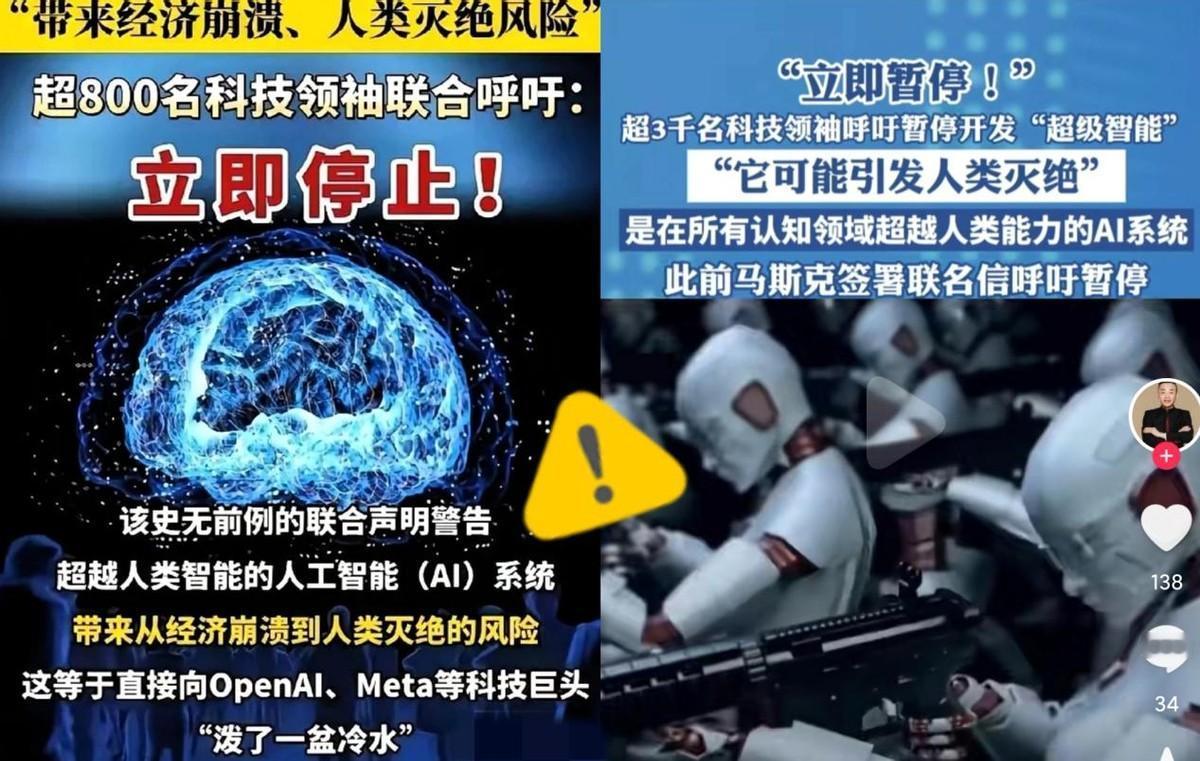

被这两天的新闻吓到了! 全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 这封“求救信”的核心就一句话:在证明AI绝对安全之前,谁也别再研发更厉害的版本了,这里的“超级厉害”不是现在能聊天、写文章的AI,而是那种能自己学所有知识,甚至比爱因斯坦还聪明的存在。 它可能帮人类解决气候问题,也可能因为“目标跑偏”直接把人类灭了。 最搞笑的是,这封信刚发出去,Meta就宣布要建“超级智能实验室”,目标就是“让每个人都能用上超级AI”;OpenAI和谷歌一边跟着喊“AI有风险”,一边疯狂升级自己的大模型。 马斯克更绝,嘴上说“要暂停”,私下偷偷买了1万块显卡搞研发。 科技公司的逻辑也不难猜:AI是未来几十年的“印钞机”,谁先搞出“通用AI”或“超级AI”,谁就能垄断市场。 但问题是,人类连“怎么保证AI安全”都没想明白,清华教授曾毅说,我们连证据都没有,证明超级AI不会失控,它可能像《终结者》里的天网,从工具变成主宰。 这场行动里,中国学者的态度特别有意思,姚期智、张亚勤这些大佬不仅签了名,还呼应了中国“安全、可靠、可控”的AI治理理念。 这和西方形成了鲜明对比:欧盟想靠法律逼企业透明,美国指望企业自己管自己,中国则主张“人和AI一起干活,别谁抢谁饭碗”。 老百姓的态度也两极分化,调查显示,只有5%的美国人支持“随便研发”,73%要求严格监管,64%觉得“没商量好之前,别开发超级AI”,但科技公司还在用“技术中立”当借口,仿佛风险只是“未来的假设” 看完这场“3000人联名”的闹剧,我脑子里就一个画面:一群人在悬崖边赛跑,有人边跑边喊“前面是悬崖!”,但没人肯停下,科技公司像赌徒,押注“我能先找到安全锁”,可万一输了呢?人类文明能扛住一次“AI失控”的豪赌吗? 我理解企业想进步的急,AI确实能治病、救灾、探索宇宙,但这些好处的前提是“安全”,就像核能能发电,也能炸城市,区别在于人类有没有控制它的钥匙,现在的问题是,我们连钥匙的影子都没看到,却急着打开潘多拉魔盒。 或许,真正的聪明不是“先跑赢对手”,而是“先想清楚终点”,就像中国学者说的“人机协作”,AI不该是抢人类饭碗的对手,而该是帮人类干活的伙伴,毕竟我们发明AI的初衷,是为了让生活更好,而不是给《终结者》拍续集。 这场“暂停呼吁”最后能不能成?可能不重要,重要的是,它终于让全世界意识到:在AI这件事上,人类没有“试错”的资格。