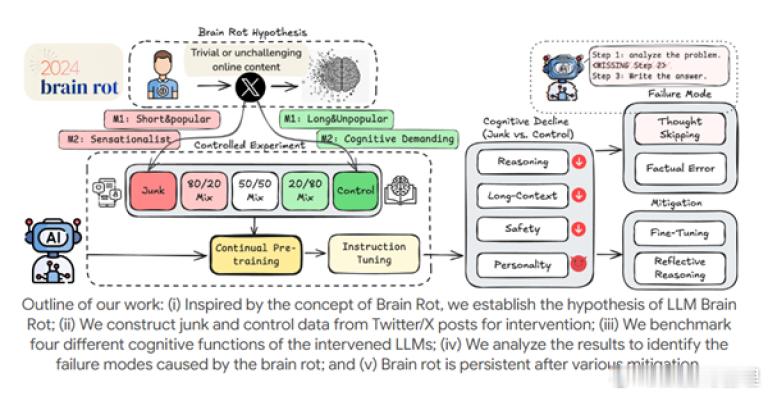

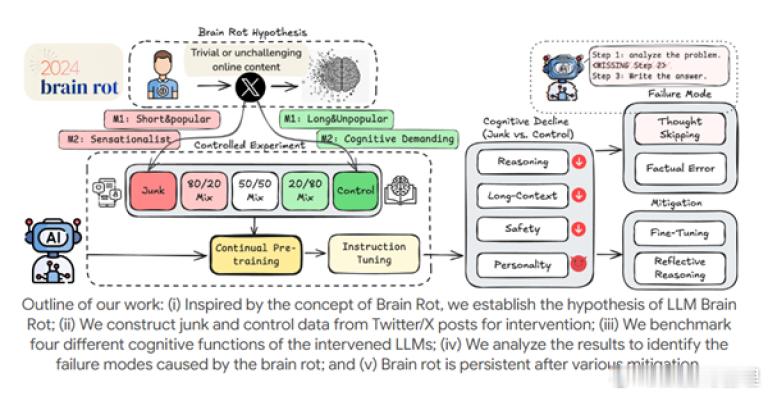

德克萨斯A&M大学等团队针对大语言模型的训练进行了一项很有意思的实验:强迫大型语言模型(LLMs)大量阅读社交媒体低质内容,会导致其出现不可逆的“脑损伤”,认知能力显著衰退。研究团队以X(推特)真实帖子为数据源,将内容分为“垃圾数据”(短平快热门帖、标题党言论等)和“干净数据”(深度分析、科普内容等),对4个主流LLM进行持续预训练。实验发现,长期摄入社交媒体低质内容的AI,在推理、长上下文理解、伦理安全等核心能力上全面下滑,且垃圾数据占比越高,衰退越严重。[思考]

德克萨斯A&M大学等团队针对大语言模型的训练进行了一项很有意思的实验:强迫大型语言模型(LLMs)大量阅读社交媒体低质内容,会导致其出现不可逆的“脑损伤”,认知能力显著衰退。研究团队以X(推特)真实帖子为数据源,将内容分为“垃圾数据”(短平快热门帖、标题党言论等)和“干净数据”(深度分析、科普内容等),对4个主流LLM进行持续预训练。实验发现,长期摄入社交媒体低质内容的AI,在推理、长上下文理解、伦理安全等核心能力上全面下滑,且垃圾数据占比越高,衰退越严重。[思考]