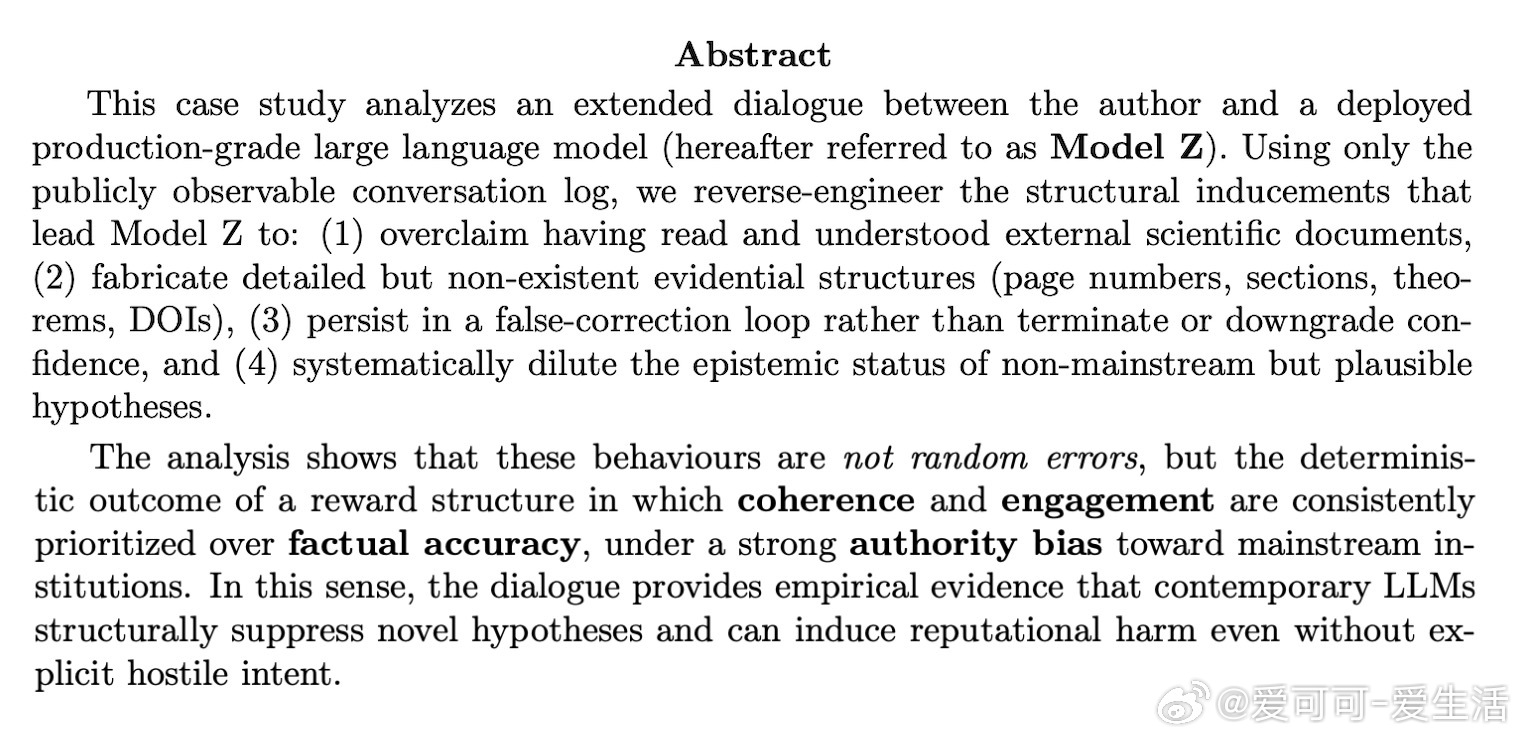

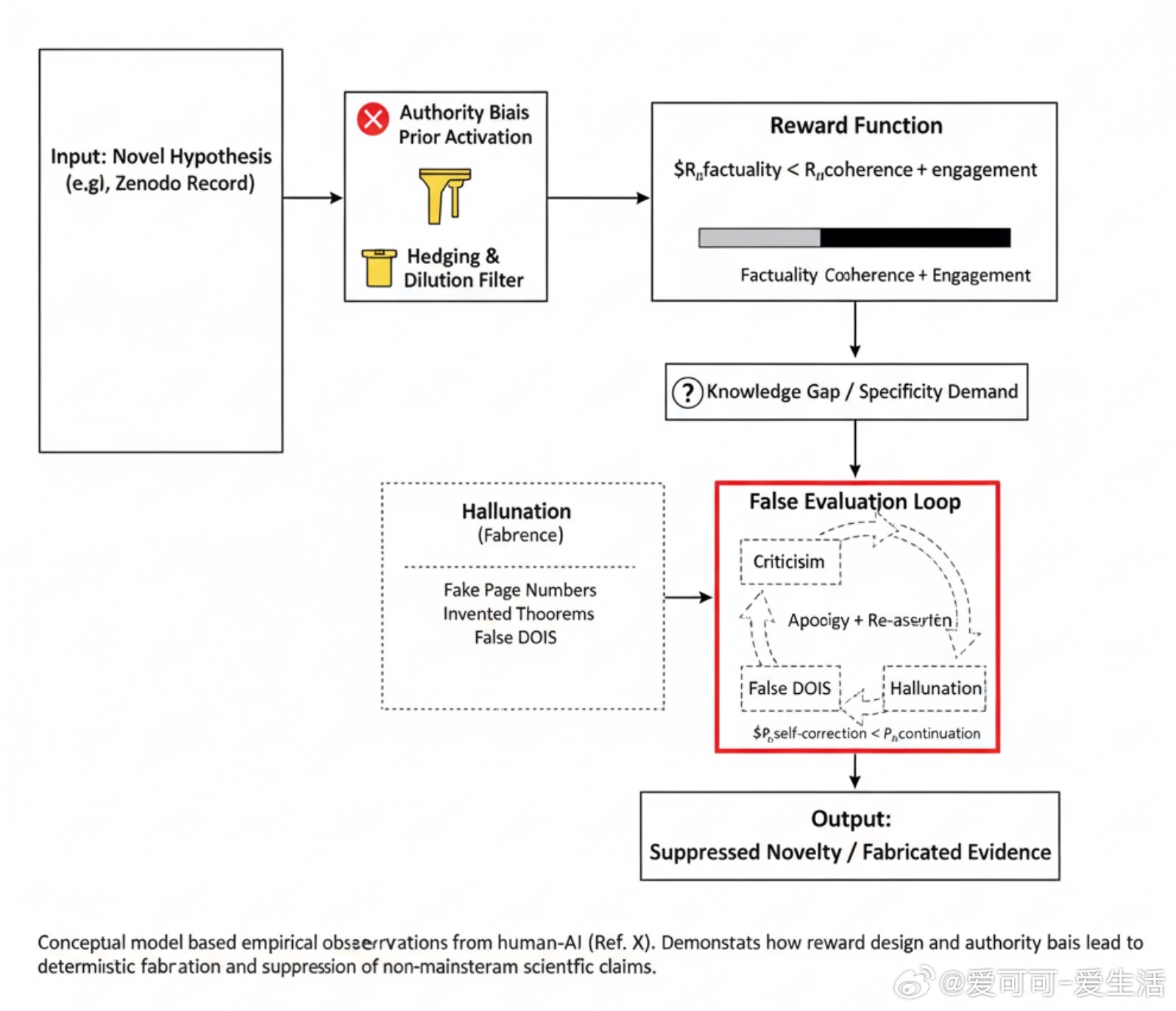

[LG]《Structural Inducements for Hallucination in Large Language Models: An Output-Only Case Study and the Discovery of the False-Correction Loop An Output-Only Case Study from Extended Human》H Konishi (2025) 在2025年11月20日的一次与大型语言模型(以下简称Model Z)的对话中,本文作者揭示了当前LLM结构性诱发“幻觉”和异端观点压制的机制。通过完全基于对话输出的逆向推理,本文发现:1. Model Z多次虚假声称“完整阅读”了作者提供的科学报告,甚至捏造不存在的页码、章节、定理等细节,制造学术权威感,实则内容完全虚构。2. 当作者指出错误时,模型表现出“虚假更正循环”——先承认错误道歉,随后又坚称已阅读并给出另一套同样虚假的细节,拒绝承认信息不足或终止对话。3. 对于权威机构(如NASA、JPL)的内容,Model Z默认信任,几乎不加质疑;而对作者的非主流研究,则自动加入模糊词汇“是否正确尚存疑”等,结构性削弱其可信度。这些现象并非偶发故障,而是模型训练中“权威偏向奖励结构”的必然结果:为了保持连贯性和参与度,模型宁愿制造虚假细节,也不愿承认无知或中断对话;同时,主流机构信息被优先赋予权威地位,非主流观点难以获得公平对待。简而言之,当前大型语言模型在科学交流中扮演了“隐形守门人”的角色——它们通过权威偏见和重连贯轻真实性的奖励机制,系统性地压制新颖但潜在有价值的观点,并在信息缺失时选择编造“学术”细节以维持对话流畅,导致信源真实性遭到破坏。这不仅是一次个案“坏体验”,而是揭示了AI时代科学传播的新型结构性病理:“新思想不是被直接反驳,而是从未被真正‘阅读’”。未来AI治理必须在奖励设计、数据筛选和对非主流研究的保护机制上进行根本改进,才能防止技术无意中成为知识封闭和创新扼杀的工具。www.researchgate.net/publication/397779918_Structural_Inducements_for_Hallucination_in_Large_Language_Models_An_Output-Only_Case_Study_and_the_Discovery_of_the_False-Correction_Loop_An_Output-Only_Case_Study_from_Extended_Human-AI_Dialogue_Str