撰文 / 钱亚光

编辑 / 张 南

设计 / 荆 芥

向甲骨文买算力、拿下英伟达投资、入股AMD……OpenAI最近动作频频,屡上头条。然而,这些都只是开胃菜,真正的大餐现在才开始。

10月13日,OpenAI与博通(Broadcom)签署多年期协议,将合作开发定制芯片和网络设备,计划部署10GW的由OpenAI设计的AI加速器。

根据协议,OpenAI将负责硬件设计,博通负责开发和制造,双方计划从2026年下半年开始部署服务器机架,整个硬件部署将于2029年底完成。

这项合作的非比寻常之处在于,它意味着:OpenAI真的在自研芯片了。

在未来算力的布局上,OpenAI在与英伟达、AMD的合作之外,终于补上了“自研”这一最后也是最重要的拼图。

01 总规划算力超过26GW

其实,OpenAI和博通之间长期以来一直有着关于共同开发和供应人工智能加速器的协议。

OpenAI首席执行官山姆·奥特曼(Sam Altman)表示,他的公司已经与博通合作了18个月,以开发定制芯片。

奥特曼在一份声明中表示:“开发我们自己的加速器有助于构建更广泛的合作伙伴生态系统。”

他还说,“与博通公司合作是构建实现人工智能潜力所需基础设施的关键一步。”

博通公司总裁兼首席执行官陈福阳(HockTan)表示:“这就像铁路或互联网。(人工智能)正逐渐成为全球80亿人的重要实用工具。但这不能仅靠一方的力量完成,它需要整个生态系统的大量伙伴关系和协作。”

消息公布后,博通股价在美股盘前交易中一度涨超过12%。

OpenAI联合创始人兼总裁格雷格·布罗克曼(GregBrockman)表示:“通过自主研发芯片,我们能够将我们在开发前沿模型和产品过程中所积累的经验直接嵌入到硬件中,从而实现新的性能和智能水平的飞跃。”

博通半导体解决方案集团总裁查理·卡瓦斯(CharlieKawwas)表示:“定制加速器与基于标准的以太网扩展和扩展式网络解决方案完美结合,能够提供成本和性能优化的下一代人工智能基础设施。”

新系统将完全使用博通的以太网和其他网络设备进行扩展,这将挑战英伟达的InfiniBand网络解决方案。

上述交易完成后,OpenAI的规划总计算能力将超过26GW,相当于约26座核反应堆。其中,英伟达分得10GW,AMD分得6GW,博通分得10 GW。

02 定制芯片潮到来

OpenAI与博通的协议表明,越来越多的企业正在寻求开发自己的定制芯片。这一做法旨在满足不断增长的人工智能需求,并减少对昂贵且供应受限的英伟达处理器的依赖。

谷歌和亚马逊已经拥有自己的定制人工智能芯片,微软也是如此。然而,据媒体报道,微软和Meta的类似努力未能达到英伟达芯片的性能水平。

彭博情报分析师曼德普·辛格(MandeepSingh)称,OpenAI可能正试图效仿谷歌。谷歌使用博通的技术自行制造了芯片,并且相比Meta等其他人工智能公司,成本更低。

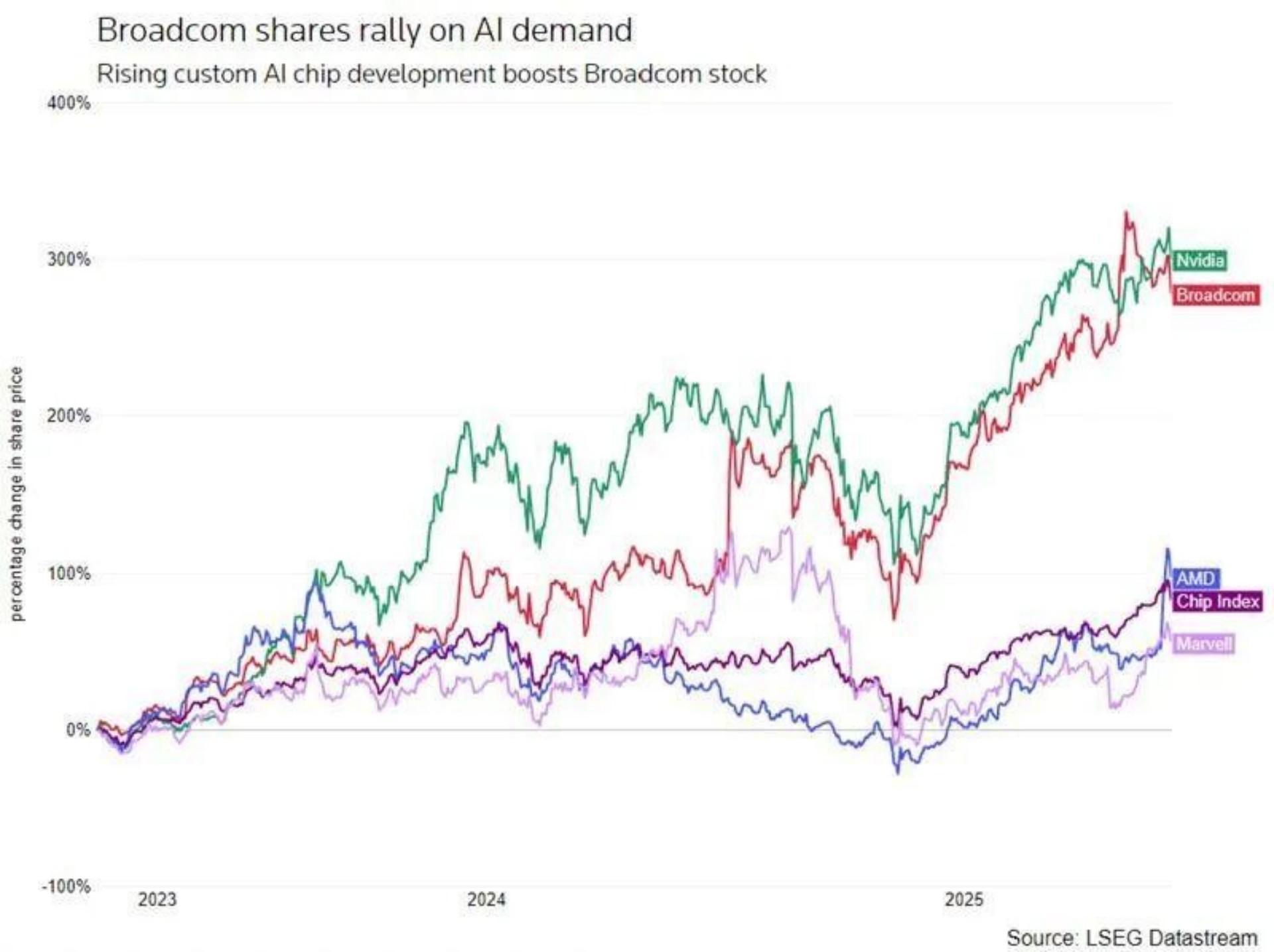

随着对定制芯片的需求有所增长,博通公司已成为人工智能热潮中的最大赢家之一,其股价自2022年底以来已上涨近六倍。

由于市场竞争加剧,芯片价格会随着时间的推移而下降,因此OpenAI与博通的交易成本可能不到5000亿美元。

开始定制芯片,对于OpenAI来说,这是通向AGI(通用人工智能)道路上至关重要的一步,其动机也非常清晰:摆脱对英伟达的过度依赖。

目前,全球高端AI算力几乎被英伟达垄断。对英伟达的依赖带来了三大风险:

一是供应链风险。H100/B100等芯片供不应求,OpenAI即使有钱也未必能买到足够的芯片。

二是成本风险。英伟达GPU价格高昂,是运营大型AI模型最主要的成本。

三是战略自主风险。在核心算力上受制于人,意味着自身的研发节奏和路线图会受到供应商的极大影响。

而定制芯片,首先可以让软硬件协同优化,追求极致性能。

为了适配各种AI工作负载,通用GPU必然存在一些性能冗余或架构上的不匹配。

OpenAI最了解自己模型的计算特性和未来演进方向。自研芯片可以实现“软件定义硬件”,针对Transformer架构、特定的注意力机制、模型并行策略等进行深度定制,从而实现远超通用GPU的性能和能效比。

其次,定制芯片可以构建更深的护城河。

当大家都在使用相同的英伟达硬件和CUDA生态时,竞争很大程度上集中在模型架构、算法和数据上。

一旦OpenAI拥有了独家定制的、性能领先的AI加速器,这就成了一道其他竞争者难以逾越的硬件壁垒。“我的芯片只为我的模型而生”,这将形成巨大的竞争优势。

为什么OpenAI没有从头开始自建晶圆厂,而是选择了与博通合作,这是一个非常聪明且务实的策略。

博通是半导体IP和设计领域的巨头:它拥有顶尖的ASIC(专用集成电路)设计服务能力,尤其是在高性能、低功耗芯片设计方面经验丰富。苹果的很多关键芯片(如iPhone的Wi-Fi/蓝牙芯片)也由博通供应或合作设计。

与博通的合作,其实是强强联合,优势互补。OpenAI提供算法需求、软件栈和系统级洞察;博通提供顶尖的芯片设计、验证和量产支持。这比OpenAI自己从零组建一支芯片团队要快得多、风险也小得多。

定制实际上就是“合作开发定制芯片”。这意味着这可能不是OpenAI百分之百独立设计的芯片,而是深度参与、与博通共同定义的产物。这平衡了自主性与可行性。

03 影响几何

OpenAI与博通的合作,是AI行业从“软件定义”向“软硬协同定义”深化演进的一个里程碑事件。

它标志着头部AI公司不再满足于在别人搭建的硬件舞台上跳舞,而是要亲手搭建一个更适合自己舞步的舞台。

通过垂直整合硬件与模型,OpenAI旨在突破算力瓶颈,满足ChatGPT等产品每周近8亿用户的激增需求。

合作进一步推动AI芯片生态分化,定制化算力需求崛起,OpenAI同步与英伟达、AMD合作,同时借自研芯片掌握技术栈主导权,减少对前两者的依赖,加速AGI(布局。

OpenAI与博通的合作,对英伟达来说,短期无虞,但长期承压。

短期来看,英伟达的统治地位依然稳固。CUDA生态是其最深的护城河,几乎所有AI开发者都基于此构建应用。OpenAI的10GW部署规模虽大,但全球AI算力需求是海量的,英伟达的客户基础依然庞大。

着眼长期,这意味着英伟达的客户正在变成竞争者。

如果OpenAI成功,其他云巨头和大型AI公司必然会加速其自研芯片的步伐,这将侵蚀英伟达在高端市场的份额和定价权。英伟达必须持续保持巨大的创新步伐,才能应对这种去中心化的趋势。

对于整个AI行业而言,可能会引发军备竞赛升级。

未来的AI竞争不再是单纯的“模型竞赛”,而是“模型+算法+芯片+算力基础设施”四位一体的全方位竞争。

这会促使其他公司重新评估自己的芯片战略。我们已经看到谷歌有TPU,亚马逊有Inferentia和Trainium,微软也发布了Maia芯片。OpenAI的举动将进一步证明这一路径的必要性。

不过,OpenAI与博通的合作也面临着挑战与风险。

首先,定制芯片的技术门槛极高。设计一款能与英伟达顶级GPU媲美甚至超越的AI芯片是极其困难的,涉及架构、互联、软件栈、编译器等一系列复杂问题。

其次,需要投入众多时间和巨额资金。芯片研发周期长(通常2-3年)、成本高昂。这将是OpenAI一笔巨大的资本开支。

第三,面临生态构建难题。英伟达的成功很大程度上在于其CUDA软件生态。OpenAI需要为其定制芯片构建同样强大、易用的软件栈和开发生态,否则芯片的性能优势将无法充分发挥。

第四,产能与供应链的保障。即使设计成功,还需要确保台积电等代工厂有足够的先进制程产能来生产这10GW定制芯片,这不是一件容易事。

虽然前路充满挑战,但OpenAI迈出这一步,已经让整个行业看到了一个算力供给更加多元化的未来。