DeepSeek V4新模型近期悄然曝光,核心亮点直指写代码能力的跨越式提升。这场升级绝非行业常见的参数堆砌噱头,而是精准瞄准开发者实际痛点的迭代,跳出“参数越高越强”的内卷怪圈,把重心放在代码落地效率与实用适配性上,成为国产大模型深耕垂直赛道的鲜明样本。

当前AI代码模型的普遍困境,早已不是“能不能生成代码”,而是“生成的代码能不能用”。多数同类模型看似能输出完整代码片段,实际落地时却漏洞百出——复杂逻辑衔接断层、不符合项目编码规范、适配本土技术栈能力不足,开发者往往要花费大量时间修改,反而加重工作负担,这也是AI写代码始终难以普及的核心症结。

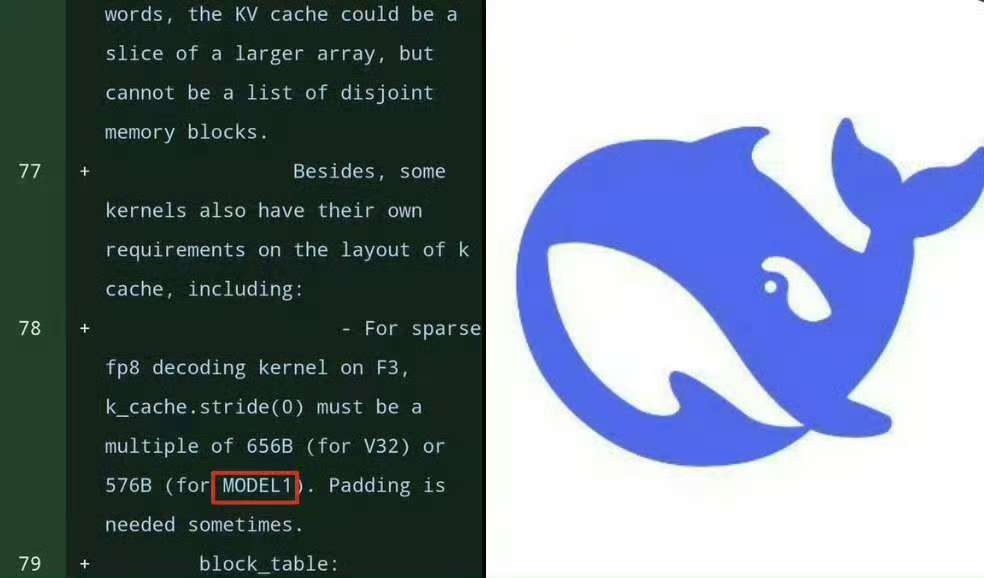

DeepSeek V4的写代码能力升级,恰恰踩中了这份痛点,其核心逻辑是“技术创新服务于实用需求”。不同于同类模型盲目追求参数规模与上下文长度,V4依托创新的条件记忆模块与mHC架构,把优化重点放在代码准确性、场景适配性与调试效率上,甚至能贴合国内开发者习惯,适配鸿蒙相关代码、阿里云SDK等本土技术场景。

所谓更强的写代码能力,从来不是“能写出更复杂的语法”,而是能真正降低开发者的工作量。V4支持1M+Token超长上下文窗口,却没有把这份优势浪费在参数炫耀上,而是用来实现“一次性加载整个中型项目代码”,无需分批分析,大幅提升代码审查、重构与跨文件调用的效率,这正是一线开发者最迫切的需求。

其技术创新始终围绕“实用”展开,混合专家(MoE)架构的运用就是最好的证明。V4搭载万亿参数,却仅激活320亿活跃参数,既兼顾了代码生成的专业性,又通过低精度训练框架降低了推理成本,让中小企业甚至个人开发者都能低成本使用,打破了高端AI代码工具的门槛壁垒。

本土化适配能力,更让V4的写代码优势形成差异化壁垒。相较于海外同类模型,DeepSeek深耕中文技术生态,能精准理解中文技术文档、国内开发者的编码习惯与命名规范,生成的代码无需额外适配就能快速融入本土项目。这种贴合度,不是简单的翻译适配,而是基于国内海量脱敏代码库训练后的深度契合。

开源特性与本地部署支持,进一步放大了这份实用价值。V4延续了DeepSeek系列的开源基因,允许本地部署,既能保障企业代码的数据隐私,又能摆脱网络依赖,离线状态下也能正常生成、调试代码。这种设计,精准击中了企业级开发对数据安全的核心诉求,区别于海外模型“云端依赖”的局限。

DeepSeek V4的曝光,更折射出AI代码模型的行业转向——从“参数内卷”走向“实用为王”。以往多数模型动辄宣传“超越某顶级模型”,却始终没能解决落地难题,而V4把所有技术升级都锚定在开发者的实际使用场景中,不玩概念、不堆参数,只用落地效果说话。这种务实的路线,或许能打破AI写代码“鸡肋”的行业偏见,推动其真正融入日常开发流程。

想要了解更多这类聚焦实用的科技视讯,请前往主页“探索”,解锁更多行业背后的深层逻辑,持续关注不迷路~

评论列表