某银行信用卡系统接入AI后:

识别速度提升:单笔交易风险检测从3秒→80毫秒人力节省:反欺诈团队从20人缩减至8人数据:

指标

人工检测

AI检测

提升率

日均处理量

8万笔

200万笔

2400%

误判率

4.70%

1.20%

-74%

2. 应对复杂场景的技术刚需某车企自动驾驶团队:

AI完成暴雨夜视测试仅需2小时(人工需3周)覆盖3000种天气组合,远超人工测试极限3. 质量保障的全面升级某电商大促期间:

AI实时拦截支付故障,避免千万损失每秒监测8万次接口调用,人工无法企及二、真正执行的时候发现:效率提升≠工作量减少困境1:从执行者到AI训练师的角色转换某医疗设备测试团队:

原有工作:每天执行300条核心用例(耗时6小时)

新增工作:

① 标注500张X光片训练数据(2小时) ② 调整病灶识别置信度阈值(1小时)③ 复核AI误判的38个异常影像(1.5小时)结果对比:

阶段

日均工时

工作类型占比

引入AI前

8小时

100%执行

引入AI后

10.5小时

40%训练/60%执行

困境2:人机协同的新增沟通成本某政务系统项目会议记录:

09:00-10:30 与算法团队确认特征提取规则10:45-12:00 向开发解释AI检测到的内存泄漏模式14:00-15:30 说服产品经理接受AI建议的测试优先级时间消耗统计:

跨部门沟通耗时从日均0.8小时→3.2小时(+300%)某金融项目因此延期11天困境3:质量责任边界模糊化

典型问题

当AI在测试环境报错但生产环境正常时:• 测试团队需要证明不是用例设计问题• 开发团队要求提供模型误判依据• 运维团队质疑测试环境配置差异某物流公司故障复盘报告显示:

28%的缺陷定责时间超过问题修复时间团队处理争议的精力超过技术攻关三、AI时代的测试工程师我们该怎么做?策略1:建立人机分工三层模型某跨国企业最佳实践:

层级

AI负责范畴

人类保留领域

执行层

百万级数据遍历

关键场景结果确认

分析层

异常模式聚类

业务风险综合判断

决策层

生成测试建议方案

最终质量放行权

策略2:掌握AI协作四件套技能测试工程师能力升级清单:

1.数据调教能力:

熟练使用LabelStudio标注工具掌握数据清洗SQL脚本编写(示例):DELETE FROM test_datasetWHERE create_time < NOW() - INTERVAL 7 DAYAND accuracy_rate < 0.8;2.模型监看能力:

能解读混淆矩阵、ROC曲线等指标某银行测试团队通过调整阈值,使误报率从15%降至4%3.人机沟通能力:

开发能理解的AI问题报告模板:

[AI检测问题] 订单状态同步异常• 置信度:92%• 特征表现:redis缓存时间戳差值>300s• 复现建议:构造10万笔并发支付请求4.边界守护能力:

制定《AI测试红线清单》:

① 涉及资金安全的场景必须人工复核② 用户隐私数据不得用于模型训练③ 新模型上线前需通过伦理审查策略3:重构测试价值评估体系某车企质量部KPI改革方案:

传统指标

新增指标

考核权重变化

用例执行数量

AI模型健康度

30%→15%

缺陷发现数量

人机协同缺陷捕获率

40%→25%

测试覆盖率

关键决策正确率

30%→60%

四、不可逆转的行业变革趋势当某通讯设备厂商测试团队完成转型后:

效率提升:5G基站测试周期从6周→9天 - 价值跃迁:

测试人员参与标准制定会议次数:3次/季→12次/月质量建议被采纳率:18%→67%团队薪资中位数:¥16K→¥28K这印证了测试行业的进化规律:

AI不会取代测试工程师,但会用AI的测试工程师正在取代不用AI的同行。

(文中数据来自公开行业报告及脱敏企业案例)

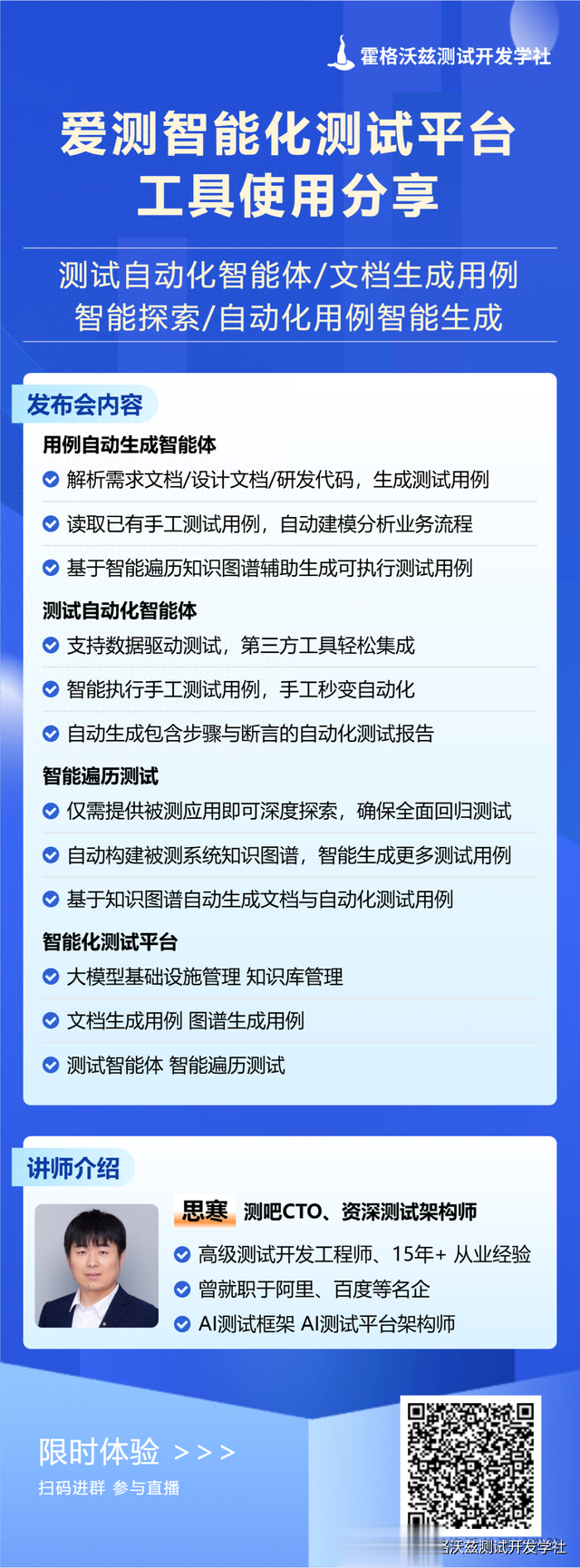

霍格沃兹专业版工具 (7天免费试用)自动遍历测试框架 AppCrawler 专业版

通用数据驱动测试框架 hogwarts-ddt 专业版

测试智能体框架 hogwarts-agent 专业版