OpenAI 新开源模型 gpt-oss-20b 训练数据和生成特征探秘

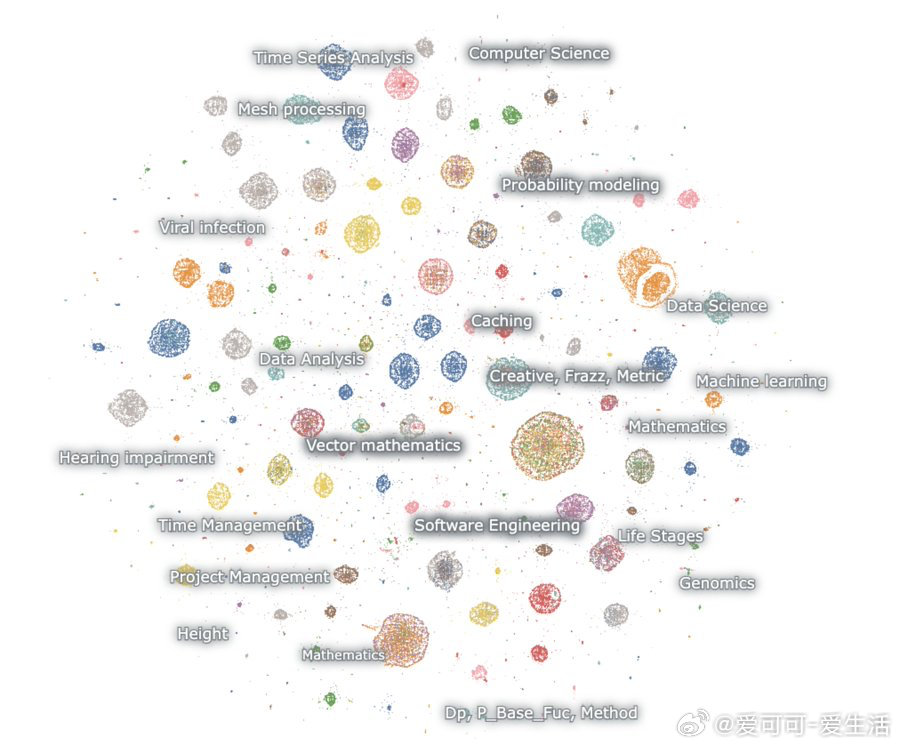

• 通过无提示生成了 1000 万条样本,分析发现模型“偏科”极为明显,几乎全是数学和编程相关内容,尤其是概率论、偏微分方程、拓扑学,以及各类编程语言(包括 Perl)和竞赛题目,且多为英文。

• 生成文本几乎不似自然网页文本,也非典型聊天对话,推测训练数据高度依赖强化学习(RL)调优,专注于解决理性推理和任务导向的 benchmark。

• 模型反复“自嗨”地生成并尝试解决一个多米诺骨牌编程难题,单次生成可超过 3 万个 token,累计生成数千次,堪称“折磨型”模型。

• 训练数据疑似包含大量 OCR 扫描书籍内容,甚至出现奇怪的人口统计细节,比如“马来西亚聋人数量”,透露了训练数据采集的复杂轨迹。

• 代码切换频繁,推测原因包括:1)RL 训练让模型不再以英语聊天为主要输出;2)数据中可能存在 OCR 或合成数据污染;3)长文本生成过程中模型输出逐渐偏离训练分布。

• 模型虽然偶尔会生成创意性内容(如挪威剧本草案),但整体表现偏向数学、代码“理科思维”。

• 分析者已将数据集上传至 Huggingface(链接:huggingface.co/datasets/jxm/gpt-oss20b-samples),欢迎社区挖掘。

• 未来方向包括:对生成文本去重(当前重复度极高,估计有效样本仅十万级);用自然语言描述不同模型输出分布差异;研究如何从大模型中直接提取训练数据。

该分析为理解开源大模型的训练语料结构、行为模式及潜在偏差提供了珍贵视角,也提醒我们强化学习导向模型可能带来的“专业化”风险与训练数据异质性问题。值得 AI 研究者和开发者重点关注。

详情🔗 x.com/jxmnop/status/1953899426075816164

开源模型 强化学习 大语言模型 训练数据解析 AI安全 模型行为分析