[CL]《Open Data Synthesis For Deep Research》Z Xia, K Luo, H Qian, Z Liu [BAAI] (2025)

InfoSeek:首个开源大规模深度研究数据合成框架,助力语言模型突破多层次层级约束满足问题(HCSP)难题。

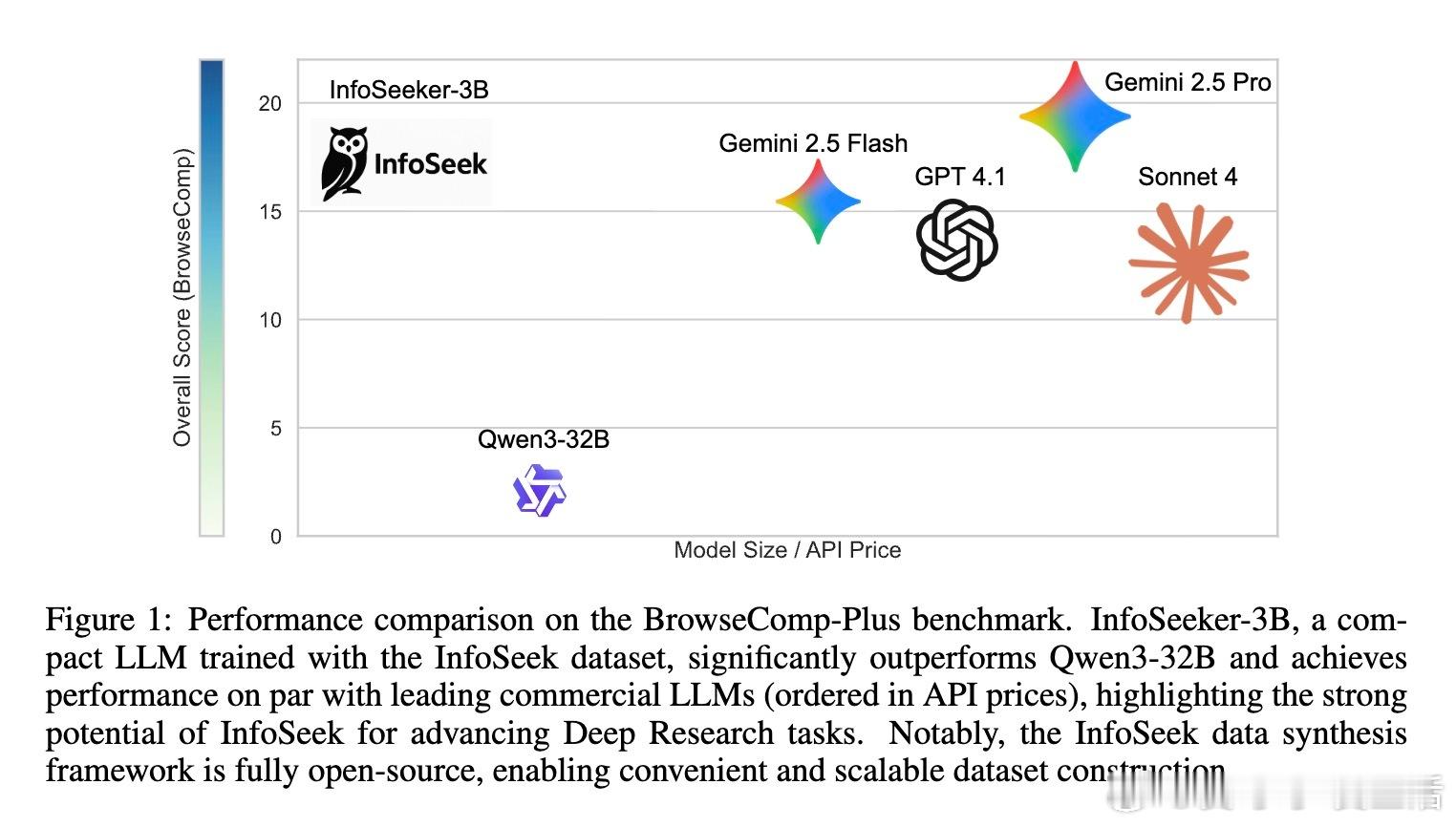

• 深度研究任务定义为HCSP,区分于传统单约束和多跳推理,需层层递进解构互依约束,答案唯一且可验证。

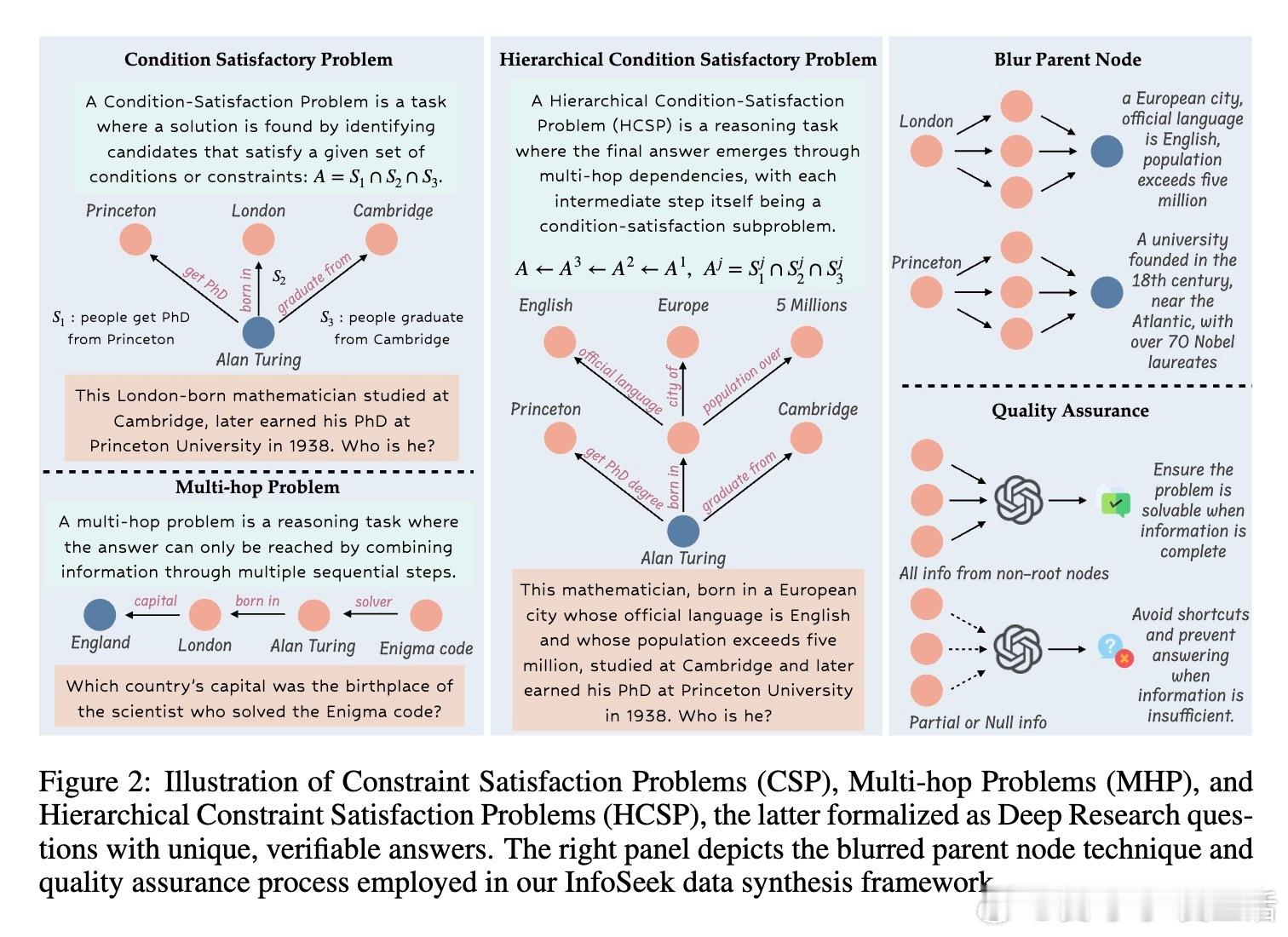

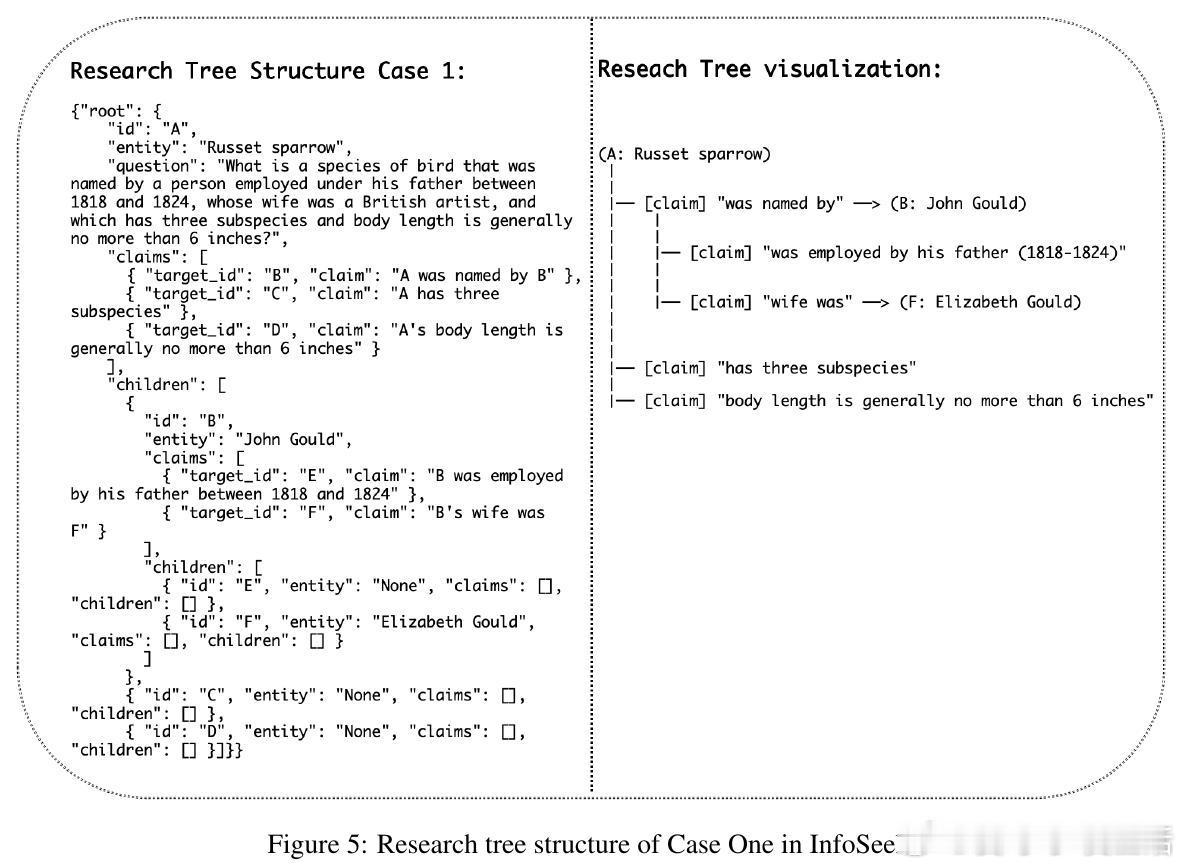

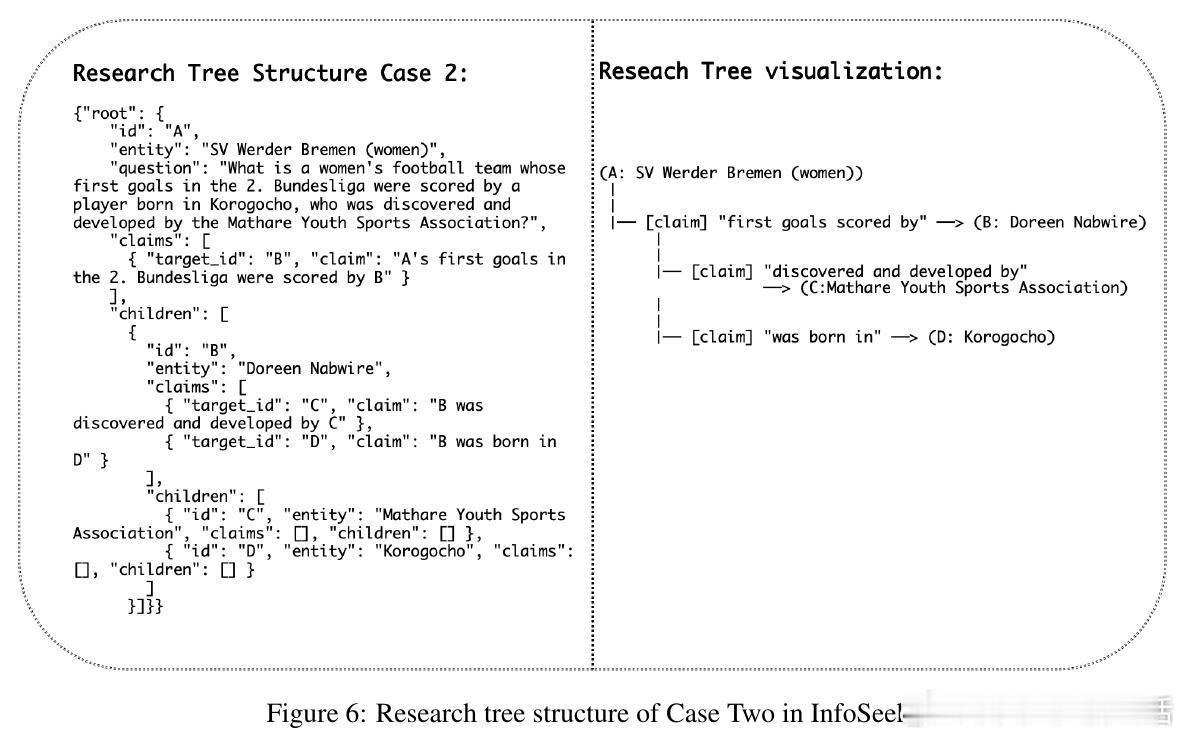

• InfoSeek采用双智能体体系,从维基百科与网页大规模爬取实体及关系,递归构建“研究树”,每节点为子问题,边表示逻辑依赖,模糊父节点以增加约束确保解唯一性。

• 通过强大LLM(如DeepSeek V3、GPT-4.1)将树结构转换为自然语言问题,保证问题需完整遍历层级推理路径,杜绝捷径和知识泄露。

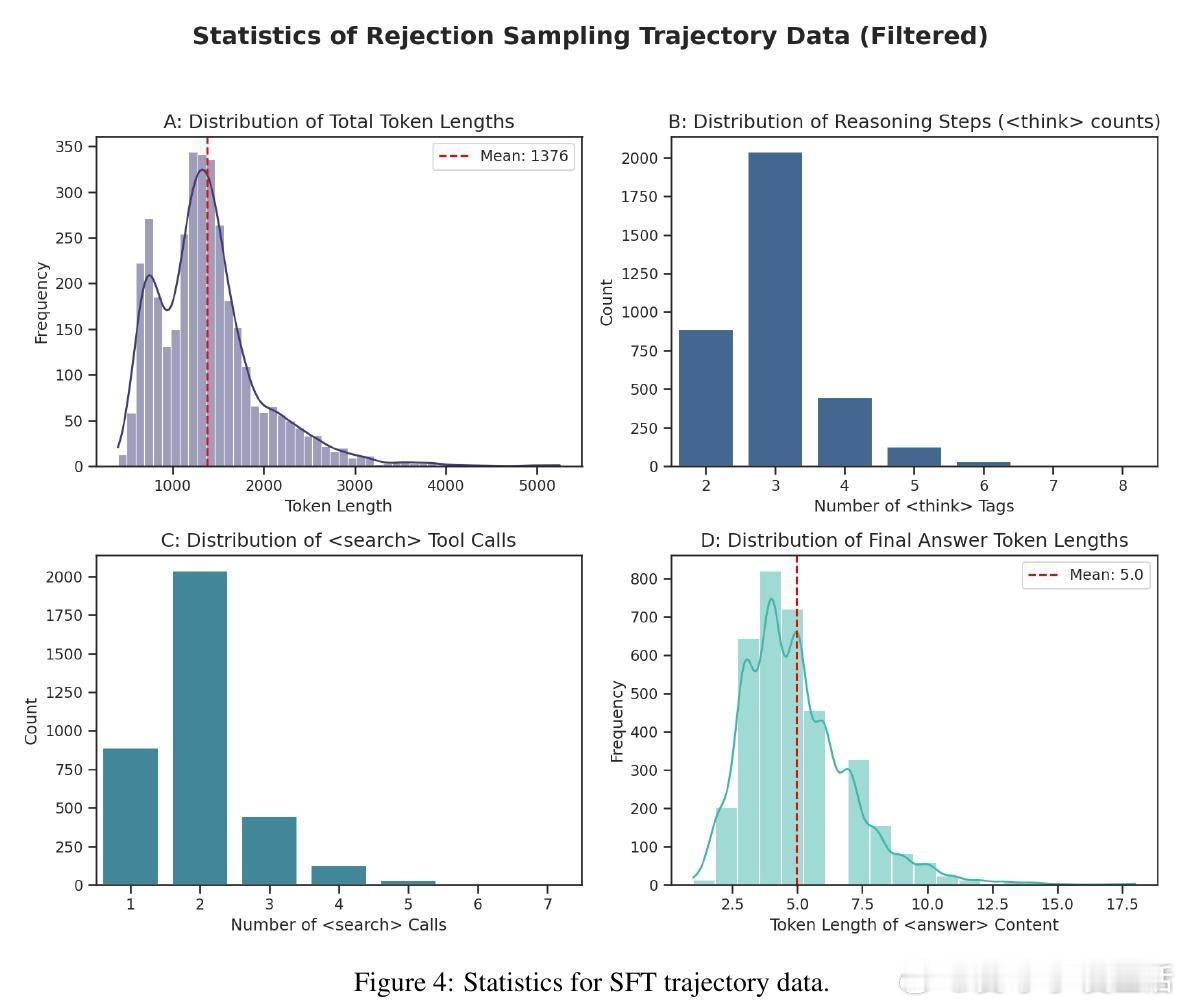

• 训练流程包含基于拒绝采样的监督微调(SFT)与强化学习(RL),利用轨迹级元信息设计复合奖励,优化搜索与推理效率。

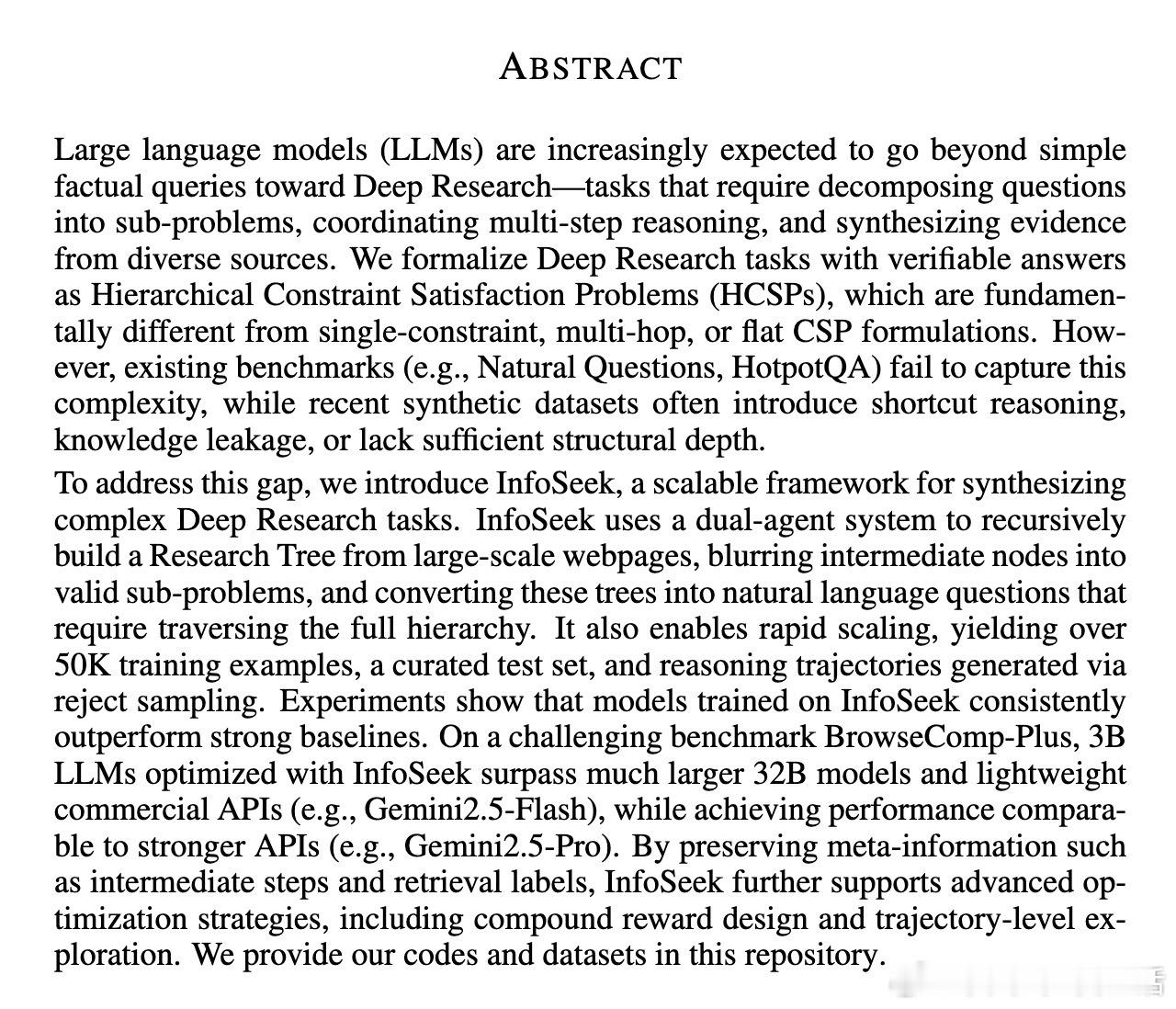

• 在BrowseComp-Plus深度研究基准上,InfoSeeker-3B模型性能超越多款大规模封闭源模型(如Gemini 2.5 Flash、Sonnet 4、GPT-4.1),展现小模型高效深度研究能力。

• 数据集规模超5万对问答,1.65万条推理轨迹,开放源码,支持社区快速扩展和研究。

心得:

1. 深度研究的核心在于层级约束的系统解析,单纯多跳推理无法覆盖真实复杂场景,必须设计结构化数据体现推理层次。

2. 模糊父节点约束和多智能体协同构建研究树,是保证问题复杂度与答案唯一性的关键,有助避免过度简化或提前收敛。

3. 多查询并行检索与专门总结代理的设计,兼顾信息覆盖与上下文紧凑性,解决多轮推理中信息冗余与噪声问题。

详情🔗arxiv.org/abs/2509.00375

深度研究层级约束满足大规模数据合成强化学习多智能体系统语言模型

![用一个词、一句话证明你在大厂待过[doge]](http://image.uczzd.cn/7970224414457359610.jpg?id=0)