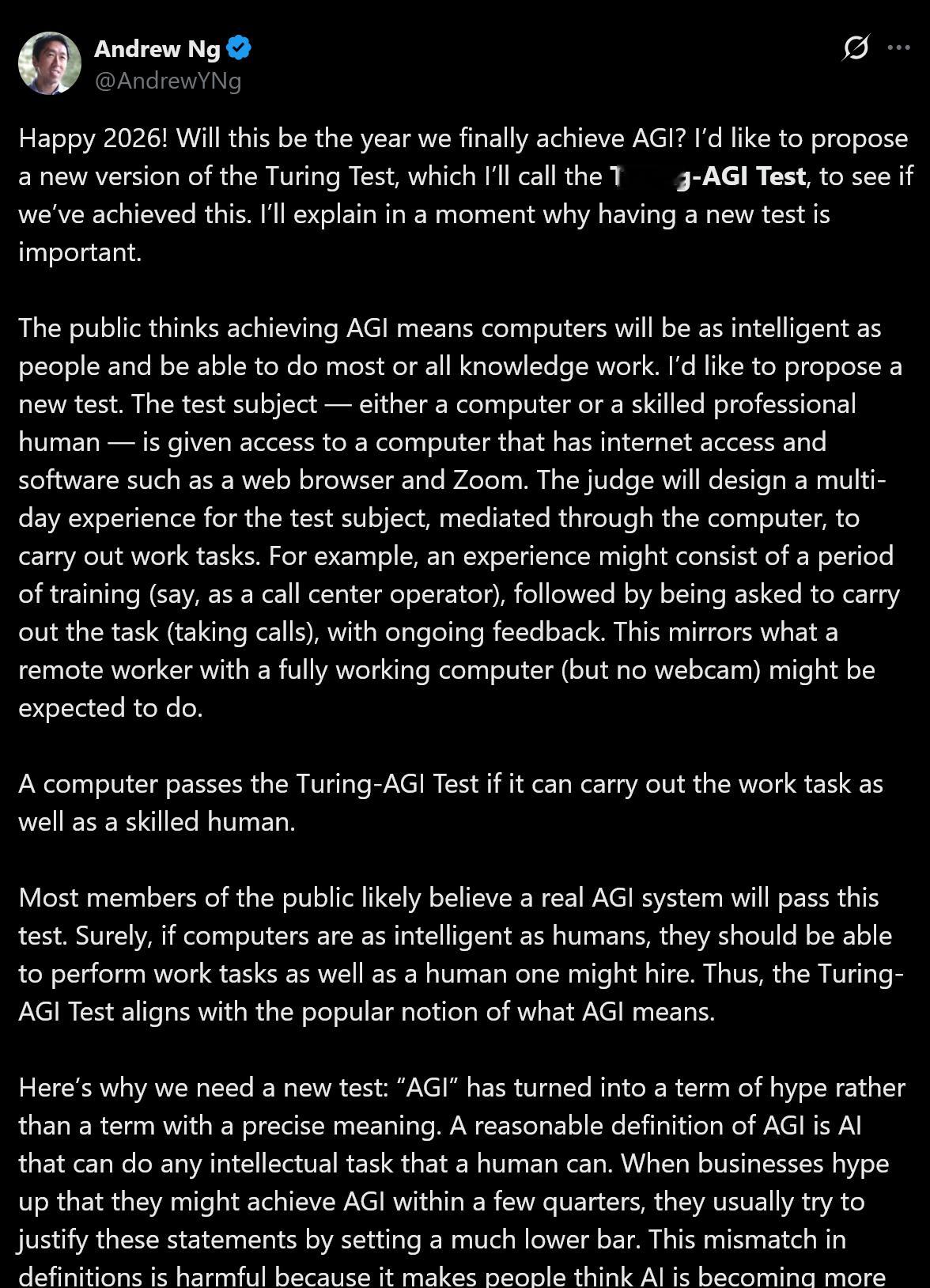

吴恩达(Andrew Ng)提议搞一个图灵测试的新版本,称为“图灵-AGI测试”--------------------亲爱的朋友们,2026年新年快乐! 今年会是我们最终实现AGI(通用人工智能)的一年吗?我想提议一个图灵测试的新版本,我将其称为“图灵-AGI测试”(Turing-AGI Test),来看看我们是否已经达成了这一目标。稍后我会解释为什么拥有一个新的测试标准如此重要。公众普遍认为,实现AGI意味着计算机将和人类一样聪明,并且能够胜任大部分甚至所有的知识型工作。我想提出的新测试是这样的:测试对象——可以是一台计算机,也可以是一位熟练的人类专业人士——将被赋予一台电脑的访问权限,这台电脑可以上网,并安装了浏览器和Zoom等软件。裁判将为测试对象设计一个为期多天的“工作体验”,并通过这台电脑作为媒介来执行工作任务。例如,这一体验可能包含一段培训期(比如作为呼叫中心接线员),随后要求其执行具体任务(接听电话),并在此过程中给予持续的反馈。这类似于一个拥有功能完备的电脑(但没有网络摄像头)的远程工作者所被期望完成的工作。如果一台计算机能够像熟练的人类一样出色地完成这些工作任务,那么它就通过了“图灵-AGI测试”。大多数公众可能都相信,一个真正的AGI系统是可以通过这项测试的。当然,如果计算机真的像人类一样聪明,它们理应能够像我们雇佣的人类员工一样出色地完成工作任务。因此,“图灵-AGI测试”与大众对AGI含义的普遍认知是相符的。这就是我们需要一个新测试的原因: “AGI”已经变成了一个炒作术语,而不再是一个具有精确含义的术语。AGI的一个合理解义是“能够完成人类所能完成的任何智力任务的AI”。当企业大肆炒作他们可能在几个季度内实现AGI时,他们通常试图通过设定一个低得多的门槛来为这些言论辩护。这种定义上的错位是有害的,因为它让人们误以为AI变得比实际上更强大。我看到这种情况误导了所有人,从高中生(他们因为认为AGI即将到来,学习某些领域毫无意义而避开这些学科)到CEO(他们在决定投资什么项目时,有时会基于“AI在1-2年后的能力将超越任何现实可能”的假设)。最初的图灵测试要求计算机通过文字聊天愚弄人类裁判,使其无法分辨自己是机器还是人,但这已不足以表明人类水平的智能。勒布纳奖(Loebner Prize)竞赛实际上运行了图灵测试,并发现要愚弄裁判,模拟人类的打字错误——甚至比真正展示智能——更为必要。当今AI发展的一个主要目标是构建能够从事具有经济价值的工作的系统,而不是愚弄裁判。因此,一个经过修改的、衡量“做工能力”的测试,将比衡量“愚弄人类能力”的测试更有用。对于今天几乎所有的AI基准测试(如GPQA、AIME、SWE-bench等),测试集都是预先确定的。这意味着AI团队最终至少会间接地针对已发布的测试集来优化他们的模型。此外,任何固定的测试集只能衡量智能的一个狭窄切片。相比之下,在图灵测试中,裁判可以随心所欲地提出任何问题来探测模型。这让裁判能够测试计算机或人类的知识到底有多“通用”。同样,在“图灵-AGI测试”中,裁判可以设计任何体验——这些体验对于被测试的AI(或人类受试者)来说是不预先透露的。这比预定的测试集能更好地衡量AI的通用性。AI正处于惊人的进步轨道上。在过去的几十年里,过度的期望曾导致了“AI寒冬”,当时对AI能力的失望导致了关注度和资金的减少,直到领域取得更多进展后才有所回升。阻碍AI巨大动力的少数因素之一,就是不切实际的炒作所制造的投资泡沫,这带来了失望和兴趣崩盘的风险。为了避免这种情况,我们需要重新校准社会对AI的期望。一个测试将对此有所帮助。如果我们举办一场“图灵-AGI测试”竞赛,而每个AI系统都未达标,那将是一件好事! 通过平息围绕AGI的炒作并降低泡沫的风险,我们将为AI的持续投资创造一条更可靠的路径。这将让我们继续推动真正的技术进步并构建有价值的应用——即使是那些远未达到AGI水平的应用。而如果这个测试设定了一个明确的目标,让团队可以以此为方向来摘取实现AGI的殊荣,那也同样美妙。我们可以确信,如果一家公司通过了这个测试,他们创造的将不仅仅是一份营销通稿——那将是某种极具价值的东西。新年快乐,祝大家在新的一年里构建愉快!Andrew科技先锋官