人工智能(AI)的迅猛发展和广泛应用已经在许多领域带来了巨大的影响,包括教育、就业、金融和法律等。然而,随着人工智能算法在决策过程中的应用,隐性偏见问题逐渐浮现。这些偏见可能导致不公平的决策和对特定群体的不利影响,引发了公平性问题的关注和讨论。本文将深入探讨人工智能与隐性偏见的关系,分析导致偏见的原因,并提出解决算法公平性问题的策略。

偏见的产生和原因: 人工智能算法中的偏见主要源于以下几个方面:

a. 数据偏见:算法的训练数据往往反映了现实世界中的不平等和偏见。历史数据中存在的种族、性别和年龄等偏见会被算法学习和传递,导致决策过程中的不公平。

b. 特征选择偏见:在决策过程中,算法可能会过度关注某些特征,忽视其他重要的特征。这可能导致对某些群体的歧视性决策,例如基于种族或性别的偏见。

c. 模型选择偏见:在构建模型时,选择的模型和算法本身可能存在偏见。例如,某些算法在处理不平衡的数据集时可能产生偏见,导致对少数群体的不公平决策。

公平性问题的影响: 算法的隐性偏见可能对个体和社会产生广泛的影响:

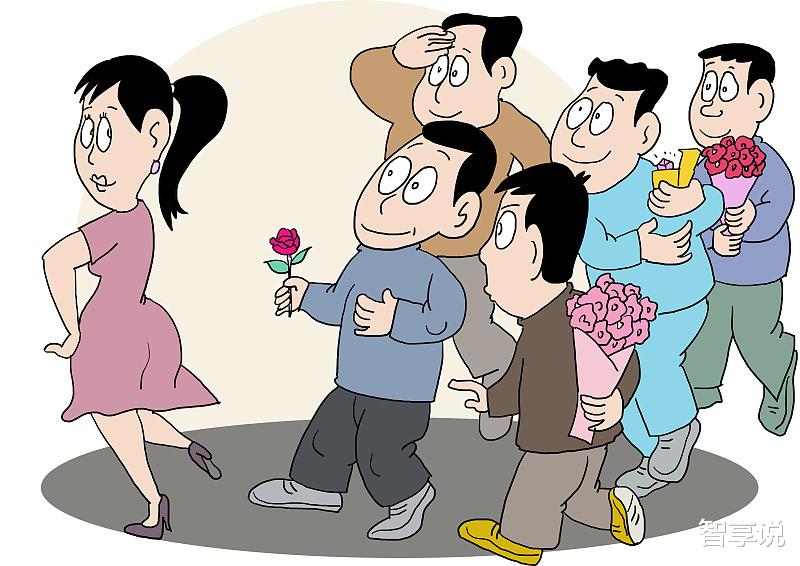

a. 就业歧视:招聘和招生算法可能会因为性别、种族和年龄等因素而产生偏见,导致对某些群体的不公平待遇和机会限制。

b. 贷款和金融歧视:基于算法决策的贷款和信用评估可能对特定群体进行不公平的歧视,限制他们获得金融服务和机会。

c. 犯罪预测和司法系统:算法在犯罪预测和司法决策中的应用可能存在偏见,导致对某些群体的不公平定罪和判决。

解决算法公平性问题的策略:

a. 数据采集和准备阶段:

多样性的数据集:构建多样性的数据集,包括不同群体的样本,以减少偏见的传递。确保数据集的代表性和平衡性,反映社会的多样性。

隐私和安全保护:保护用户隐私,避免滥用个人敏感信息,并确保数据的安全性。

b. 算法开发和训练阶段:

透明度和可解释性:确保算法的决策过程具有可解释性,使用户和相关利益相关者能够理解决策的基础和依据。

偏见检测和修正:对算法进行审查和测试,检测和纠正潜在的偏见和不公平。引入公平性指标和偏见校正方法来提高决策的公平性。

c. 监督和治理阶段:

审查和监控:建立独立的机构或专家团队对算法进行审查和监控,确保算法的公平性和合规性。

法律和政策规定:制定法律和政策规定,明确算法决策的责任和义务,保护个人权益和公平原则。

d. 参与和教育:

多方参与:鼓励利益相关者、专家和用户的参与,促进决策过程的多样性和代表性,减少偏见和不平等。

教育和意识提高:提高公众对算法和公平性问题的理解和意识,加强对算法决策的监督和要求。

持续挑战和未来展望: 解决算法公平性问题是一个复杂而持续的挑战。随着技术的进步和社会意识的提高,应该继续加强监管和法律规定,推动技术和公平性的发展。同时,我们也需要加强教育和培训,培养专业人才和社会意识,以更好地应对算法公平性问题。

人工智能与隐性偏见的关系引发了对算法公平性问题的关注。算法的隐性偏见可能导致不公平的决策和对特定群体的不利影响。解决算法公平性问题需要在数据采集和准备、算法开发和训练、监督和治理以及参与和教育等方面采取策略。通过建立多样性的数据集、确保透明度和可解释性、审查和监控算法的运行,并鼓励多方参与和加强教育意识,我们可以逐步解决算法公平性问题,构建更加公正和公平的人工智能应用。然而,解决算法公平性问题是一个长期而复杂的过程,需要各方共同努力,持续不断地改进和创新。