导语|算力之外,基础设施正成为新的关键变量

近年来,围绕大模型建设的讨论,大多集中在 GPU 数量、算力规模与训练参数上。但如果把视角下沉,会发现真正决定一座智算中心上限的,并不是那一块卡,而是机架、供电体系和功率电子这些基础设施环节。

同样是 1 万张加速卡,不同机柜功率密度、供配电架构和电源系统,会带来截然不同的能效、成本和扩容能力。这一层,正在成为算力基础设施的核心竞争点。

本文以三类企业为切口——机电基础设施、整体供电方案、功率电子与 UPS 系统——尝试从“机架 → 供电 → 功率电子”的系统协同角度,分析算力大规模部署背后的关键逻辑。

一、现象:从“上多少卡”到“每机架能承受多少功率”传统 IT 场景中,一个机架的典型功率密度约 5–10 kW。但在 AI 大模型时代,加速卡功耗提升明显,形成集中部署后,机架功率密度向 30–60 kW 甚至更高迈进。

这带来一系列变化:

供电端:原有配电容量不再使用,UPS 模块需要重新规划;散热端:气流组织优化难度加大,液冷或混合架构成为重要选项;功率电子端:高负载持续运行对电源模块和功率器件稳定性提出更高要求;运维端:机架负载波动更快,对监控和调度提出新要求。换句话说,行业关注点正从“如何扩算力”转向“如何承载算力”。

二、样本分析:机架—供电—功率电子的基础设施全景

二、样本分析:机架—供电—功率电子的基础设施全景以下表格对三类典型企业进行拆解,包括:定位、代表产品、核心技术、指标、布局方向与风险点。

表 1|基础设施企业拆解:定位、技术与风险点(可作为正文主表,也可独立制作成多图形式用于头条正文滑块图)

维度

企业样本 A(整体供电方案)

企业样本 B(机架与模块化系统)

企业样本 C(UPS 与功率电子)

角色定位

供电系统、模块化电源、智能能效管理

机架结构、配电架构、制冷系统集成

UPS、电源模块、机房供电底座

代表产品/方案

模块化 UPS、智能配电系统、微模块单元

模块化机房、预制式数据中心、热通道封闭与液冷接口

高频在线 UPS、一体化机房供电系统

核心技术侧重点

大功率密度模块电源、能效管理、弹性扩容

高密度机架设计、多制冷协同结构、快速交付

高效率电源转换、负载波动响应控制

典型指标

30 kW/机架以上适配能力、智能监控降低 PUE

单 Pod 支持 MW 级功率、多架构制冷方式

中大型机房 UPS 容量段、稳定性与冗余优化

近年布局方向

向算力场景拓展:高密机架供电、液冷配电、智能运维

聚焦高密场景建设周期缩短、模块化与预制化

围绕高负载数据中心提升效率与可靠性

场景适配

大规模算力中心、云计算机房、训练/推理集群

高密部署场景、扩容频繁的机房项目

区域节点、中小型数据中心、边缘场景

风险点/观察点

项目周期长,集成要求高,生态协同复杂

高密度制冷架构长期可靠性验证

在更高密场景中对产品迭代节奏提出挑战

三、样本一:整体供电方案的底层逻辑在高密度算力中心中,供电系统从“机房配套”变成了“算力基础设施的一部分”。

值得注意的趋势包括:

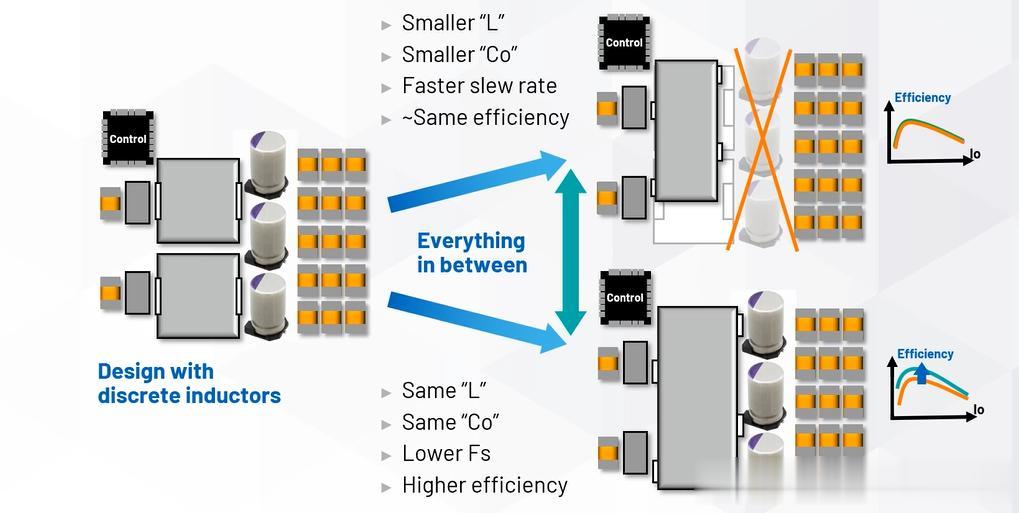

1. 功率密度的抬升当机架从 10 kW 走到 30 kW 以上,供电系统的稳定性、扩容能力和转换效率都会成为约束条件。电源模块设计要兼顾:

高频、高效、低损耗;在高温环境中的稳定性;与智能监控系统的协同能力。2. 能效成为长期指标以往数据中心建设更关注“建成”,但如今更关注:

全链路能效;功率路径损耗;不同时段负载与供电系统的动态匹配。3. 模块化成为主流高密度场景需要:

快速交付;灵活扩容;标准化+兼容性。从观察角度看,这类企业体现的趋势是:

供电不再只是保障,而是算力工程的一环。

四、样本二:机架与模块化系统的结构性挑战在高密智算中心中,机架与机房架构是构成系统上限的“物理边界”。

三个核心点特别关键:

1. 温控结构与气流管理当机架功率密度上升,传统气流模式不再适用。冷热通道封闭、液冷接口、后门换热器等结构,决定能效与稳定性。

2. 工期与标准化算力部署速度越来越快,模块化、预制式方案显著缩短建设周期。但也提出了新的问题:

标准与定制的平衡;与供电、液冷等系统间的接口匹配;扩容时的结构兼容性。3. 设备代际兼容AI 服务器代际更新快,不同代的热设计功耗差异明显。机架结构设计是否能兼容不同代际的设备,成为长期价值指标。

总结一句话:

机架系统越早考虑未来可能性,算力扩容越从容。

五、样本三:功率电子与 UPS——看似“底层”,却影响运行上限功率电子环节看似不起眼,但是真正决定算力稳定性的底座。

1. 负载波动下的稳定性大模型推理/训练场景负载会产生短时峰值,对 UPS 的控制算法和器件能力提出要求。

2. 全生命周期成本中小规模算力节点更关注:

电源效率;运维成本;模块维护便利性;扩容节奏。3. 边缘节点的增长算力从集中式向多层次结构扩展后,边缘机房、区域节点数量增加。稳定、易维护的电源系统反而更重要。

思考点在于:

高性能集群依赖算力,高可用集群依赖电源稳定性。

六、系统协同:决定上限的不是单一设备,而是耦合关系把机架、供电、功率电子这三个环节放在一条线上,会看到一个更深层的结构性逻辑:

机架功率密度提升 → 推动供电架构与模块升级;供电架构升级 → 推动功率电子对高负载环境适应能力提升;散热体系的变化 → 反向约束机架布局和电力系统设计。因此,算力基础设施实际是一个热—电—算力三者耦合的系统工程。真正的挑战并非某个单点,而是全链路之间的匹配与协同。

结语提问|周末思考当我们把注意力从 GPU 与算力规模,转移到机架、供电、功率电子,会发现算力基础设施并非“配套工程”,而是整个系统的隐性核心。

你怎么看:未来几年,算力基础设施的关键变量,会更多来自电力与能效体系,还是来自机架结构与热设计架构?又或者,真正决定上限的,是三者之间的协同能力?

关注我【硬科技趋势观察官】,每周深度拆解 AI 芯片、光组件与算力系统的最新趋势,用数据看产业。

#AI芯片 #算力 #智算中心 #功率电子 #数据中心 #硬科技趋势