前提条件:请确保你本地已经安装了ollama以及有关本地离线模型。或者已有远程模型环境等。如果没有,请自行部署。如果需要帮助,可以文末获取联系方式咨询。由于部署离线大模型过于简单,在线资料也很多,我就省略这个步骤了。

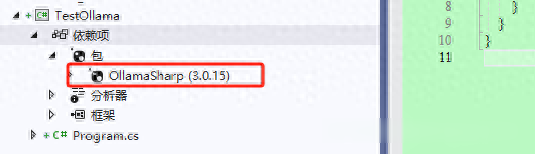

创建一个项目,添加使用MIT开源协议的一个nuget包 OllamaSharp

确保Ollama应用已经启动。

默认本地ollama的端口是11434,也可以自行部署时候更改环境变量进行修改大模型存放地址、默认端口、是否允许远程访问等等。创建连接,并且验证下连接是不是正常,返回true,代表连接正常。

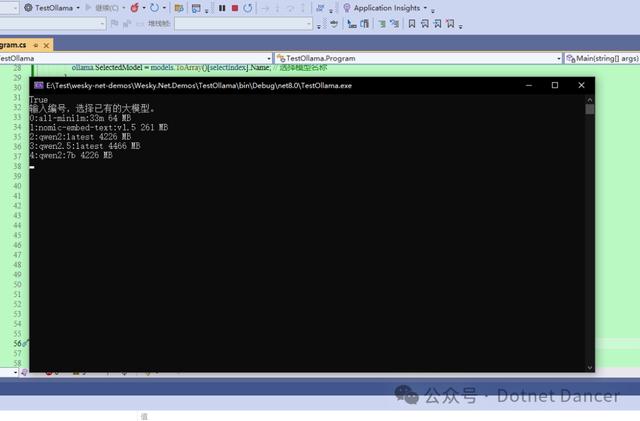

可以遍历出已有的模型有哪些,咱们写个选择模型的输入,通过输入来选择模型。由于获取的是IEnumerable集合,所以此处为了方便,之间转为数组来获取下标,从而获取模型名称。大家自己使用时候记得优化下写法。

运行,可以看到我本地罗列的模型列表等信息。

选择模型完毕,并绑定prompt提示词进行创建聊天对话。创建对话以后,根据用户输入的内容进行推理并获取返回内容。

运行结果如下:

动态图如果显示不全,也可以看另一个地方的动态图片演示:

https://www.cnblogs.com/weskynet/p/18497936

如果需要以上演示的demo源码,可以在个人公众号内,回复 代码演示 即可获取代码开源地址。

或者直接获取以下源码自行调试:

var uri = new Uri("http://localhost:11434");var ollama = new OllamaApiClient(uri);var connect = await ollama.IsRunning();Console.WriteLine(connect);var models = await ollama.ListLocalModels();if (models.Any()){ int index = 0; Console.WriteLine("输入编号,选择已有的大模型。"); foreach (var model in models) { Console.WriteLine($"{index++}:{model.Name} {model.Size / 1024 / 1024} MB"); // 输出模型名称和大小 } int selectIndex = Convert.ToInt32(Console.ReadLine()); ollama.SelectedModel = models.ToArray()[selectIndex].Name; // 选择模型名称}else{ Console.WriteLine("没有大模型环境,请自行下载大模型"); return;}Console.WriteLine("请输入你的prompt提示词:");var prompt = Console.ReadLine();Console.WriteLine("你现在已经启动,并且可以输入内容进行对话:");var keepChatting = true;var chat = new Chat(ollama, prompt);string message;while (keepChatting) { Console.Write(">:"); message = Console.ReadLine(); if (string.IsOrEmpty(message.Trim())) { continue; } if (message.Equals("/q", StringComparison.OrdinalIgnoreCase)) { keepChatting = false; break; } await foreach (var answerToken in chat.Send(message)) Console.Write(answerToken); Console.WriteLine();