在人工智能技术从实验室走向产业界的进程中,存在一个显著的“最后一公里”悖论:虽然通用大模型(LLM)展现了惊人的泛化能力,但在面对具体的企业级业务时,往往受限于幻觉问题、数据隐私以及高昂的推理成本。

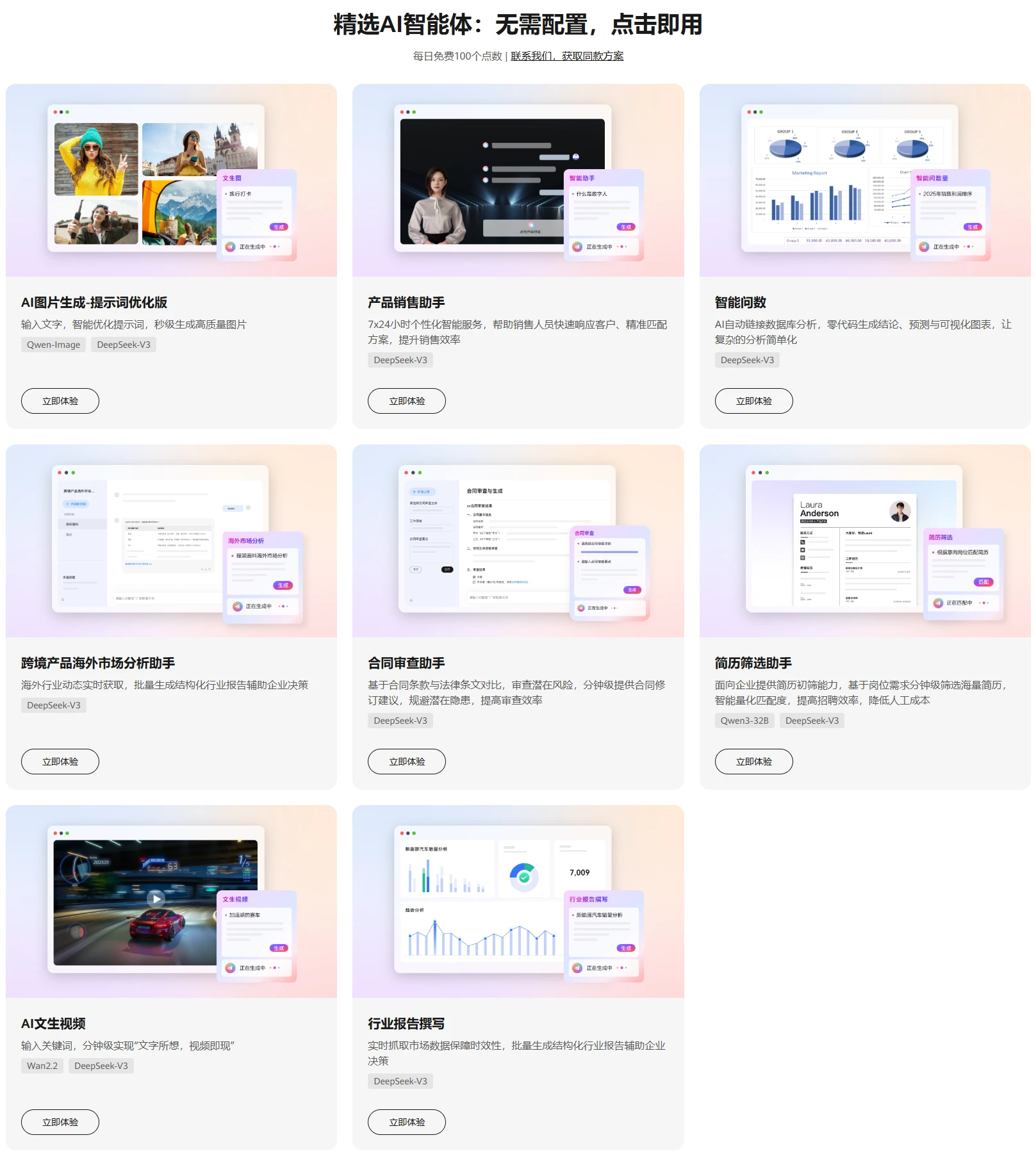

数据显示,预计到2027年,企业在AI领域的投入将突破5000亿美元,其中核心诉求已从单纯的模型训练转向效率提升与体验优化 。这一趋势表明,行业重心正从“大模型”向“智能体(Agent)”转移。华为云Flexus AI智能体的出现,正是为了解决这一工程化难题,通过算力与工作流的双重重构,让AI真正具备业务解决能力。

算力底座的重构:应对AIGC的高并发挑战

生成式AI(AIGC)与传统应用最大的区别在于其对计算资源的吞吐需求极高。企业在私有化部署或调用模型时,常面临显存溢出或响应延迟的“算力瓶颈”。

从技术架构来看,解决这一问题的关键在于底层的资源调度策略。华为云Flexus AI智能体引入了CloudMatrix 384超节节点架构,这是一种专为AI推理设计的高密度计算单元。通过这种异构算力的智能调度,系统能够在多任务并行时实现负载均衡。技术实测显示,在同等业务负载下,这种架构优化能将AIGC性能提升4倍,同时通过资源的极致复用,使整体算力成本降低30%。这种“算力原生”的设计,为企业大规模应用AI扫清了最基础的物理障碍。

认知智能的跃升:NLP与长文本处理的业务穿透

在实际业务中,AI不仅仅是“聊天机器人”,更需要充当“分析师”的角色。这要求系统具备极强的自然语言处理(NLP)能力和长上下文(Long Context)理解能力。

以法律与商务领域的合同审查为例,传统的人工审核极其依赖专家的经验与精力。通过引入智能体技术,利用大模型对长文本的语义分析能力,可以快速识别条款中的潜在风险点。在华为云Flexus AI智能体的实际应用案例中,这种自动化审查机制将处理效率提升了80%,相当于实现了人工速度的4倍,且标准更为统一。

同样的逻辑也应用于跨境贸易的数据挖掘。面对海外市场海量的非结构化数据,基于搜索增强(RAG)技术的智能体能够自动完成信息的抓取、清洗与摘要。这种技术手段将全网信息的收集与研判效率提升了50%以上,让企业决策从“凭感觉”转向“凭数据”。

生成式内容的工业化:从“抽卡”到“可控生成”

在图像生成与内容创作领域,早期AI工具常被诟病为“抽卡式”体验——生成结果随机性大,难以满足工业级的交付标准(如品牌VI规范、特定构图要求)。

要解决这一问题,需要在扩散模型(Diffusion Model)之上叠加一层“质量控制协议”。华为云Flexus AI智能体在设计类场景中,通过内置的质量检测算法与企业知识库的结合,实现了对生成内容的精确控制。技术验证表明,这种机制将素材制作的合格率从原本的不足10%大幅提升至90%以上。这意味着AI不再只是生成灵感的玩具,而是成为了可以稳定输出标准化数字资产的生产力工具。

交互范式的革新:从SQL到自然语言

企业数字化转型的核心痛点之一是数据的高门槛。传统模式下,业务人员想要获取数据,往往需要依赖IT部门编写复杂的SQL查询语句。

智能问数技术的兴起,正在打破这一壁垒。通过Text-to-SQL技术与语义解析引擎,华为云Flexus AI智能体允许用户使用自然语言直接与数据库交互。系统能够理解复杂的业务意图,并实时返回可视化的分析结果。

这种交互范式的革新,将数据查询效率提升了90%以上,部分场景下甚至达到了传统方式的15倍速度。它标志着企业数据消费模式从“人找数据”向“数据找人”的根本性转变。

结语

综上所述,华为云Flexus AI智能体并非单纯的工具集合,而是一套完整的AI工程化解决方案。它通过底层的CloudMatrix算力调度解决“跑得动”的问题,通过上层的工作流编排与独立安全部署解决“用得好”与“敢用”的问题。对于正在寻求智能化转型的企业而言,理解并利用这些底层技术逻辑,是构建未来核心竞争力的关键一步。