【技术向】为什么同一个团队做出来的不同车型辅助驾驶表现会有差异?

这个问题其实与另一个问题非常相似,某个团队做完了一版软件,是不是可以直接迁移到另一个车型上?

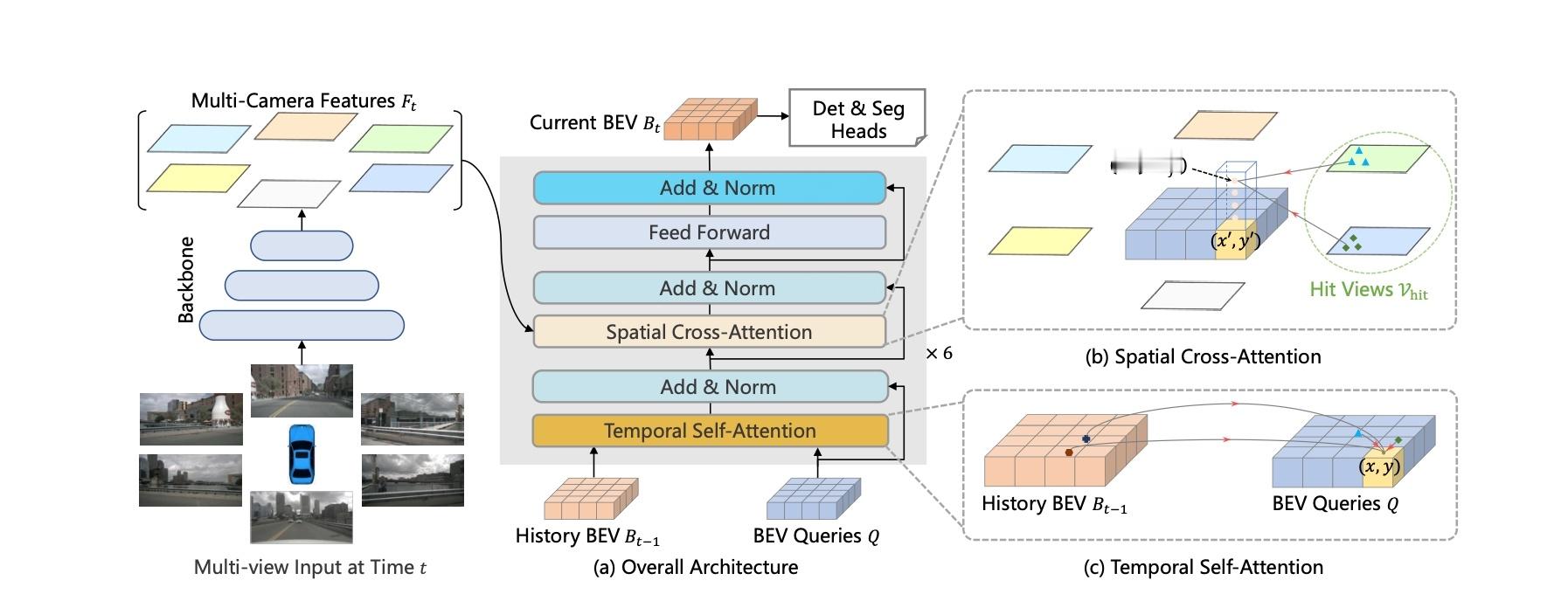

先说答案: 完全不行,尤其是目前BEV+Transformer 方案下。

对于某个平台的车型,我们会很明显看到,即使价格差异非常大,舒适性配置和底盘配置差异都很大的情况下, 整体传感器硬件却不会有什么变化。

一般是7 Camera + Lidar + 智驾芯片。

为什么,因为实际上,感知软件对于这些硬件是非常敏感的,就连图像处理模块ISP 发生变化,感知的结果也很难保证。

在基础硬件配置基本一致的情况下,智驾软件可以直接迁移吗?

也不行,这就要回到目前智能驾驶感知算法的架构上来了。

BEV 实际上也就是鸟瞰图视角,但是我们摄像头并不是鸟瞰视角的,而是相机朝向,那这种转换关系是怎么完成的?

摄像头的内外参,简单理解的话就是摄像头的安装位置和投影关系。

这是将特征投影到BEV 空间的基础。

但是每辆车的造型不一致,轿车与SUV 的传感器安装位置是完全不同的。

A车型的数据很难用于B车型的算法训练,因为安装位置是不一致的,对安装位置非常敏感的BEV算法很难互用。

一般来说,一个BEV 算法启动到基本跑通,可能需要百万帧级别的数据。

而交付完一辆车之后,一辆新车,同样的模型性能会退可能非常大,外参变化越大,会退会更加明显。

即使是一个已经跑通的方案,对于每一种车型数采的成本都难以忽略,而感知相关的Corner Case 也可能需要单独数采解决。

因此,多车型让团队开始横向拓展项目,会一定程度上拖慢纵向研发进度。

这是这一代智能驾驶方案的天然劣势。

而对于车型量较少的团队,会有更多精力在同一个方案上进行优化。

所以不得不承认,在这个角度特斯拉和理想有天然优势。

当然目前也有一些外参不敏感的BEV 方案学术界尝试,但是也没有看到非常有前景的方案。

最后对于一些销量较差的车型,车企是否有精力持续进行算法的优化,也要打一个巨大的问号。