Why Attention Is All You Need?

www.k-a.in/llm5.html

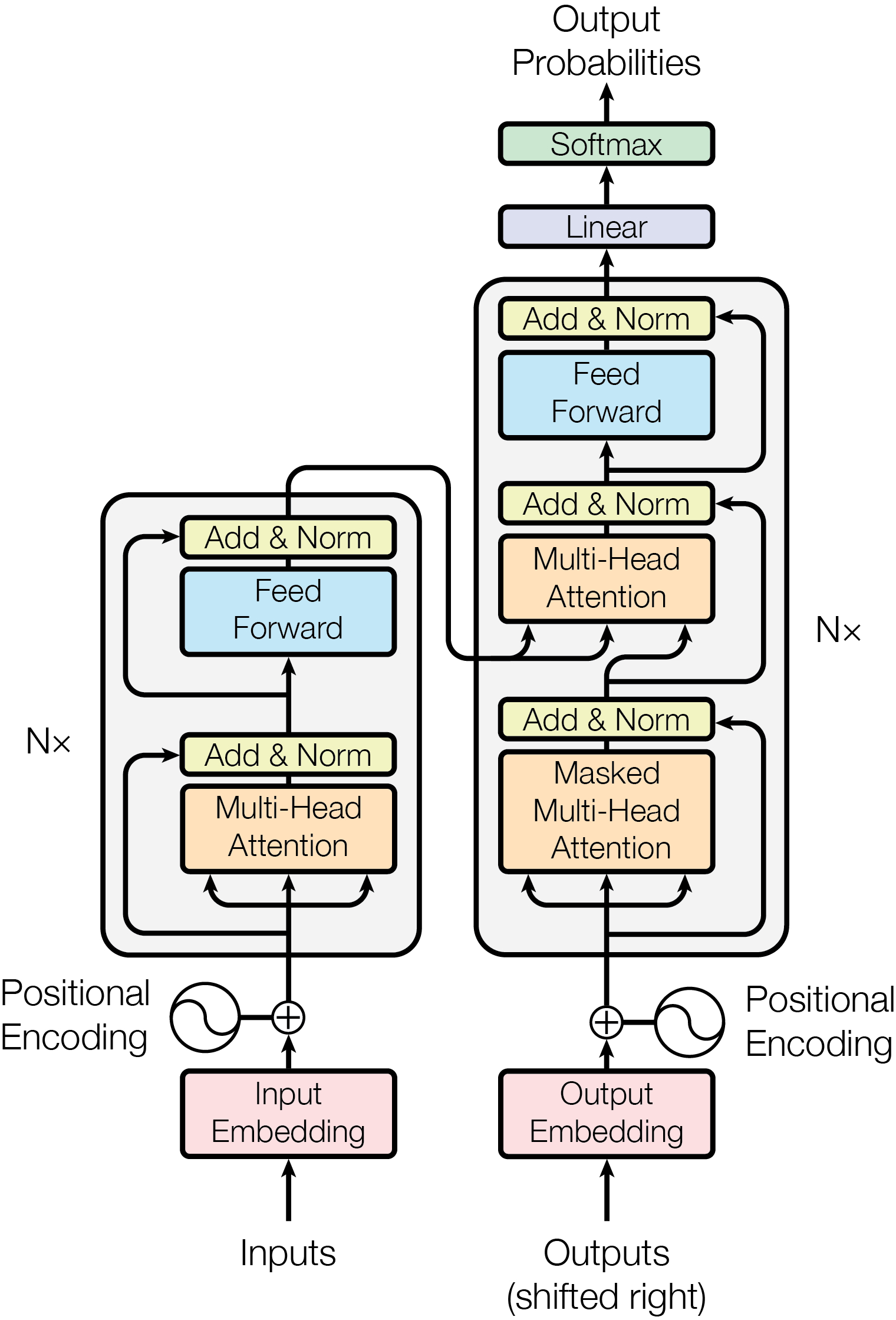

本文是对谷歌2017年发布的开创性论文《Attention is All You Need》的通俗介绍(英文文章)。文章详细解释了Transformer架构如何通过自注意力机制取代传统的循环神经网络(RNN)和卷积神经网络(CNN),从而解决序列转换任务中的长距离依赖问题,并实现并行化计算。文章回顾了传统的基于RNN的序列到序列模型的局限性,介绍了注意力机制的原理及其在Transformer架构中的应用,包括多头注意力、位置编码等关键创新。最后,文章总结了Transformer架构的优势,如缩短信息路径、支持并行化训练、更好的梯度流动等,并探讨了其对自然语言处理领域的深远影响,以及如何为现代语言模型奠定基础。

AI生活指南AI创造营