一篇面向初学者的注意力机制介绍文章

mrinalxdev.github.io/mrinalxblogs/blogs/attention.html

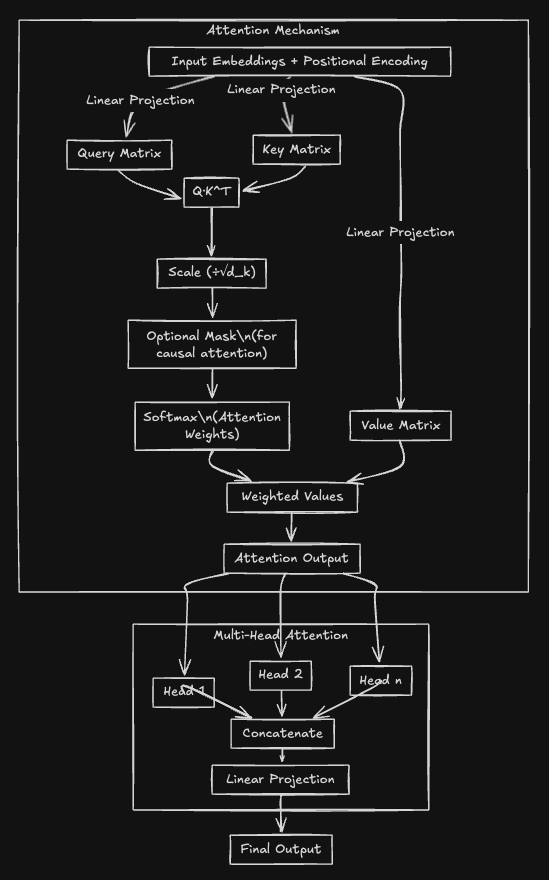

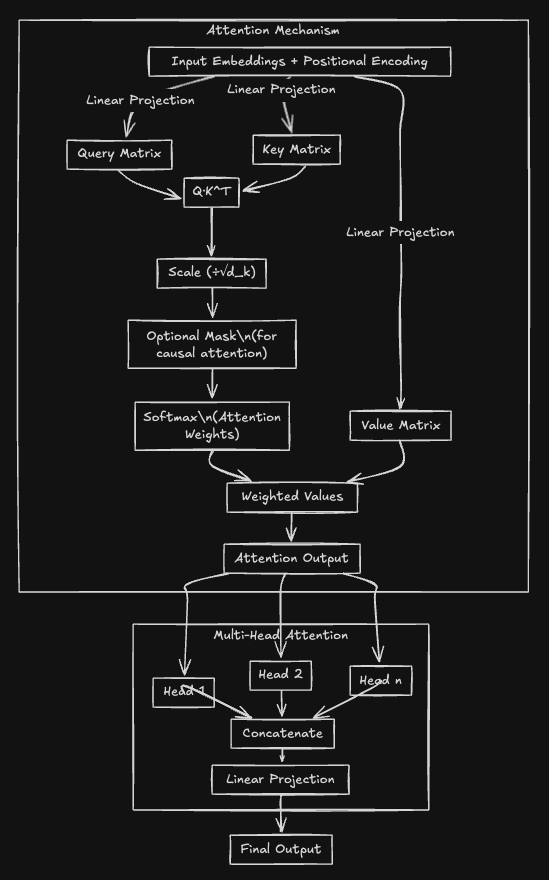

本文从初学者的角度介绍了注意力机制在神经网络中的应用,尤其是其在Transformer架构中的重要性。

传统的RNN和LSTM模型在处理长序列数据时存在局限性,因为它们难以并行处理且难以捕捉远距离的上下文信息。而Transformer通过引入注意力机制解决了这一问题,能够通过权重分配关注输入的不同部分,无论其位置如何。

AI生活指南AI创造营

一篇面向初学者的注意力机制介绍文章

mrinalxdev.github.io/mrinalxblogs/blogs/attention.html

本文从初学者的角度介绍了注意力机制在神经网络中的应用,尤其是其在Transformer架构中的重要性。

传统的RNN和LSTM模型在处理长序列数据时存在局限性,因为它们难以并行处理且难以捕捉远距离的上下文信息。而Transformer通过引入注意力机制解决了这一问题,能够通过权重分配关注输入的不同部分,无论其位置如何。

AI生活指南AI创造营

猜你喜欢

作者最新文章

热门分类

科技TOP

科技最新文章