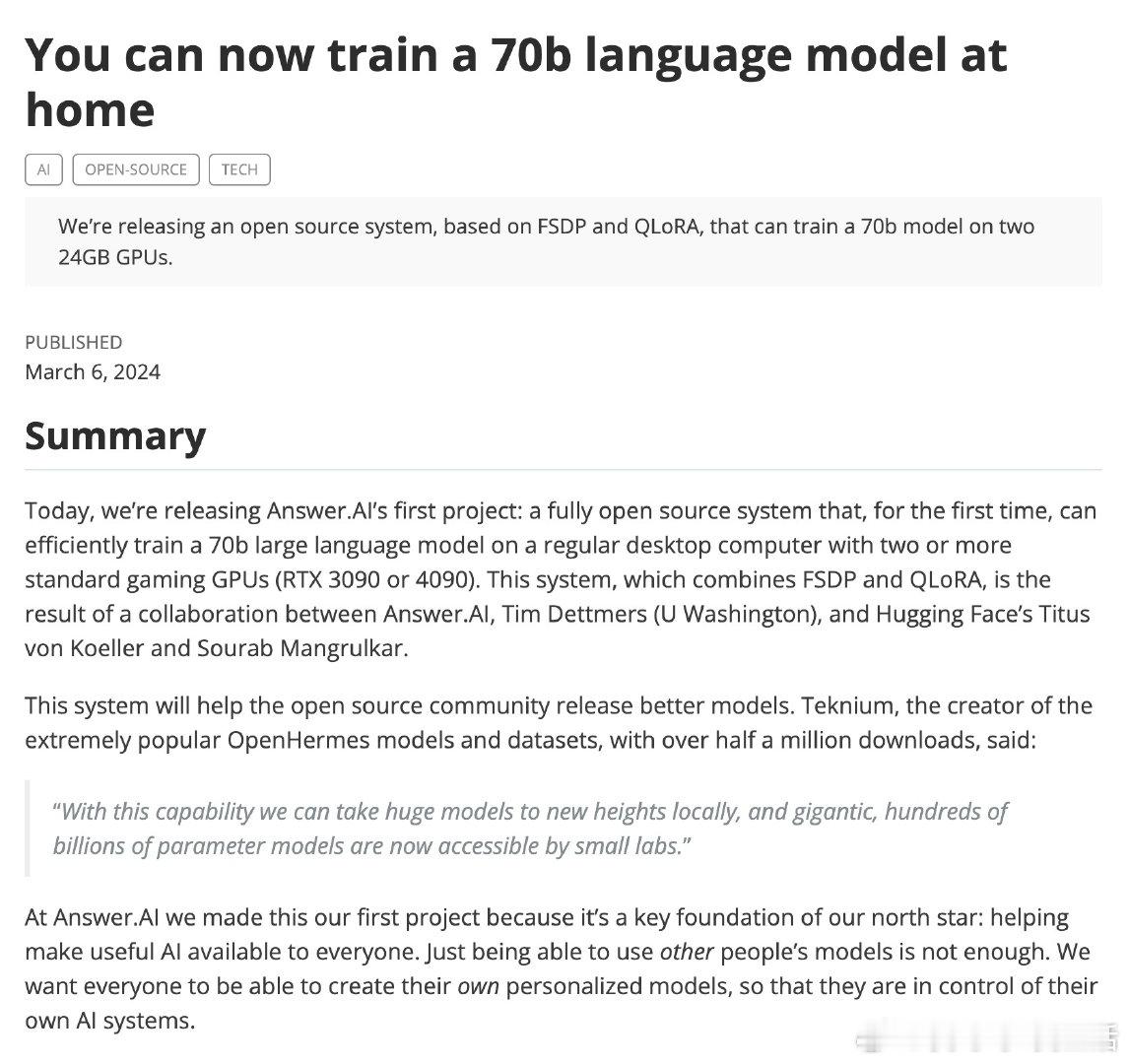

Answer.AI 推出首个开源系统,实现用常规桌面双卡(RTX 3090/4090)高效训练70亿参数大语言模型,彻底打破昂贵数据中心硬件垄断,推动AI训练普惠化。

• 创新结合FSDP(Meta的全碎片数据并行)与QLoRA(4-bit量化+LoRA微调),显著降低训练资源门槛,70b模型可分布式运行于24GB显存的游戏GPU。

• 解决传统大模型训练需数十万美金高端GPU的问题,普通玩家和小型实验室均能负担,推动AI模型个性化与自主研发。

• 采用层级分片、梯度检查点、CPU权重卸载、Flash Attention 2等多项前沿技术,极致优化内存使用与计算效率。

• 深入破解量化训练难题:维护量化状态同步,避免权重重量化,支持跨GPU协同训练,确保训练稳定与精度。

• 开源生态融合Hugging Face PEFT、Transformers、bitsandbytes等库,社区支持强大,便于快速上手与二次开发。

• 展望未来:持续优化批处理大小、序列长度,探索更高效量化方案(如HQQ),推动更大规模模型训练民主化。

• 提供完整训练脚本及文档,支持本地及云端灵活部署(如Runpod租用双3090),助力开发者快速实践。

洞察:硬件性能未必是限制,关键在于算法层面巧妙分片与量化策略,真正实现“用低成本硬件打破大模型训练壁垒”,为AI普及和创新提供底层动力。

详细介绍与代码👉 answer.ai/posts/2024-03-06-fsdp-qlora.html

人工智能 大语言模型 开源AI 机器学习 深度学习 模型训练 量化技术 GPU计算