《Attention sinks from the graph perspective》

从图神经网络(GNN)的视角,重新审视 Transformer 中神秘的“注意力沉降”(Attention Sink)现象。

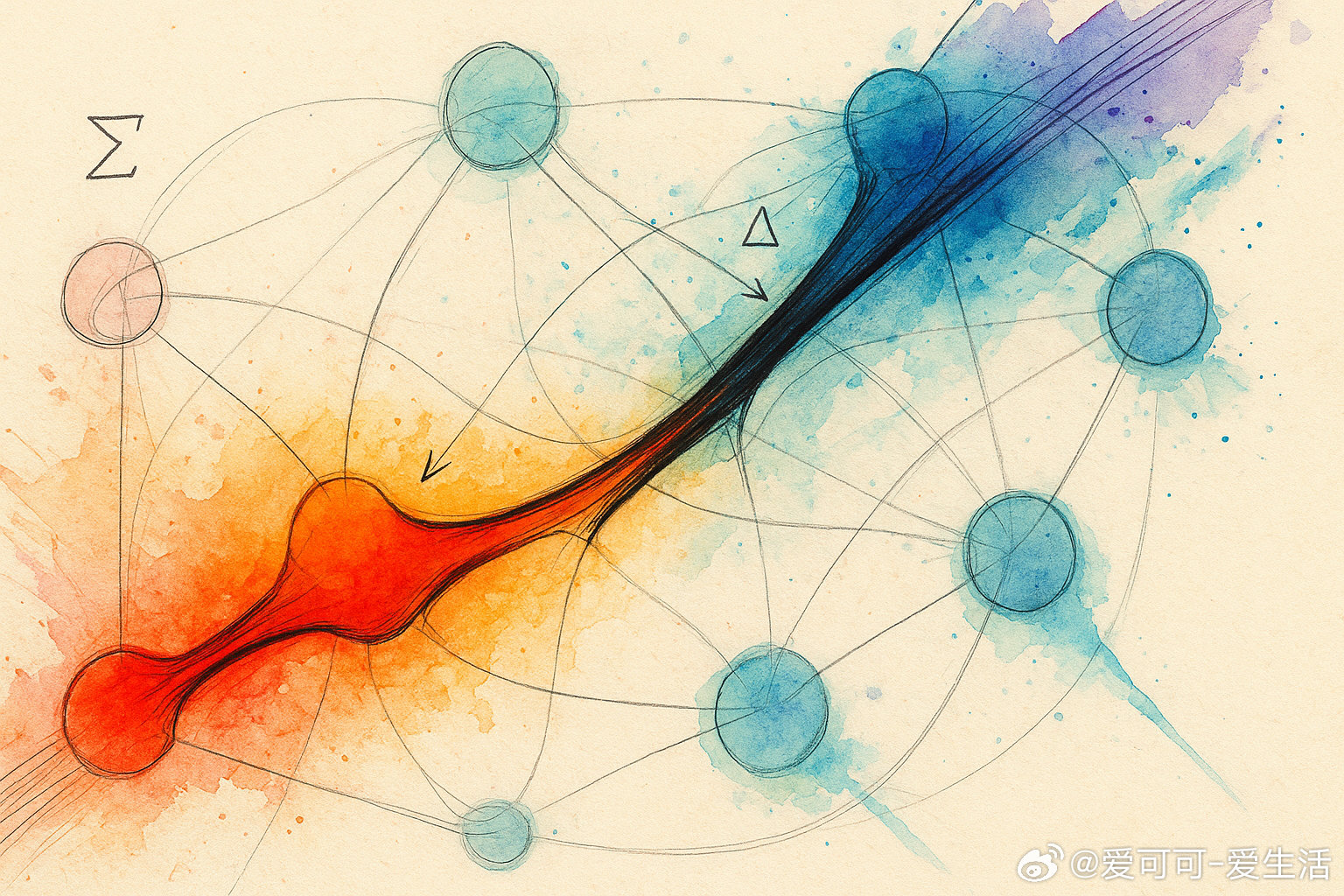

🕸️ 图论新解:将 Transformer 视为一个全连接的图神经网络,其中每个 token 是一个节点,而注意力分数则定义了节点间传递信息的加权有向边。整个模型的核心任务是在这个图上进行高效的信息交换。

🌐 沉降的本质:初始 token(如 [CLS] 或起始符)并非无意义的“垃圾桶”,而是模型自发演化出的“超级节点”(Supernode)。它充当全局信息枢纽,负责高效地聚合序列各处的信息,再将其分发给所有需要的 token。

⚙️ 涌现的效率策略:为避免每对 token 间都进行高成本的直接信息交换,模型自发选择一个节点作为“公共信息池”或“全局工作区”。这是一种解决全局通信难题的涌现策略,而非模型缺陷。

🎯 “智能”与“哑”节点:像 BERT 中的 [CLS] 是一个被明确训练用于聚合信息的“智能”节点;而在许多 Decoder-only 模型中,首个 token 承担了类似的功能,但它是一个未经特殊设计的“哑”节点,模型需要同时学会如何向它写入和从中读取信息。

心得:

- 跨领域视角的威力。将 Transformer 置于 GNN 框架下,许多看似怪异的“黑箱”行为(如注意力沉降)瞬间变得符合第一性原理,其架构的内在逻辑与效率考量也得以显现。

- 复杂系统中的涌现现象。注意力沉降并非被“设计”出来的,而是模型在优化信息流通过程中自发“发现”的最优解之一。这深刻体现了大规模模型在解决根本性通信问题时展现的自组织能力。

- 从“是什么”到“为什么”。优秀的理论模型不仅要描述现象,更要提供一个有解释力的因果框架。将注意力机制等同于图上的信息传递,为我们理解和改进 Transformer 的内部工作机制提供了坚实的理论根基。

详情链接🔗:publish.obsidian.md/the-tensor-throne/Transformers+as+GNNs/Attention+sinks+from+the+graph+perspective

Transformer GNN 人工智能 深度学习 注意力机制