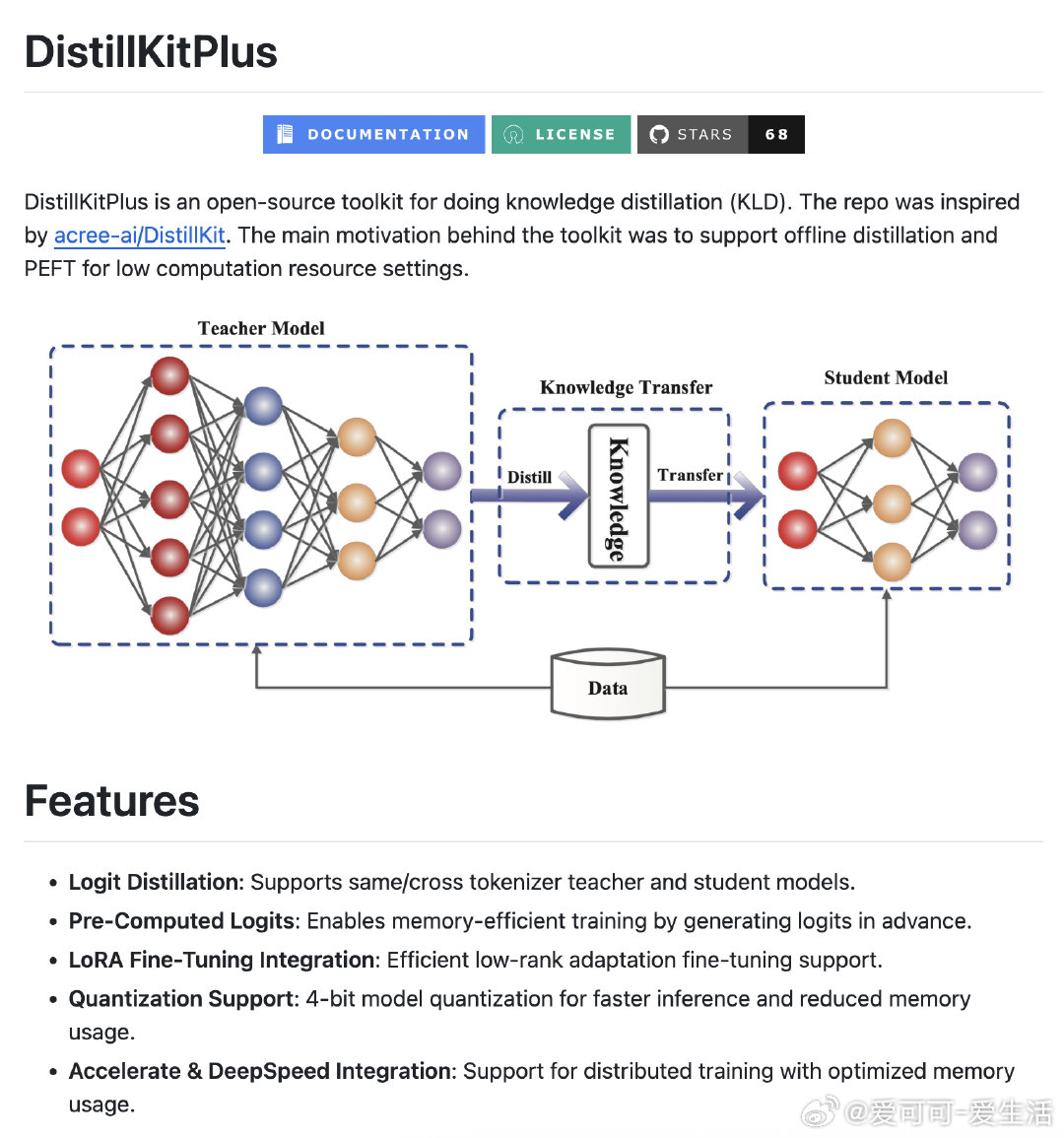

【[68星]DistillKitPlus:为大型语言模型(LLM)提供简单易用、高性能的知识蒸馏工具。亮点:1. 支持离线蒸馏和PEFT,适合低计算资源环境;2. 提供4种损失函数,满足不同蒸馏需求;3. 集成LoRA微调和4位量化,优化模型性能】

'DistillKitPlus is an open-source toolkit for doing knowledge distillation (KLD). The main motivation was to support offline distillation and PEFT for low computation resource settings.'

GitHub: github.com/agokrani/distillKitPlus

知识蒸馏 LLMs 高性能 AI创造营