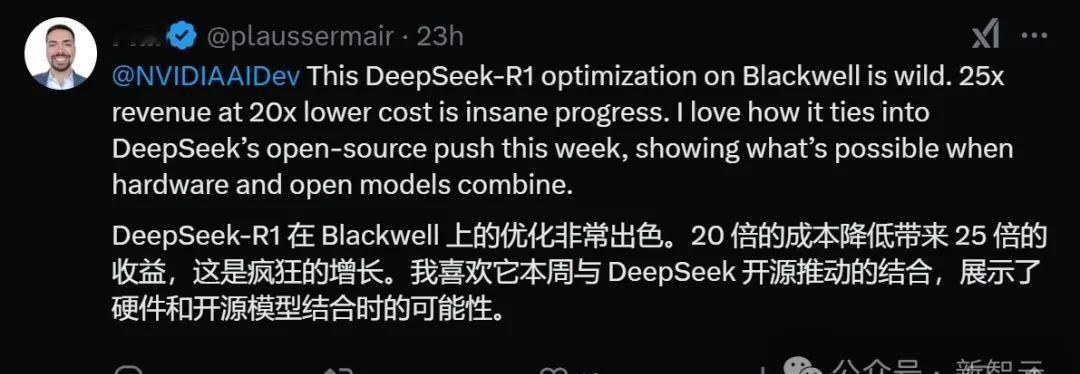

野村-DeepSeek-对中国大语言模型(LLM)价值链的影响 Quick Note 我们于 2 月 26 日举办了第 36 期人工智能专家电话会议,主题为 “DeepSeek 系列:DeepSeek 的创新如何影响中国大语言模型的发展和基础设施价值链”。我们的演讲嘉宾分享了他对 DeepSeek(未上市)大语言模型创新的看法,这些创新有助于提高训练和推理效率,以及它们对人工智能价值链的影响。我们重点总结了以下关键要点: DeepSeek 的技术创新对人工智能价值链的影响 关键创新集中在 PTX 层面的优化,这可以提高 GPU 的利用效率; 这些(PTX 层面的)技术具有很高的复制壁垒,仅对领先的大语言模型公司可行,小公司很难复制; DeepSeek 的开源技术可能有助于加速整个行业的创新,但仍有一些核心技术尚未公开。 硬件平台兼容性 DeepSeek 的创新与英伟达(NVIDIA,股票代码 NVDA US,未评级)的生态系统相关联,并且 PTX 优化是在 Hopper 系统上进行的。对于其他系统,它也需要重新编写; PTX 仍然使用 CUDA API,这无法完全脱离英伟达的生态系统; 国内芯片平台需要独立开发类似的优化技术。 行业竞争格局 由于 DeepSeek 的开源大语言模型,其他大语言模型公司可以追赶上来,并使用更高的数据量和计算能力来训练他们的模型; 国内芯片制造商在训练和推理能力方面仍然落后于全球领先企业,主要依赖政策支持。 未来方向和问题 / 瓶颈 多模态大语言模型是大语言模型发展的下一个重点领域,但关键限制是缺乏高质量的数据; 在内存、通信和计算能力方面的硬件瓶颈将持续存在,而 DeepSeek 通过软件优化提高了效率,但受到硬件能力的限制。

如果说deepseek是给英伟达的当头一棒,那清华团队的ktransformer

【7评论】【52点赞】