什么是AI数据中心?感觉美国上数据中心太急了

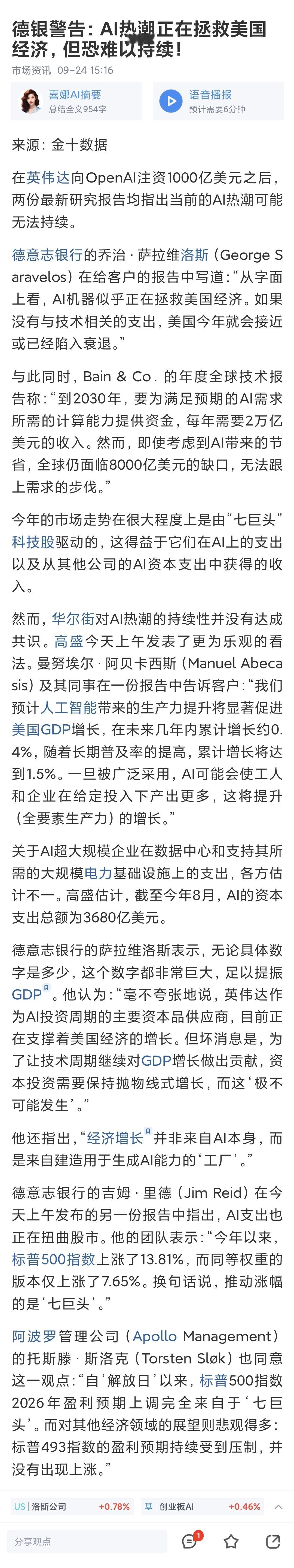

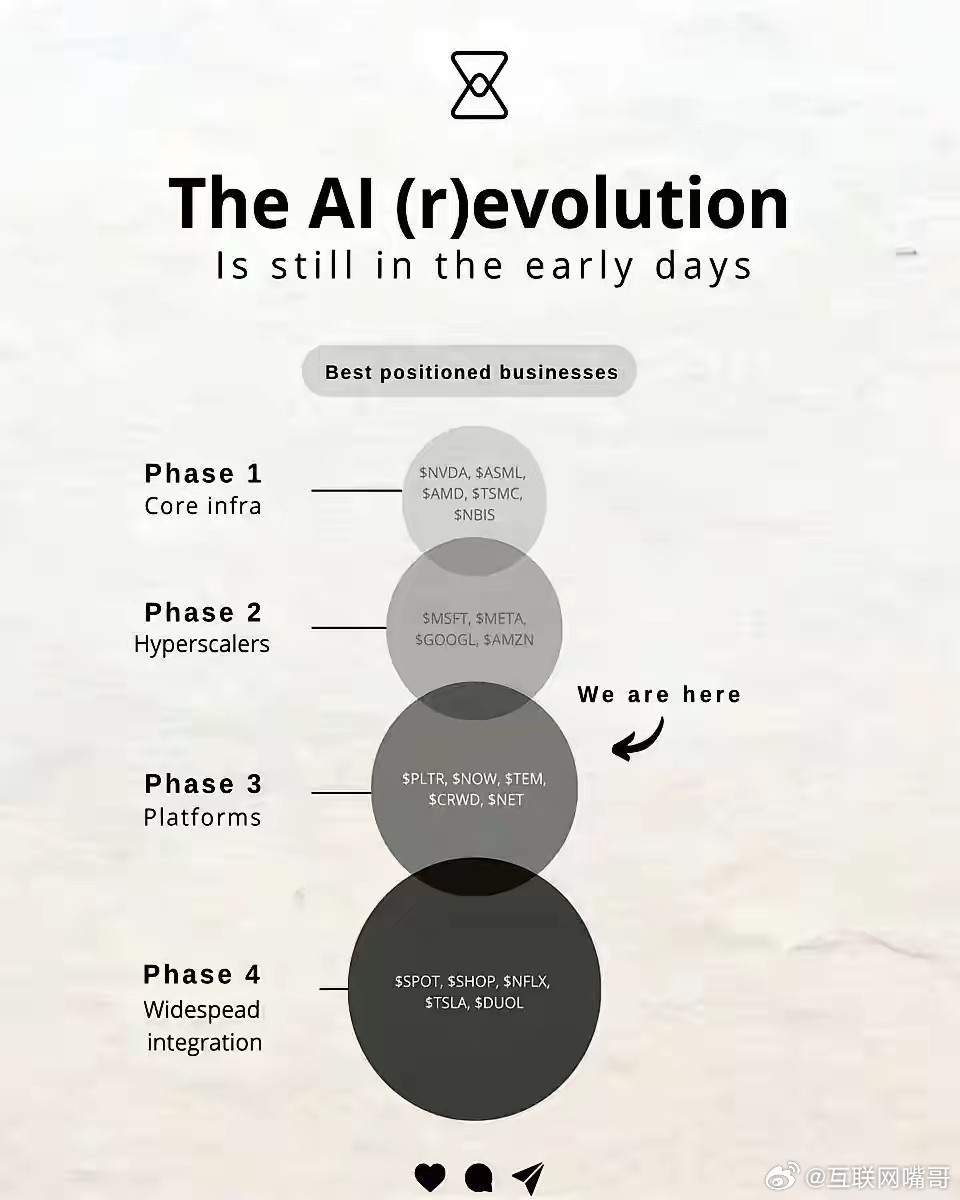

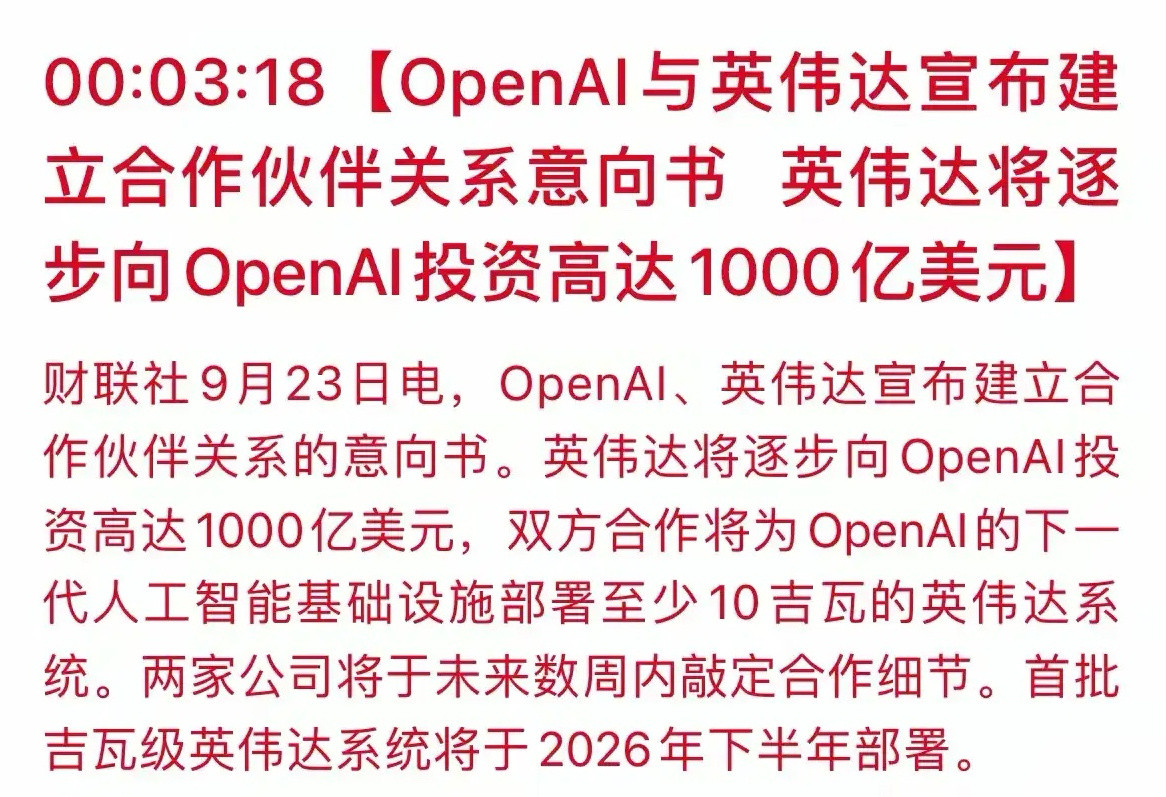

最近美股就是炒AI,炒数据中心。英伟达、甲骨文、OpenAI互相投1000亿美元,就是搞数据中心。现在美国经济增长全部是AI相关投资了,去掉就没有增长。一年要冲上万亿美元AI投资了。注意是AI投资,不是AI产出,AI还没啥产出,比起投资,百亿美元规模的回报可以忽略不计。

以前搞数据存储、云服务的传统数据中心,这是已经得到认可的。大家平时生活的数据都放在上面,APP服务程序也在里面跑。AI数据中心,当然会类似,但也有很多独特之处。

第一点,数据中心以前以CPU整数运算为主,AI数据中心是GPU、TPU、NPU浮点算力为主。很大的区别是,传统数据中心是以数据为核心,CPU负责逻辑,跑点小运算就行。而AI数据中心,数据当然很重要,但更重要的特性是“算”,而且是CPU跑很慢的AI矩阵浮点运算。在程序里,CPU主要逻辑是整数判断,而GPU是做浮点矩阵运算,也有用整数加速的,但基础是浮点数。

第二点,运算功率。CPU跑起来容易,多了也耗能,但没那么吓人。海量GPU里并行搞浮点运算,运算功率要大10倍。一个机柜耗电功率是30-100KW,是过去10-20倍。功率大了,能量总要以什么形势表现出来,发热就厉害,就需要散热。过去是风冷,现在要液冷。

第三点,网络需求。由于AI大模型内部要进行海量的数据传输,也要求快速计算,万卡互联要在卡间、柜间让数据走铜缆、光纤,还需要高速网络芯片。传统数据中心内部网络传输要求没这么高,对外的输出要求高也不难满足。

第四点,应用程序。AI数据中心里就是大模型的训练和推理,而传统数据中心里业务类型很多,ERP、数据库、网站支持等等。

因此,所谓AI数据中心就是大模型训练和推理。训练要对海量数据跑很多轮,推理单次虽然快,但是用户非常多,都需要海量的运算。又因为这个,需要海量GPU、液冷、高速网络。

这一切都是因为大模型,用GPU跑矩阵浮点运算,把给用户的反馈“算出来”。以前我们需要一个信息,用网络搜索下就好了,数据中心直接拿出来就好了,不是算,而是“找”出来的。“找”的没有智能,是资料、链接,人自己再判断怎么用。“算”的加入了AI大模型对用户输入的智能理解,给出了更好的回答。

目前为止,大模型还是需要海量矩阵运算,用这种办法模拟了人类智能。而海量矩阵运算,目前还是基于电子晶体管的芯片架构。人类不是用这种矩阵运算来形成智力的。机器学习是蛮干,用海量矩阵数据结构压缩存储了人类知识结构,模拟人类输出。

大模型是突破,但它不是很完美的突破,需要太多算力、太多能量,一个简单的问题,它要算很多。有时我们用传统搜索就能得到不错的答案,问大模型就会空耗很多算力。

一个不算完美的突破,就可以大规模铺开狂建AI数据中心么?例如,我们在高铁还没掌握自主知识产权时,不可能去规划执行4万亿公里高铁网络,一定是先试点。在新能源电动车效率还不够高的时候,就不会去全面推广,而是补贴促进生态。如果能耗还不行的时候,就大上基建,就是巨大的浪费

现在的大模型,显然还没有定局,还有很大优化空间。应该去搞技术进步,把能模拟人类智能的结构效率提升,而不是押宝海量矩阵运算。等能耗降下来,对计算资源的需求降下来,再去建AI数据中心,较为合理。

以后人类社会的机器智能,是不是依靠这样的AI数据中心?真说不准。说不定是靠无数个机器人内部的小东西就行了,不需要特别多的大数据中心。或者需要AI数据中心,但不是这样机器散热嘶吼吓死人高耗能的,有更好的办法。

美国是因为押宝AI,气氛疯狂了,传统上又不太节省(因为投资的钱也是自己公司赚去了,并不是没有了),所以就冲了。别地都有点不敢,中国都没这么猛,因为买不到GPU,但风格上就是会省钱的。

最后,有可能会发现,无数GPU在发热搞意义不大的矩阵运算,没有为人类生产力作出多大贡献。堆再多GPU也没堆出AGI,没搞出特别大的科学发现。

AI是突破了,但还有缺陷,还需要别的突破。只是现在这样的AI水平,不足以创造经济奇迹,没到大面积铺开的时候,会浪费资源。

![我就说AI代替不了人类吧[doge]](http://image.uczzd.cn/11168637053587929967.jpg?id=0)

pig3head

友商糙节点用爱计算,孝子狂吠孝子体验遥遥领先[赞]