说实话,后台问数据集成的粉丝一直很多,高频问题永远是:

“数据集成到底怎么做才不踩坑?”

“为什么我们做了集成,数据还是没法用?”

听着是不是很熟?

过去5年,我参与过近30家企业的数据集成项目,见过太多因方案选错、流程混乱导致的烂尾案例,也总结出了可复用的数据集成实战方法论。

今天就来讲一讲这套方法,不管你是入门数据工程师,还是技术负责人,都能直接参考。

一、先搞懂:数据集成不是数据搬运

我一直强调,很多人对数据集成的理解偏了,总觉得就是“把A系统数据搬到B系统”,这是典型误区。

专业来说,数据集成是将分散在不同来源、格式、结构的数据,通过统一标准和流程,实现汇聚、清洗、转换和标准化,最终形成可用、可信数据资产的过程。

数据集成的核心价值体现在三点:

打破数据孤岛:打通各部门业务系统壁垒,让数据跨部门流转;

统一数据口径:消除指标歧义,比如统一“客户ID”“订单状态”的格式和定义;

支撑业务决策:标准化数据可直接用于BI分析、客户画像等场景,让数据转化为价值。

二、主流数据集成模式

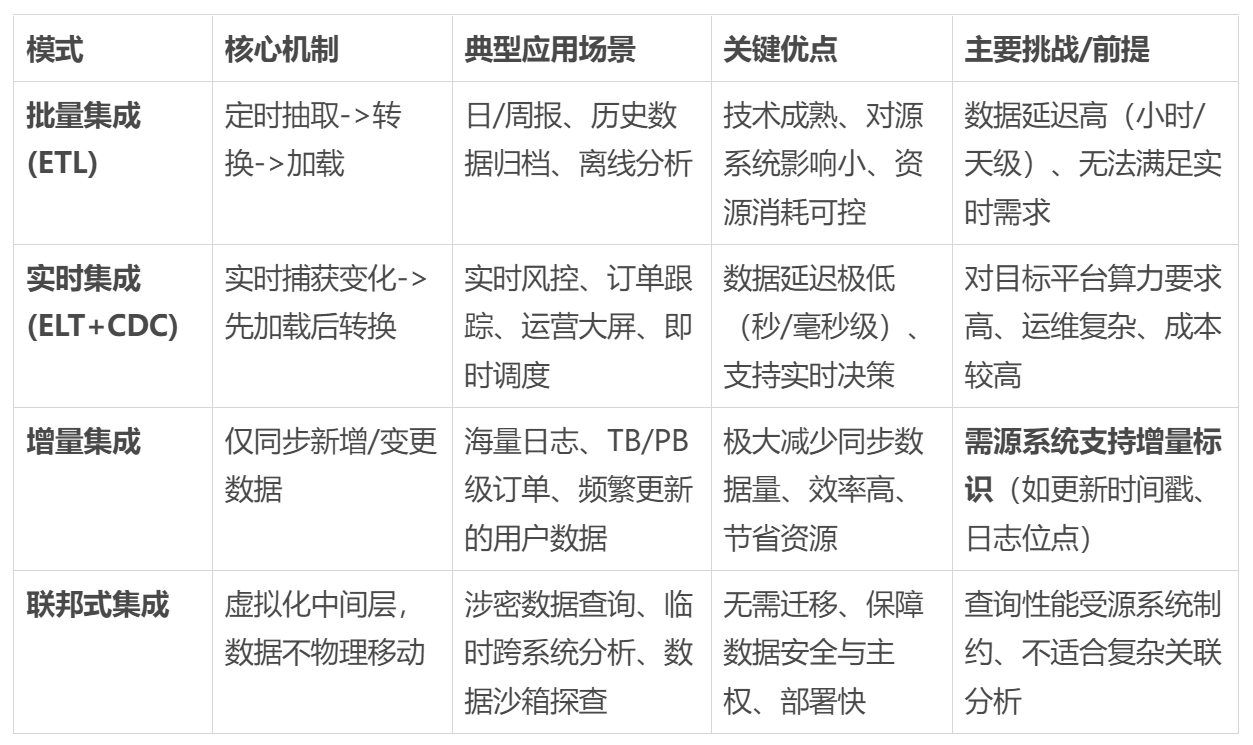

数据集成不是一刀切,4种常用模式对应不同场景,直接对号入座:

1. 批量集成(ETL模式)

最传统成熟的模式,核心流程“抽取-转换-加载”,说白了就是先抽源系统数据,中间节点完成清洗去重,再加载到目标系统。

我早期做的制造企业月度生产数据汇总,就是每天凌晨抽MES和库存系统数据,统一格式后导入数据仓库。

适合非实时批量处理(如日/周报表、历史归档),优势是逻辑成熟、对源系统性能影响小,缺点是数据有延迟,满足不了实时需求。

2. 实时集成(ELT+CDC模式)

现在很多业务要实时数据,这套方案就派上用场了。

简单来说,先把源系统数据直接加载到目标平台,再在平台内转换,同时用CDC技术实时捕获数据新增、修改、删除操作。

适合实时风控、即时订单调度等场景,数据延迟秒级,但对目标平台计算能力和运维成本要求高,中小企业要结合预算考虑。

3. 增量集成

最近我发现,不少企业数据量涨到TB/PB级,全量集成扛不住,增量集成就成了最优解。

核心逻辑是只同步新增或变更数据,而非全量抽取。

适合数据量大、更新频繁的系统(如用户日志、海量订单),省资源、效率高,但需要源系统支持增量标识,你公司的源系统能满足吗?

4. 联邦式集成

这种模式很多人没接触过。简单来说,数据不用物理迁移,通过统一接口和查询引擎实现逻辑访问,相当于用“中间层”跨系统调取数据。

适合涉密数据、临时跨系统查询场景,无需迁移数据,但查询性能受源系统影响大,不适合大规模分析。

三、数据集成落地5个关键步骤

选对模式只是开始,落地要按流程推进,5个核心步骤每步都有讲究:

1. 前期调研

用过来人的经验告诉你,这步省了必翻车。

我见过不少团队脑子一热开发,结果接口权限不够、格式不兼容,只能返工。

调研要明确三点:

数据源类型(关系库、非关系库、日志、API等);

数据体量和更新频率(每日新增量、峰值时段);

业务需求(使用场景、实时性和数据质量要求)。

建议做数据源调研表,记录系统负责人、字段、接口文档、权限,避免后续沟通成本。

2. 制定数据标准

这是集成核心。

之前我看过一个项目,财务和销售系统对“回款金额”定义不同(财务算到账、销售算开票),导致数据偏差超20%,项目停滞一周。这种口径问题你是不是也见过?

制定标准要聚焦:

字段标准(命名、类型、长度,如“客户编号”统一为10位数字字符串);

指标标准(计算逻辑,如“销售毛利率=(收入-成本)/收入×100%”);

质量标准(完整性、准确性阈值,如手机号完整率≥95%),务必和业务部门确认。

3. 方案选型与开发

说实话,我第一次做项目盲目追高大上工具,结果和技术栈不兼容,反而拖慢进度。

工具选择要结合技术栈和预算,我之前反复讲过,这里就不展开了。

开发重点关注转换逻辑(缺失值填充、重复数据去重、异常数据过滤),要写进文档留痕。

4. 测试验证

不过这里有个坑是,很多人把测试当流程,抽几条数据看看就完事,上线后问题百出。你敢保证上线后数据没问题吗?

我通常做三层测试:

功能测试——验证抽取、转换、加载是否符合预期;

数据质量测试——检查字段格式、指标计算是否达标;

性能测试——模拟峰值场景,测试吞吐量和延迟。

三层都过才能上线。

5. 运维监控

最近我发现,不少企业上线后就不管了,觉得“能跑就行”,结果数据延迟、错误堆积,得不偿失,对不对?

我做项目都会搭建这一整套运维体系:

实时监控数据抽取成功率、转换错误率、加载延迟等核心指标;

同时设置阈值告警,比如数据延迟超过 10 分钟、错误率超过 1% 时,自动推送告警信息到技术群;

还有每周对集成任务进行巡检,清理冗余任务,优化转换逻辑,保障系统性能。

四、注意要点

用过来人的经验告诉你,这4个高频坑能绕就绕:

1. 忽略源系统稳定性

有些源系统接口频繁变更字段或协议,导致集成任务频繁失败。

你有没有遇到过接口突然变更导致任务全挂的情况?

建议提前约定变更通知机制,预留兼容方案。

2. 过度追求实时性

不是所有业务都需要“秒级同步”吧?比如月度财务报表,批量集成完全够用,盲目做实时集成只会增加成本和运维压力。

做之前问问自己:这个业务真的需要实时数据吗?延迟几小时有影响吗?

3. 不重视数据安全

集成涉及客户手机号、核心营收等敏感数据,泄露后果不堪设想。

这个风险不用我多说了吧?一定要做数据脱敏(如隐藏手机号部分数字)和权限管控。

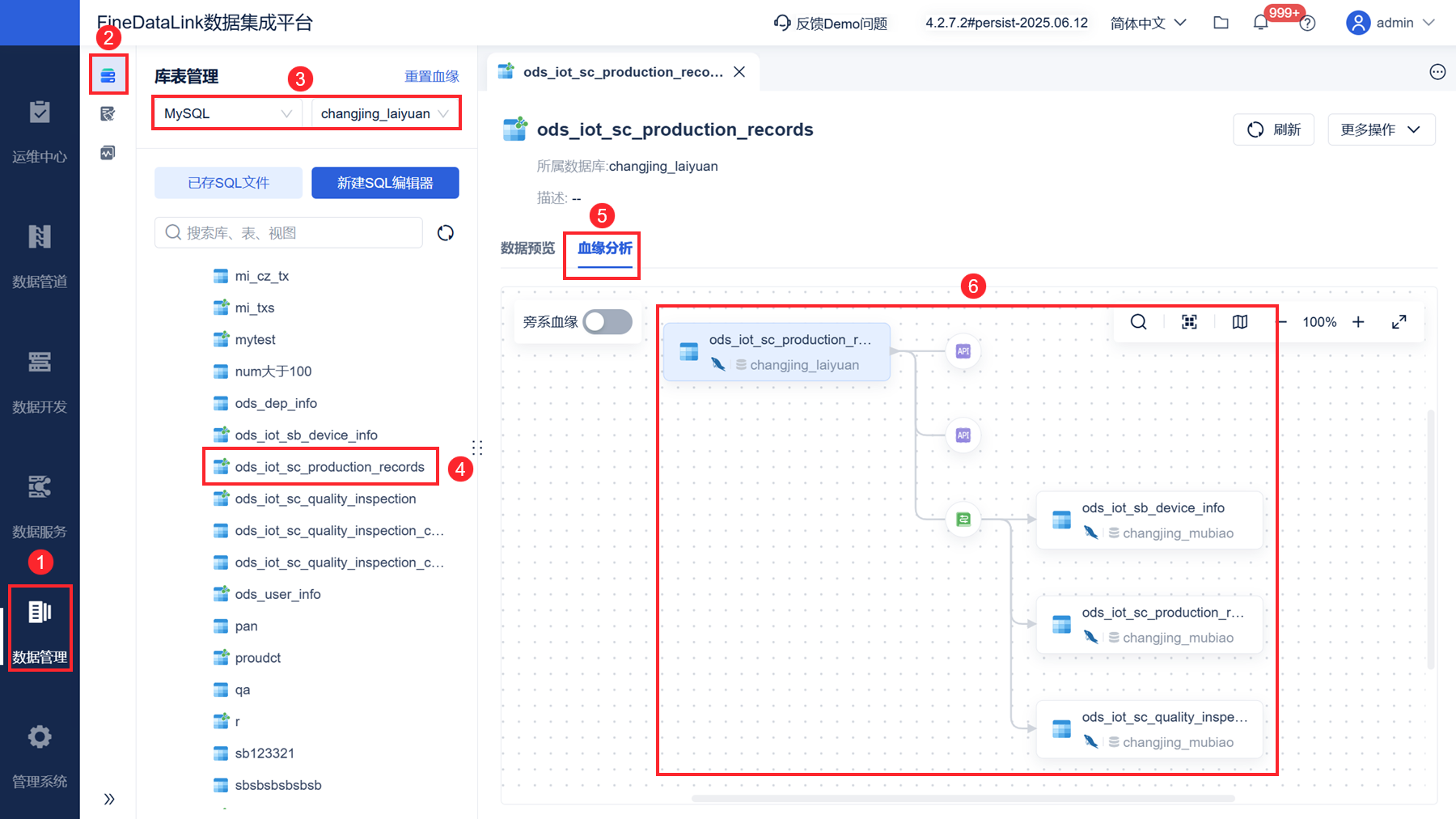

4. 缺乏数据血缘管理

数据经过多轮转换,出问题很难定位根源,只能一步步排查,非常耗时。

数据出错时,你能快速找到问题所在吗?

建议搭建数据血缘图谱,清晰展示数据流转路径。

这里可以借助数据集成工具,例如我用的FineDataLink就提供了可视化的数据血缘分析功能,能自动追踪字段级的数据来源和转换过程,排查效率提升很明显。

五、落地建议与未来趋势

不过话说回来,不同规模企业的落地思路不一样:

中小企业:先从核心业务批量集成入手(如整合销售和财务数据),用开源工具搭基础体系,积累经验后再扩展;

中大型企业:优先搭建统一数据集成平台,结合云原生和低代码工具提升效率,做好数据治理和安全管控;

集团型企业:采用“中台化”思路,搭建数据集成中台,实现全集团数据统一汇聚和分发。

数据集成不是一蹴而就的事,而是持续优化的过程。

如果你正准备启动项目,不妨先梳理公司数据源分布,对照文中模式选对方案,这是落地的第一步。

![都在传Nova15系列1999起[思考]显然不太可能,1999起售那不是太香了[](http://image.uczzd.cn/225855397363515671.jpg?id=0)